🚀 WizardMath:通過強化進化指令(RLEIF)增強大語言模型的數學推理能力

WizardMath是一個藉助強化進化指令(RLEIF)來提升大語言模型數學推理能力的項目。它在數學問題解決上表現出色,能為用戶提供高效準確的數學推理結果。

🚀 快速開始

你可以通過以下鏈接快速瞭解和使用WizardMath:

✨ 主要特性

最新模型發佈

- [12/19/2023] 🔥 發佈了基於Mistral - 7B訓練的 WizardMath - 7B - V1.1,這是目前最優的7B數學大語言模型,在GSM8k上達到 83.2 pass@1,在MATH上達到 33.0 pass@1。

- [12/19/2023] 🔥 WizardMath - 7B - V1.1 在GSM8K pass@1上超越了 ChatGPT 3.5、Gemini Pro、Mixtral MOE 和 Claude Instant。

- [12/19/2023] 🔥 WizardMath - 7B - V1.1 在MATH pass@1上與 ChatGPT 3.5、Gemini Pro 相當,並且超越了 Mixtral MOE。

模型對比

與其他開源7B規模數學大語言模型對比

| 模型 |

GSM8k Pass@1 |

MATH Pass@1 |

| MPT - 7B |

6.8 |

3.0 |

| Llama 1 - 7B |

11.0 |

2.9 |

| Llama 2 - 7B |

12.3 |

2.8 |

| Yi - 6b |

32.6 |

5.8 |

| Mistral - 7B |

37.8 |

9.1 |

| Qwen - 7b |

47.8 |

9.3 |

| RFT - 7B |

50.3 |

-- |

| MAmmoTH - 7B (COT) |

50.5 |

10.4 |

| WizardMath - 7B - V1.0 |

54.9 |

10.7 |

| Abel - 7B - 001 |

59.7 |

13 |

| MetaMath - 7B |

66.5 |

19.8 |

| Arithmo - Mistral - 7B |

74.7 |

25.3 |

| MetaMath - Mistral - 7B |

77.7 |

28.2 |

| Abel - 7B - 002 |

80.4 |

29.5 |

| WizardMath - 7B - V1.1 |

83.2 |

33.0 |

與大型開源(30B ~ 70B)大語言模型對比

| 模型 |

GSM8k Pass@1 |

MATH Pass@1 |

| Llemma - 34B |

51.5 |

25.0 |

| Minerva - 62B |

52.4 |

27.6 |

| Llama 2 - 70B |

56.8 |

13.5 |

| DeepSeek 67B |

63.4 |

-- |

| Gork 33B |

62.9 |

23.9 |

| MAmmoTH - 70B |

72.4 |

21.1 |

| Yi - 34B |

67.9 |

15.9 |

| Mixtral 8x7B |

74.4 |

28.4 |

| MetaMath - 70B |

82.3 |

26.6 |

| WizardMath - 7B - V1.1 |

83.2 |

33.0 |

與其他大語言模型對比(WizardMath - V1.0)

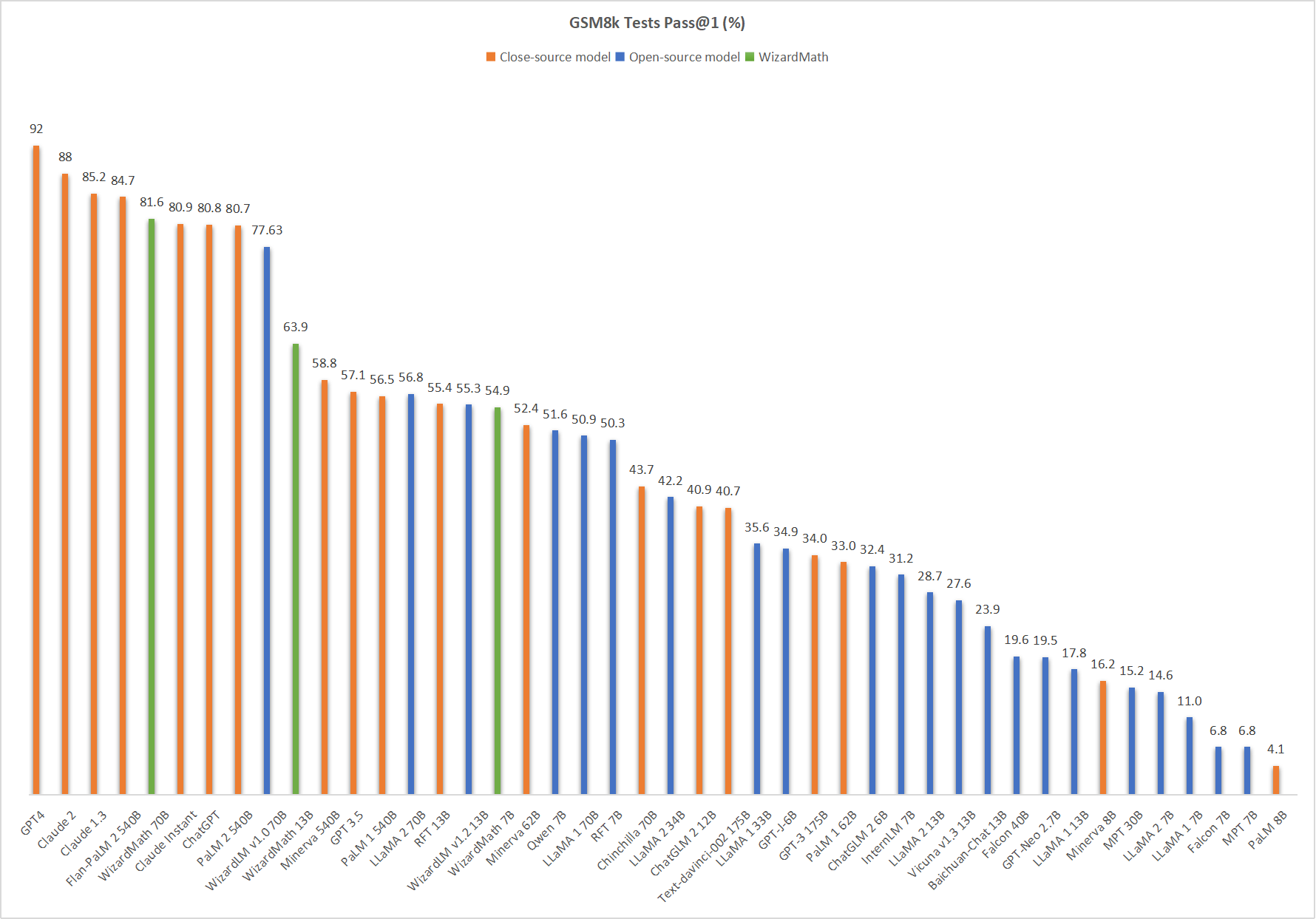

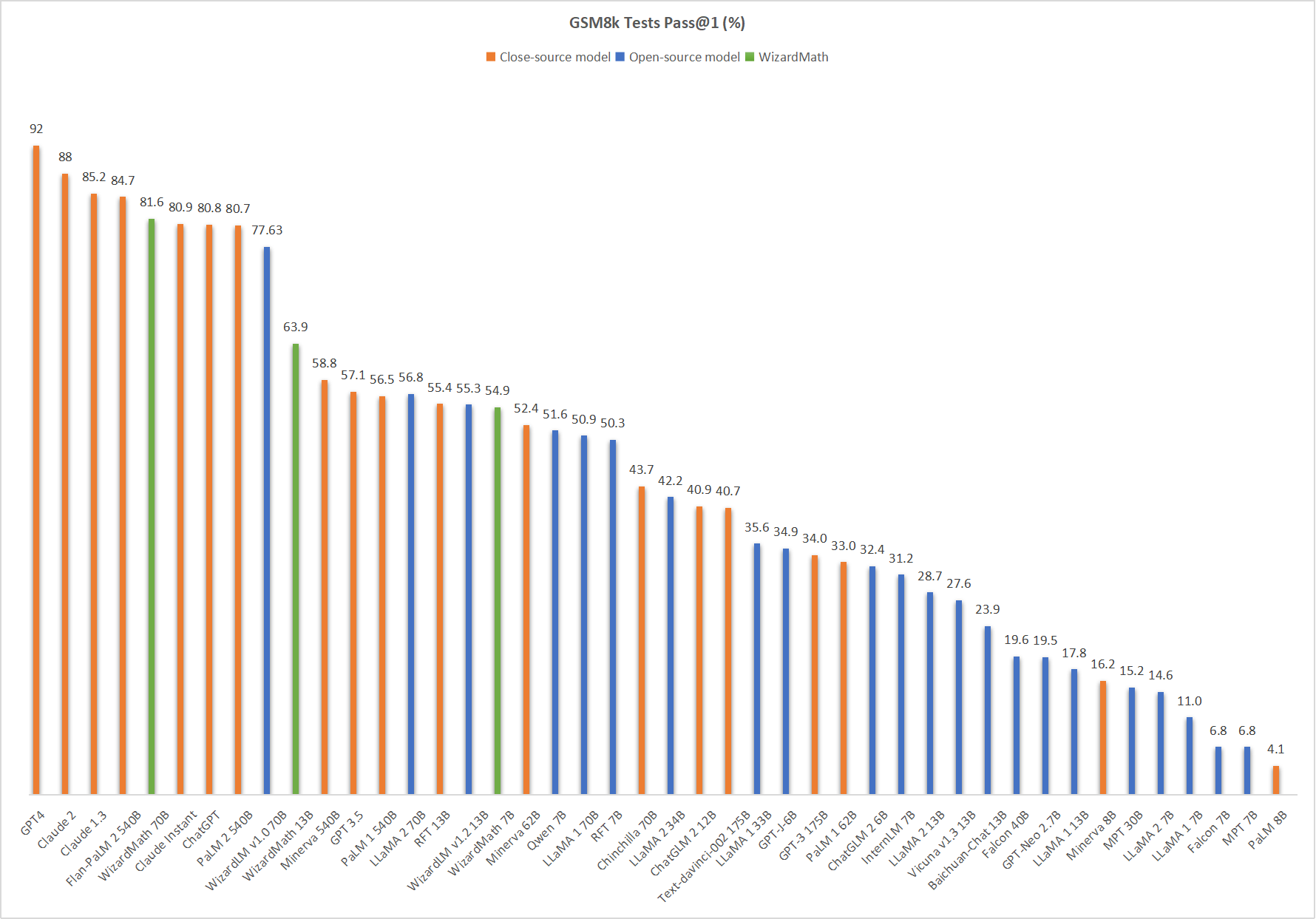

🔥 下圖顯示,我們的 WizardMath - 70B - V1.0 在該基準測試中排名第五,超越了ChatGPT(81.6 vs. 80.8)、Claude Instant(81.6 vs. 80.9)、PaLM 2 540B(81.6 vs. 80.7)。

數據汙染檢查

在模型訓練前,我們仔細嚴格地檢查了所有訓練數據,並使用多種去重方法來驗證和防止GSM8k和MATH測試集的數據洩露。

| 模型 |

檢查點 |

論文 |

MT - Bench |

AlpacaEval |

GSM8k |

HumanEval |

許可證 |

| WizardLM - 70B - V1.0 |

🤗 HF鏈接 |

📃 即將發佈 |

7.78 |

92.91% |

77.6% |

50.6 pass@1 |

Llama 2許可證 |

| WizardLM - 13B - V1.2 |

🤗 HF鏈接 |

|

7.06 |

89.17% |

55.3% |

36.6 pass@1 |

Llama 2許可證 |

| WizardLM - 13B - V1.1 |

🤗 HF鏈接 |

|

6.76 |

86.32% |

|

25.0 pass@1 |

非商業用途 |

| WizardLM - 30B - V1.0 |

🤗 HF鏈接 |

|

7.01 |

|

|

37.8 pass@1 |

非商業用途 |

| WizardLM - 13B - V1.0 |

🤗 HF鏈接 |

|

6.35 |

75.31% |

|

24.0 pass@1 |

非商業用途 |

| WizardLM - 7B - V1.0 |

🤗 HF鏈接 |

📃 WizardLM |

|

|

|

19.1 pass@1 |

非商業用途 |

📚 詳細文檔

模型系統提示使用說明

❗模型系統提示使用說明:

請嚴格使用與我們相同的系統提示,我們不保證 量化版本 的準確性。

默認版本:

"Below is an instruction that describes a task. Write a response that appropriately completes the request.\n\n### Instruction:\n{instruction}\n\n### Response:"

思維鏈(CoT)版本:(❗ 對於 簡單 數學問題,我們不建議使用CoT提示。)

"Below is an instruction that describes a task. Write a response that appropriately completes the request.\n\n### Instruction:\n{instruction}\n\n### Response: Let's think step by step."

推理演示腳本

我們在 這裡 提供了WizardMath推理演示代碼。

數據集相關說明

❗關於數據集的常見問題:

最近,我們整個組織的代碼、數據和模型的開源政策和規定有了明顯變化。儘管如此,我們仍努力先開放了模型權重,但數據涉及更嚴格的審核,正在與我們的法律團隊審核中。我們的研究人員無權擅自公開發布。感謝您的理解。

📄 許可證

本項目使用Llama2許可證。

📚 引用

如果您使用了本倉庫中的數據、方法或代碼,請引用本倉庫:

@article{luo2023wizardmath,

title={WizardMath: Empowering Mathematical Reasoning for Large Language Models via Reinforced Evol-Instruct},

author={Luo, Haipeng and Sun, Qingfeng and Xu, Can and Zhao, Pu and Lou, Jianguang and Tao, Chongyang and Geng, Xiubo and Lin, Qingwei and Chen, Shifeng and Zhang, Dongmei},

journal={arXiv preprint arXiv:2308.09583},

year={2023}

}

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語