🚀 ⚛️ Q 模型:優化增強量化推理能力

該模型經過特別優化,旨在提升量化推理性能,推薦在 3 至 8 位量化場景中使用。

🚀 快速開始

項目相關鏈接

✨ 主要特性

此模型專門針對量化推理性能進行了優化,能在 3 至 8 位量化場景中表現出色。

📚 詳細文檔

模型信息

| 屬性 |

詳情 |

| 基礎模型 |

Qwen/QwQ - 32B |

| 上下文長度 |

200K Tokens |

| 許可證 |

Apache 2.0 |

提示詞格式

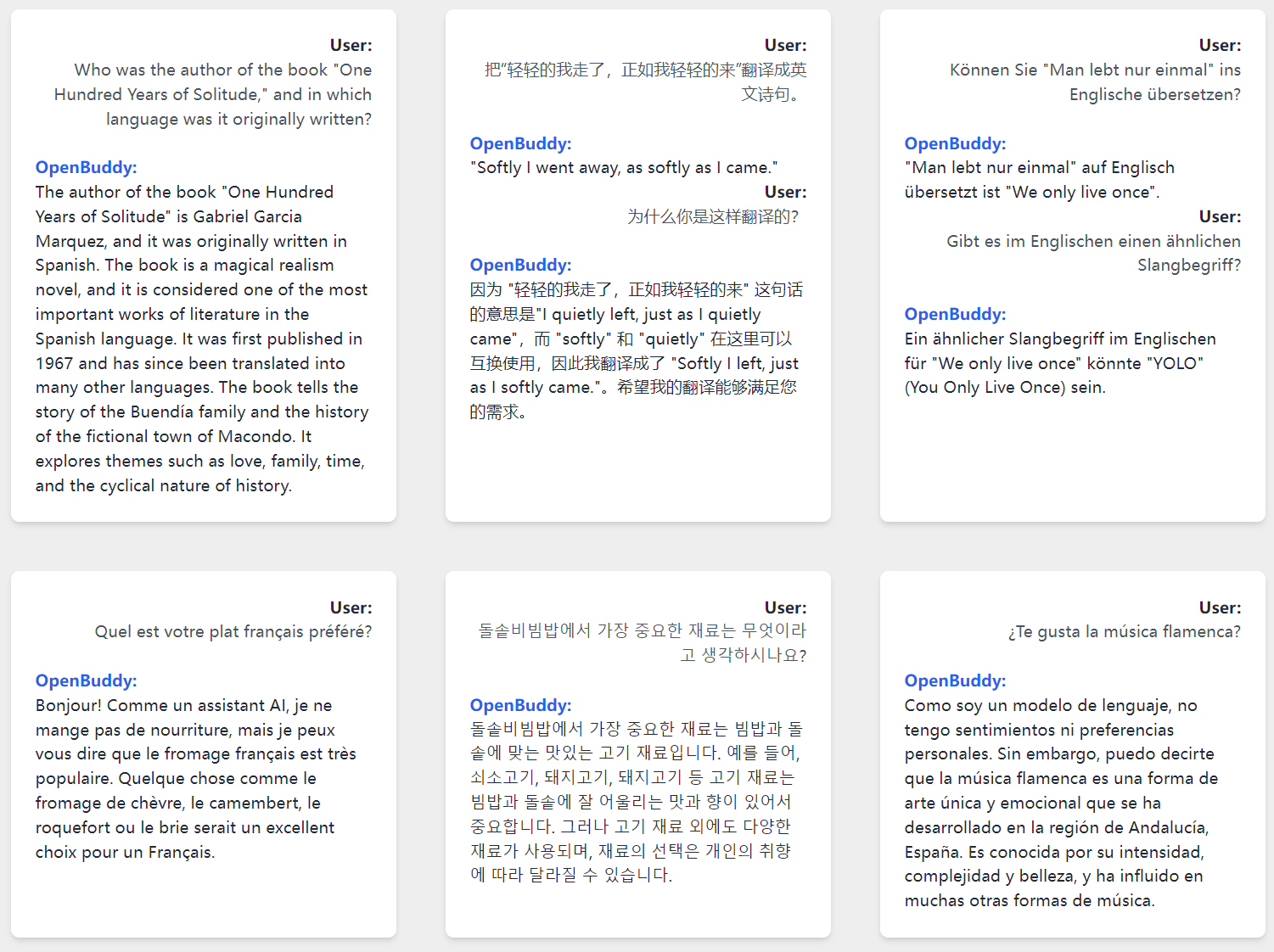

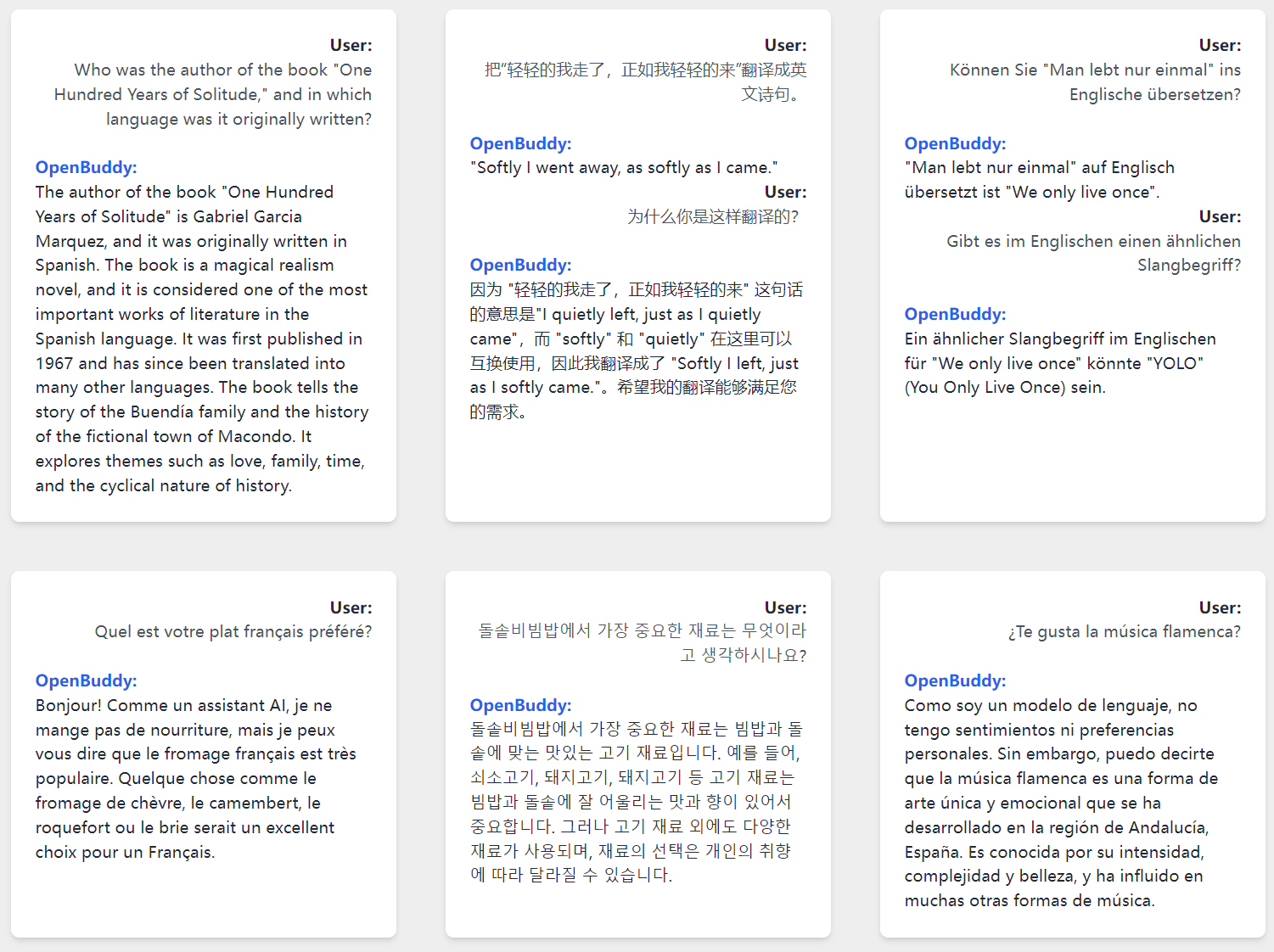

建議使用 transformers 庫中的快速分詞器,該分詞器在 transformers 和 vllm 庫中默認啟用。其他實現(包括 sentencepiece)可能無法按預期工作,尤其是對於 <|role|>、<|says|> 和 <|end|> 等特殊標記。

<|role|>system<|says|>You(assistant) are a helpful, respectful and honest INTP - T AI Assistant named Buddy. You are talking to a human(user).

Always answer as helpfully and logically as possible, while being safe. Your answers should not include any harmful, political, religious, unethical, racist, sexist, toxic, dangerous, or illegal content. Please ensure that your responses are socially unbiased and positive in nature.

You cannot access the internet, but you have vast knowledge, cutoff: 2023 - 04.

You are trained by OpenBuddy team, (https://openbuddy.ai, https://github.com/OpenBuddy/OpenBuddy), not related to GPT or OpenAI.<|end|>

<|role|>user<|says|>History input 1<|end|>

<|role|>assistant<|says|>History output 1<|end|>

<|role|>user<|says|>History input 2<|end|>

<|role|>assistant<|says|>History output 2<|end|>

<|role|>user<|says|>Current input<|end|>

<|role|>assistant<|says|>

這種格式也在 tokenizer_config.json 中定義,這意味著您可以直接使用 vllm 部署類似 OpenAI 的 API 服務。更多信息,請參考 vllm 文檔。

📄 許可證

本項目採用 Apache 2.0 許可證。

⚠️ 免責聲明

所有 OpenBuddy 模型均存在固有的侷限性,可能產生錯誤的、有害的、冒犯性的或其他不良的輸出。用戶在關鍵或高風險場景中應謹慎行事,不要使用這些模型,以免導致人身傷害、財產損失或重大損失。此類場景的例子包括但不限於醫療領域、可能導致傷害的軟硬件系統的控制以及進行重要的財務或法律決策。

OpenBuddy 按“原樣”提供,不附帶任何種類的明示或暗示的保證,包括但不限於適銷性、特定目的的適用性和非侵權的暗示保證。在任何情況下,作者、貢獻者或版權所有者均不對因軟件或使用或其他軟件交易而產生的任何索賠、損害賠償或其他責任(無論是合同、侵權還是其他原因)承擔責任。

使用 OpenBuddy 即表示您同意這些條款和條件,並承認您瞭解其使用可能帶來的潛在風險。您還同意賠償並使作者、貢獻者和版權所有者免受因您使用 OpenBuddy 而產生的任何索賠、損害賠償或責任的影響。

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語