🚀 Swin Transformer v2(大型模型)

Swin Transformer v2是一個在圖像分類領域表現出色的模型。它先在ImageNet - 21k數據集上進行預訓練,然後在分辨率為384x384的ImageNet - 1k數據集上進行微調,能有效處理圖像分類等視覺任務。

🚀 快速開始

本模型可用於圖像分類任務。你可以在模型中心查找針對你感興趣任務的微調版本。

以下是使用該模型將COCO 2017數據集中的圖像分類為1000個ImageNet類之一的示例代碼:

from transformers import AutoImageProcessor, AutoModelForImageClassification

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

processor = AutoImageProcessor.from_pretrained("microsoft/swinv2-large-patch4-window12to24-192to384-22kto1k-ft")

model = AutoModelForImageClassification.from_pretrained("microsoft/swinv2-large-patch4-window12to24-192to384-22kto1k-ft")

inputs = processor(images=image, return_tensors="pt")

outputs = model(**inputs)

logits = outputs.logits

predicted_class_idx = logits.argmax(-1).item()

print("Predicted class:", model.config.id2label[predicted_class_idx])

更多代碼示例請參考文檔。

✨ 主要特性

模型基礎特性

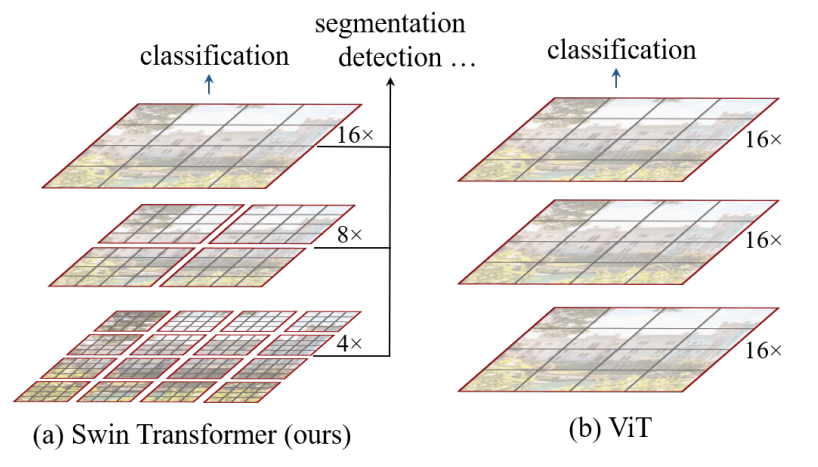

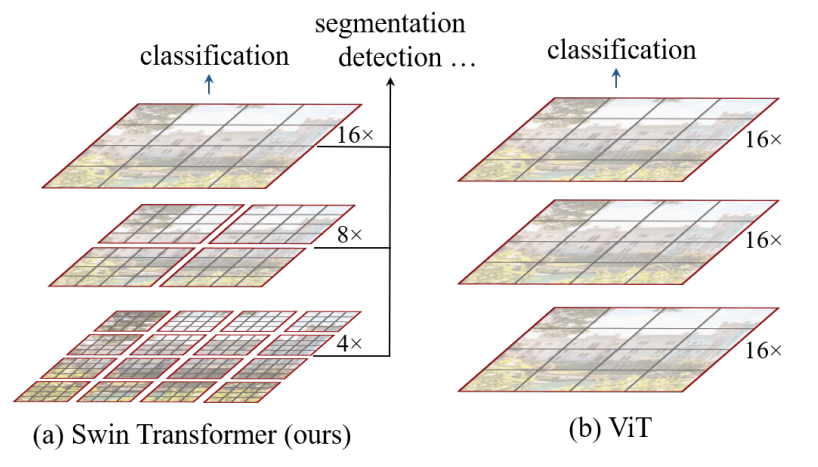

Swin Transformer是一種視覺Transformer。它通過在更深的層中合併圖像塊(灰色部分)來構建分層特徵圖,並且由於僅在每個局部窗口(紅色部分)內計算自注意力,因此對輸入圖像大小具有線性計算複雜度。這使得它可以作為圖像分類和密集識別任務的通用主幹網絡。相比之下,之前的視覺Transformer只能生成單一低分辨率的特徵圖,並且由於全局計算自注意力,對輸入圖像大小具有二次計算複雜度。

Swin Transformer v2的改進

Swin Transformer v2主要有3點改進:

- 採用殘差後歸一化方法結合餘弦注意力,提高訓練穩定性;

- 引入對數間隔連續位置偏置方法,有效將低分辨率圖像預訓練的模型遷移到高分辨率輸入的下游任務;

- 採用自監督預訓練方法SimMIM,減少對大量標記圖像的需求。

來源

📚 詳細文檔

預期用途和限制

你可以使用原始模型進行圖像分類。

BibTeX引用和引用信息

@article{DBLP:journals/corr/abs-2111-09883,

author = {Ze Liu and

Han Hu and

Yutong Lin and

Zhuliang Yao and

Zhenda Xie and

Yixuan Wei and

Jia Ning and

Yue Cao and

Zheng Zhang and

Li Dong and

Furu Wei and

Baining Guo},

title = {Swin Transformer {V2:} Scaling Up Capacity and Resolution},

journal = {CoRR},

volume = {abs/2111.09883},

year = {2021},

url = {https://arxiv.org/abs/2111.09883},

eprinttype = {arXiv},

eprint = {2111.09883},

timestamp = {Thu, 02 Dec 2021 15:54:22 +0100},

biburl = {https://dblp.org/rec/journals/corr/abs-2111-09883.bib},

bibsource = {dblp computer science bibliography, https://dblp.org}

}

📄 許可證

本模型採用Apache - 2.0許可證。

| 屬性 |

詳情 |

| 模型類型 |

視覺Transformer(Swin Transformer v2) |

| 訓練數據 |

ImageNet - 21k、ImageNet - 1k |

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語