🚀 Controlnet - v1.1 - 深度版本

Controlnet v1.1是一款用於圖像生成的模型,它在Controlnet v1.0的基礎上進行了升級,可與Stable Diffusion結合,通過額外條件控制圖像生成,為圖像創作帶來更多可能性。

🚀 快速開始

Controlnet v1.1是Controlnet v1.0的繼任模型,由Lvmin Zhang發佈於lllyasviel/ControlNet-v1-1。

此檢查點是將原始檢查點轉換為diffusers格式後的版本,它可以與Stable Diffusion結合使用,例如runwayml/stable-diffusion-v1-5。

更多詳細信息,請查看🧨 Diffusers文檔。

ControlNet是一種神經網絡結構,通過添加額外條件來控制擴散模型。

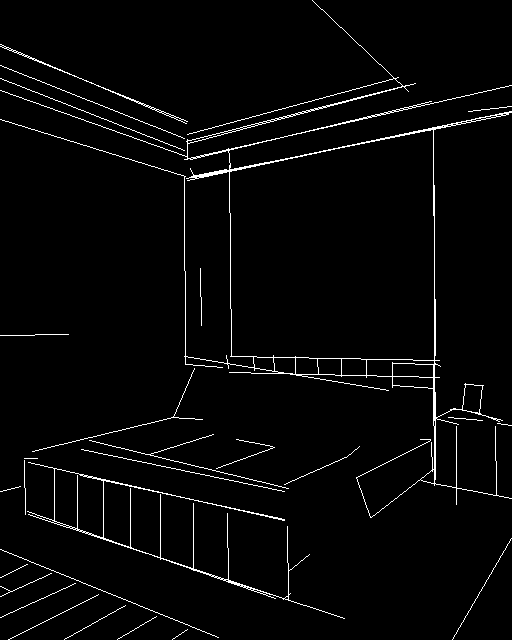

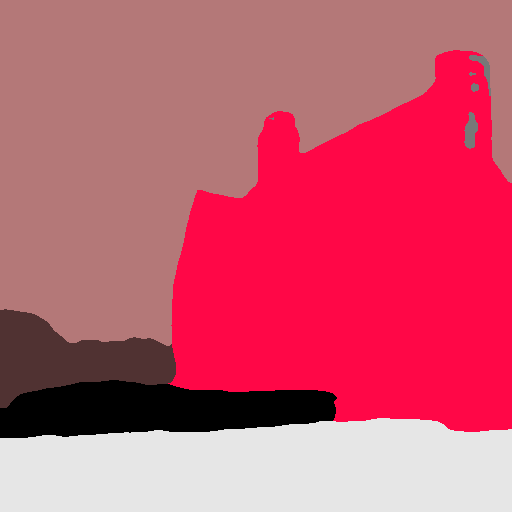

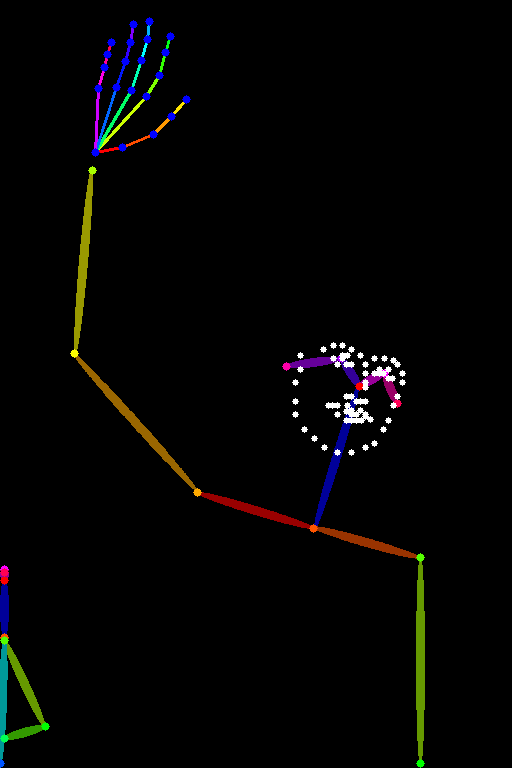

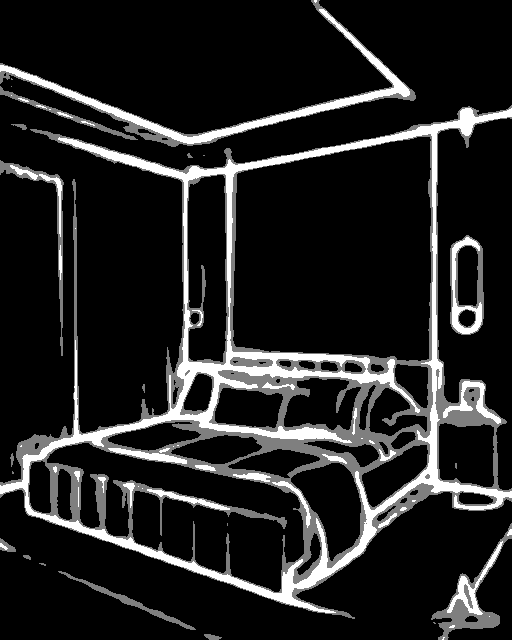

此檢查點對應於基於深度圖像的ControlNet。

✨ 主要特性

- 靈活結合Stable Diffusion:可與Stable Diffusion模型結合,如runwayml/stable-diffusion-v1-5,實現多樣化的圖像生成。

- 多類型條件控制:支持多種條件輸入,如邊緣圖、深度圖、關鍵點等,豐富了圖像生成的控制方式。

- 訓練優化:新版本解決了舊版本訓練數據集中的問題,如重複圖像、低質量圖像和錯誤提示等,使模型在更多情況下表現更合理。

- 通用性強:新的深度模型是相對無偏的模型,不依賴特定的深度估計方法,能更好地適應不同的深度估計、不同的預處理器分辨率,甚至是3D引擎生成的真實深度。

📦 安裝指南

若要使用此檢查點處理圖像以創建輔助條件,需要安裝外部依賴,步驟如下:

- 安裝

diffusers及相關包:

$ pip install diffusers transformers accelerate

💻 使用示例

基礎用法

建議將此檢查點與Stable Diffusion v1-5結合使用,因為該檢查點是基於此進行訓練的。實驗表明,此檢查點也可與其他擴散模型(如經過微調的Stable Diffusion)結合使用。

import torch

import os

from huggingface_hub import HfApi

from pathlib import Path

from diffusers.utils import load_image

from PIL import Image

import numpy as np

from transformers import pipeline

from diffusers import (

ControlNetModel,

StableDiffusionControlNetPipeline,

UniPCMultistepScheduler,

)

checkpoint = "lllyasviel/control_v11p_sd15_depth"

image = load_image(

"https://huggingface.co/lllyasviel/control_v11p_sd15_depth/resolve/main/images/input.png"

)

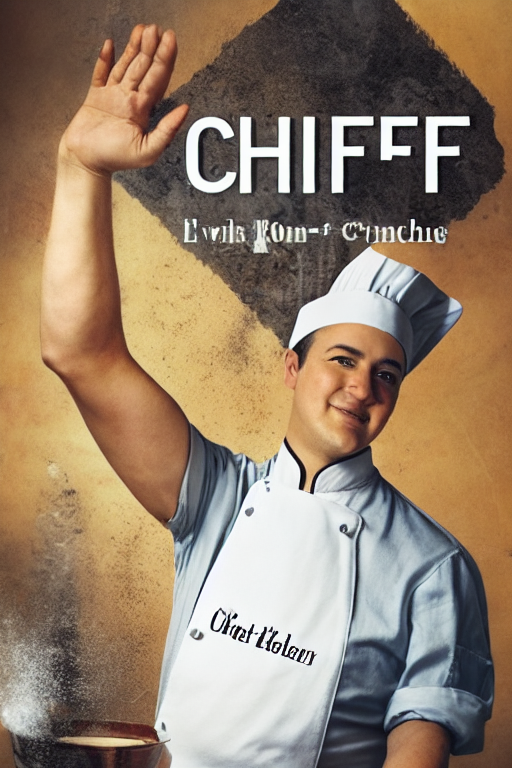

prompt = "Stormtrooper's lecture in beautiful lecture hall"

depth_estimator = pipeline('depth-estimation')

image = depth_estimator(image)['depth']

image = np.array(image)

image = image[:, :, None]

image = np.concatenate([image, image, image], axis=2)

control_image = Image.fromarray(image)

control_image.save("./images/control.png")

controlnet = ControlNetModel.from_pretrained(checkpoint, torch_dtype=torch.float16)

pipe = StableDiffusionControlNetPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5", controlnet=controlnet, torch_dtype=torch.float16

)

pipe.scheduler = UniPCMultistepScheduler.from_config(pipe.scheduler.config)

pipe.enable_model_cpu_offload()

generator = torch.manual_seed(0)

image = pipe(prompt, num_inference_steps=30, generator=generator, image=control_image).images[0]

image.save('images/image_out.png')

📚 詳細文檔

模型詳情

模型介紹

Controlnet由Lvmin Zhang和Maneesh Agrawala在論文Adding Conditional Control to Text-to-Image Diffusion Models中提出。

論文摘要如下:

我們提出了一種神經網絡結構ControlNet,用於控制預訓練的大型擴散模型以支持額外的輸入條件。ControlNet以端到端的方式學習特定任務的條件,即使訓練數據集較小(< 50k),學習過程也很穩健。此外,訓練ControlNet的速度與微調擴散模型相當,並且可以在個人設備上進行訓練。或者,如果有強大的計算集群,模型可以擴展到處理大量(數百萬到數十億)的數據。我們發現,像Stable Diffusion這樣的大型擴散模型可以通過ControlNet進行增強,以支持邊緣圖、深度圖、關鍵點等條件輸入。這可能會豐富控制大型擴散模型的方法,並進一步促進相關應用的發展。

其他已發佈的v1-1檢查點

作者發佈了14種不同的檢查點,每種都基於Stable Diffusion v1-5在不同類型的條件下進行訓練:

深度1.1版本的改進

- 訓練數據集優化:之前的cnet 1.0訓練數據集存在一些問題,包括(1)一小部分灰度人體圖像被重複數千次(!!),導致之前的模型有些容易生成灰度人體圖像;(2)一些圖像質量低、非常模糊或有明顯的JPEG偽影;(3)一小部分圖像由於數據處理腳本的錯誤而存在錯誤的配對提示。新模型解決了訓練數據集中的所有問題,在許多情況下應該更加合理。

- 通用性增強:新的深度模型是相對無偏的模型。它不是通過某種特定的深度估計方法針對特定類型的深度進行訓練的。它不會過度擬合某一種預處理器。這意味著該模型在不同的深度估計、不同的預處理器分辨率,甚至是3D引擎生成的真實深度下都能更好地工作。

- 數據增強:在訓練過程中應用了一些合理的數據增強方法,如隨機左右翻轉。

- 兼容性提升:該模型是在深度1.0的基礎上繼續訓練的,因此在深度1.0表現良好的所有情況下,它也應該表現良好。如果不是,請提供圖像並提交一個問題,我們會查看具體情況。深度1.1在深度1.0的許多失敗案例中表現良好。

- 性能表現:如果使用Midas深度(Web UI插件中的“深度”)和384的預處理器分辨率,深度1.0和1.1之間的差異應該很小。然而,如果嘗試其他預處理器分辨率或其他預處理器(如leres和zoe),預計深度1.1會比1.0略好。

更多信息

如需更多信息,請查看Diffusers ControlNet博客文章和官方文檔。

📄 許可證

本項目採用The CreativeML OpenRAIL M license。

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語