🚀 視頻掩碼2Former(Video Mask2Former)

Video Mask2Former是在YouTubeVIS - 2019實例分割數據集上訓練的模型(微小版本,採用Swin骨幹網絡),可有效解決視頻實例分割問題。

🚀 快速開始

Video Mask2Former模型在YouTubeVIS - 2019實例分割數據集上進行訓練(微小版本,採用Swin骨幹網絡)。該模型在論文用於視頻實例分割的Mask2Former中被提出,並首次在此倉庫發佈。Video Mask2Former是原用於通用圖像分割的掩碼注意力掩碼變換器(Masked - attention Mask Transformer for Universal Image Segmentation)論文中Mask2Former模型的擴展。

聲明:發佈Mask2Former的團隊並未為此模型撰寫模型卡片,此模型卡片由Hugging Face團隊編寫。

✨ 主要特性

模型描述

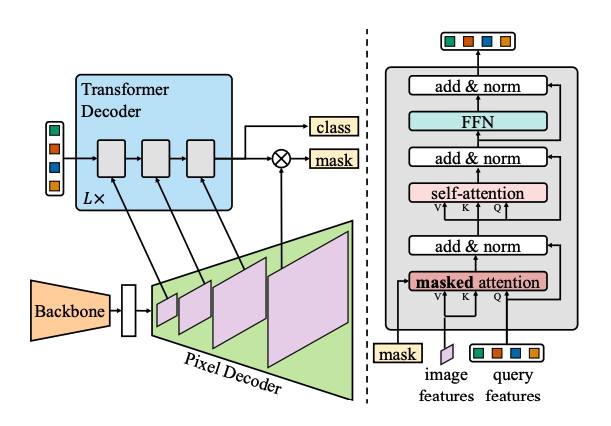

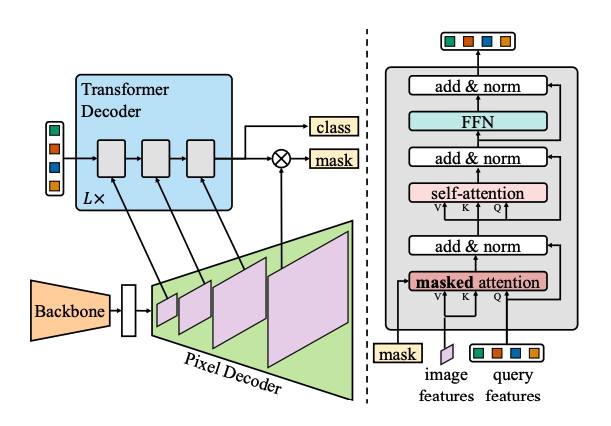

Mask2Former使用相同的範式來處理實例、語義和全景分割:通過預測一組掩碼和相應的標籤。因此,所有這3項任務都被視為實例分割。與之前的最優模型MaskFormer相比,Mask2Former在性能和效率方面都更勝一籌,具體體現在:

- 用更先進的多尺度可變形注意力變換器取代像素解碼器;

- 採用帶掩碼注意力的變換器解碼器,在不引入額外計算的情況下提升性能;

- 通過在子採樣點而不是整個掩碼上計算損失來提高訓練效率。

在論文用於視頻實例分割的Mask2Former中,作者表明Mask2Former在不修改架構、損失函數甚至訓練流程的情況下,在視頻實例分割任務上也取得了最優性能。

預期用途與侷限性

你可以使用此特定檢查點進行實例分割。請查看[模型中心](https://huggingface.co/models?search=video - mask2former),以查找此模型其他可能令你感興趣的微調版本。

💻 使用示例

基礎用法

import torch

import torchvision

from huggingface_hub import hf_hub_download

from transformers import AutoImageProcessor, Mask2FormerForUniversalSegmentation

processor = AutoImageProcessor.from_pretrained("facebook/video-mask2former-swin-tiny-youtubevis-2019-instance")

model = Mask2FormerForUniversalSegmentation.from_pretrained("facebook/video-mask2former-swin-tiny-youtubevis-2019-instance")

file_path = hf_hub_download(repo_id="shivi/video-demo", filename="cars.mp4", repo_type="dataset")

video = torchvision.io.read_video(file_path)[0]

video_frames = [image_processor(images=frame, return_tensors="pt").pixel_values for frame in video]

video_input = torch.cat(video_frames)

with torch.no_grad():

outputs = model(**video_input)

class_queries_logits = outputs.class_queries_logits

masks_queries_logits = outputs.masks_queries_logits

result = image_processor.post_process_video_instance_segmentation(outputs, target_sizes=[tuple(video.shape[1:3])])[0]

predicted_video_instance_map = result["segmentation"]

如需更多代碼示例,請參考文檔。

📄 許可證

本模型採用MIT許可證。

| 屬性 |

詳情 |

| 模型類型 |

視頻實例分割模型 |

| 訓練數據 |

YouTubeVIS - 2019 |

| 標籤 |

視覺、圖像分割 |

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語