🚀 Mistral-portuguese-luana-7b

本模型基於200,000條葡萄牙語指令的超集進行訓練,旨在填補葡萄牙語模型的空白。它在Mistral 7b的基礎上進行微調,主要針對指令任務進行了優化。

如果您需要更高的兼容性,Luana模型還有可以使用LlamaCpp運行的GGUF系列。您可以從以下模型開始探索:

探索這些模型,找到最適合您需求的那一個!

🚀 快速開始

完整模型:A100

半精度模型:L4

8位或4位量化:T4或V100

您可以使用正常形式的模型,也可以進行高達4位的量化。下面我們將介紹這兩種方法。請記住,在提示詞中使用明確的動詞很重要。告訴模型如何行動或表現,這樣您就能引導它給出更好的回覆。這些要點有助於模型(即使是像7b這樣的小模型)表現得更好。

!pip install -q -U transformers

!pip install -q -U accelerate

!pip install -q -U bitsandbytes

from transformers import AutoModelForCausalLM, AutoTokenizer, TextStreamer

model = AutoModelForCausalLM.from_pretrained("rhaymison/Mistral-portuguese-luana-7b", device_map= {"": 0})

tokenizer = AutoTokenizer.from_pretrained("rhaymison/Mistral-portuguese-luana-7b")

model.eval()

您可以使用Pipeline,但在這個例子中,我們將使用流式輸出:

inputs = tokenizer([f"""<s>[INST] Abaixo está uma instrução que descreve uma tarefa, juntamente com uma entrada que fornece mais contexto.

Escreva uma resposta que complete adequadamente o pedido.

### instrução: aja como um professor de matemática e me explique porque 2 + 2 = 4.

[/INST]"""], return_tensors="pt")

inputs.to(model.device)

streamer = TextStreamer(tokenizer, skip_prompt=True, skip_special_tokens=True)

_ = model.generate(**inputs, streamer=streamer, max_new_tokens=200)

如果您遇到“CUDA內存不足”之類的內存問題,您應該使用4位或8位量化。在Colab上運行完整模型需要A100。如果您想使用4位或8位量化,T4或L4就可以解決問題。

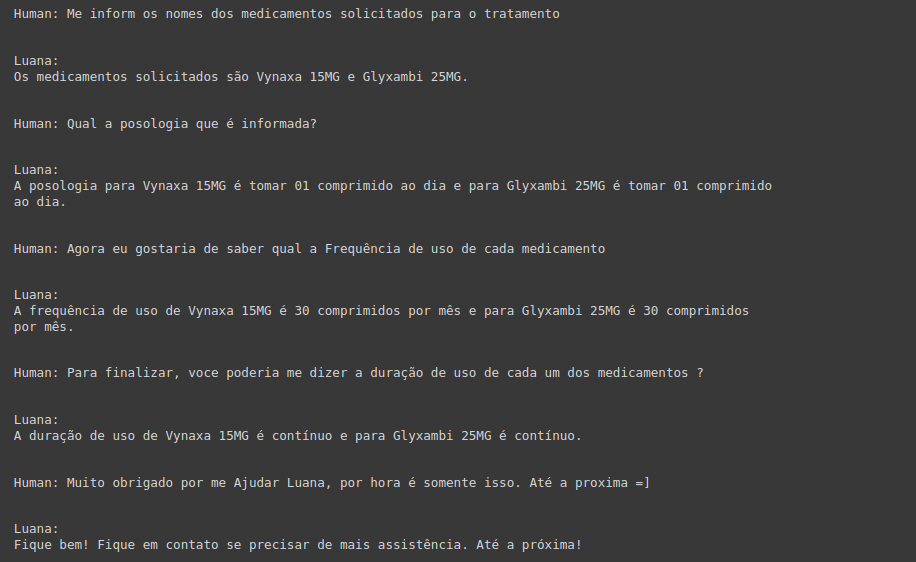

💻 使用示例

基礎用法

!pip install -q -U transformers

!pip install -q -U accelerate

!pip install -q -U bitsandbytes

from transformers import AutoModelForCausalLM, AutoTokenizer, TextStreamer

model = AutoModelForCausalLM.from_pretrained("rhaymison/Mistral-portuguese-luana-7b", device_map= {"": 0})

tokenizer = AutoTokenizer.from_pretrained("rhaymison/Mistral-portuguese-luana-7b")

model.eval()

高級用法

from transformers import BitsAndBytesConfig

import torch

nb_4bit_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.bfloat16,

bnb_4bit_use_double_quant=True

)

model = AutoModelForCausalLM.from_pretrained(

base_model,

quantization_config=bnb_config,

device_map={"": 0}

)

📚 詳細文檔

詳細結果可查看此處

| 屬性 |

詳情 |

| 模型類型 |

Mistral-portuguese-luana-7b |

| 訓練數據 |

pablo-moreira/gpt4all-j-prompt-generations-pt、rhaymison/superset |

| 指標 |

數值 |

| 平均值 |

64.27 |

| ENEM挑戰(無圖像) |

58.64 |

| BLUEX(無圖像) |

47.98 |

| OAB考試 |

38.82 |

| Assin2 RTE |

90.63 |

| Assin2 STS |

75.81 |

| FaQuAD NLI |

57.79 |

| HateBR二分類 |

77.24 |

| 葡萄牙語仇恨言論二分類 |

68.50 |

| tweetSentBR |

63 |

📄 許可證

本項目採用Apache-2.0許可證。

評論

歡迎提出任何想法、提供幫助或反饋問題。

郵箱:rhaymisoncristian@gmail.com

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語