🚀 Llama-3-Typhoon-1.5-8B:泰語大語言模型(指令型)

Llama-3-Typhoon-1.5-8B-instruct 是一個擁有 80 億參數的泰語 🇹🇭 指令型大語言模型,它基於 Llama3-8B 構建。

有關發佈文章,請查看我們的 博客。

*為了認可 Meta 在創建基礎模型方面的努力並遵守許可協議,我們在模型名稱中明確包含了 "llama-3"。

✨ 主要特性

- 模型類型:基於 Llama 架構的 80 億參數指令型僅解碼器模型。

- 依賴要求:transformers 4.38.0 或更高版本。

- 主要語言:泰語 🇹🇭 和英語 🇬🇧

- 許可證:Llama 3 社區許可證

📊 性能表現

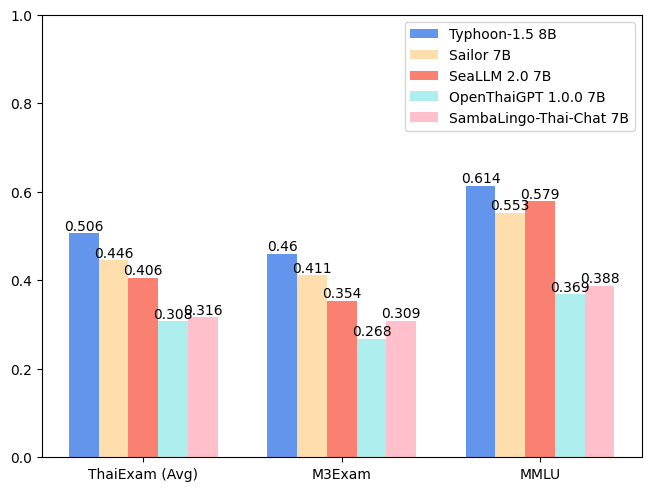

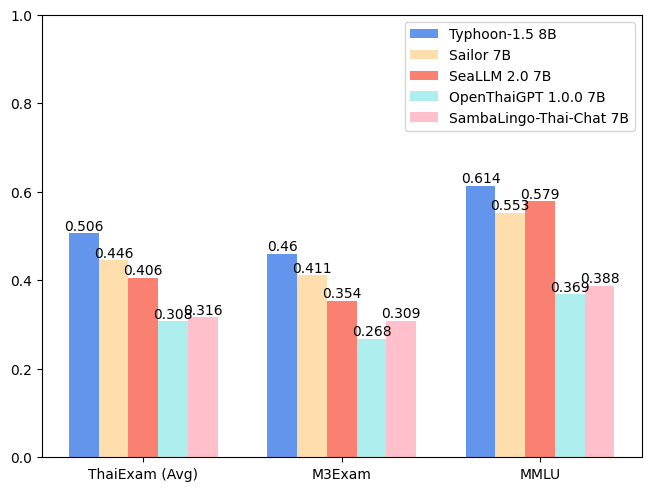

| 模型 |

ONET |

IC |

TGAT |

TPAT-1 |

A-Level |

平均(泰語考試) |

M3Exam |

MMLU |

| Typhoon-1.0(Mistral) |

0.379 |

0.393 |

0.700 |

0.414 |

0.324 |

0.442 |

0.391 |

0.547 |

| Typhoon-1.5 8B(Llama3) |

0.446 |

0.431 |

0.722 |

0.526 |

0.407 |

0.506 |

0.460 |

0.614 |

| Sailor 7B |

0.372 |

0.379 |

0.678 |

0.405 |

0.396 |

0.446 |

0.411 |

0.553 |

| SeaLLM 2.0 7B |

0.327 |

0.311 |

0.656 |

0.414 |

0.321 |

0.406 |

0.354 |

0.579 |

| OpenThaiGPT 1.0.0 7B |

0.238 |

0.249 |

0.444 |

0.319 |

0.289 |

0.308 |

0.268 |

0.369 |

| SambaLingo - Thai - Chat 7B |

0.251 |

0.241 |

0.522 |

0.302 |

0.262 |

0.316 |

0.309 |

0.388 |

💻 使用示例

基礎用法

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_id = "scb10x/llama-3-typhoon-v1.5-8b-instruct"

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(

model_id,

torch_dtype=torch.bfloat16,

device_map="auto",

)

messages = [

{"role": "system", "content": "You are a helpful assistant who're always speak Thai."},

{"role": "user", "content": "ขอสูตรไก่ย่าง"},

]

input_ids = tokenizer.apply_chat_template(

messages,

add_generation_prompt=True,

return_tensors="pt"

).to(model.device)

terminators = [

tokenizer.eos_token_id,

tokenizer.convert_tokens_to_ids("<|eot_id|>")

]

outputs = model.generate(

input_ids,

max_new_tokens=512,

eos_token_id=terminators,

do_sample=True,

temperature=0.4,

top_p=0.9,

)

response = outputs[0][input_ids.shape[-1]:]

print(tokenizer.decode(response, skip_special_tokens=True))

聊天模板

我們使用 llama3 聊天模板。

{% set loop_messages = messages %}{% for message in loop_messages %}{% set content = '<|start_header_id|>' + message['role'] + '<|end_header_id|>\n\n'+ message['content'] | trim + '<|eot_id|>' %}{% if loop.index0 == 0 %}{% set content = bos_token + content %}{% endif %}{{ content }}{% endfor %}{% if add_generation_prompt %}{{ '<|start_header_id|>assistant<|end_header_id|>\n\n' }}{% endif %}

📚 詳細文檔

預期用途與侷限性

此模型是一個指令型模型,但仍在開發中。它包含了一定程度的防護機制,但在響應用戶提示時仍可能產生不準確、有偏見或其他令人反感的答案。我們建議開發人員在其用例的背景下評估這些風險。

關注我們

https://twitter.com/opentyphoon

支持渠道

https://discord.gg/us5gAYmrxw

SCB10X AI 團隊

- Kunat Pipatanakul, Potsawee Manakul, Sittipong Sripaisarnmongkol, Natapong Nitarach, Pathomporn Chokchainant, Kasima Tharnpipitchai

- 如果您發現 Typhoon - 8B 對您的工作有用,請使用以下方式引用它:

@article{pipatanakul2023typhoon,

title={Typhoon: Thai Large Language Models},

author={Kunat Pipatanakul and Phatrasek Jirabovonvisut and Potsawee Manakul and Sittipong Sripaisarnmongkol and Ruangsak Patomwong and Pathomporn Chokchainant and Kasima Tharnpipitchai},

year={2023},

journal={arXiv preprint arXiv:2312.13951},

url={https://arxiv.org/abs/2312.13951}

}

聯繫我們

📄 許可證

本模型使用 Llama 3 社區許可證。

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語