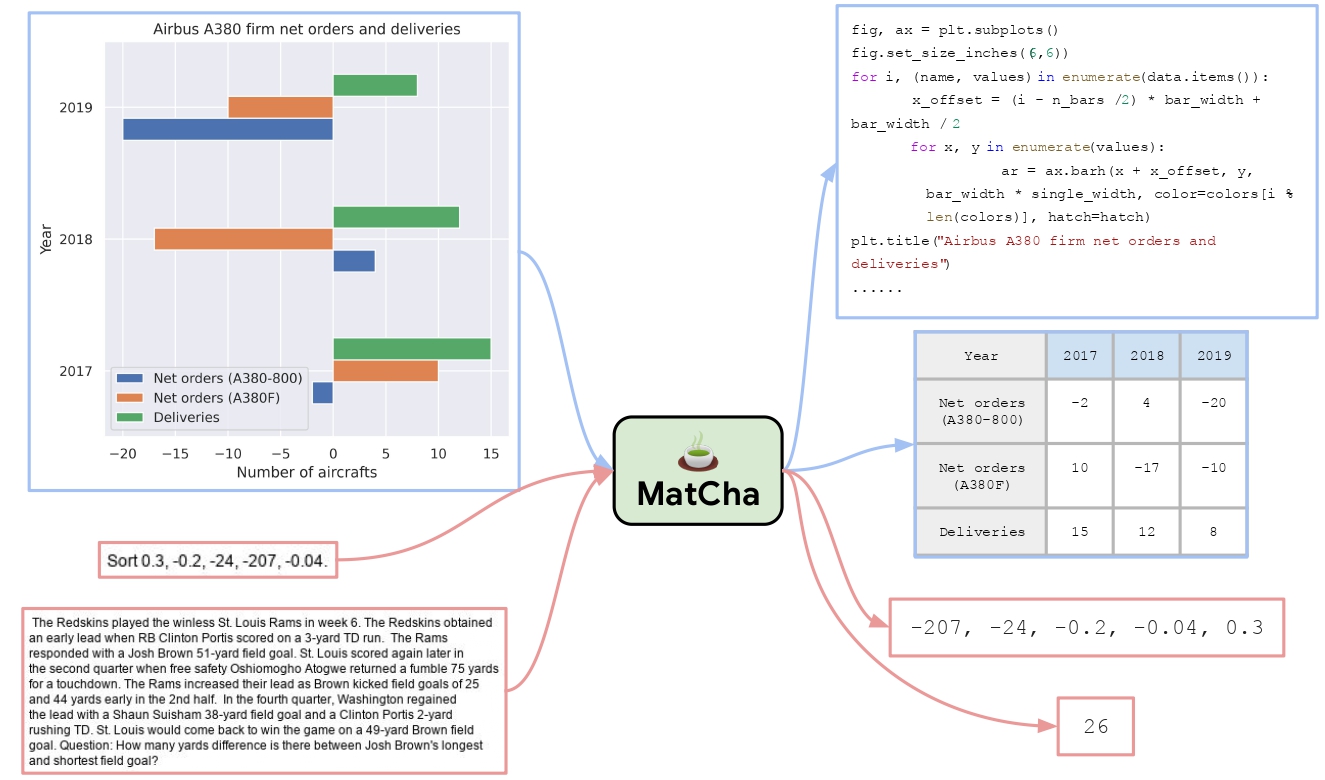

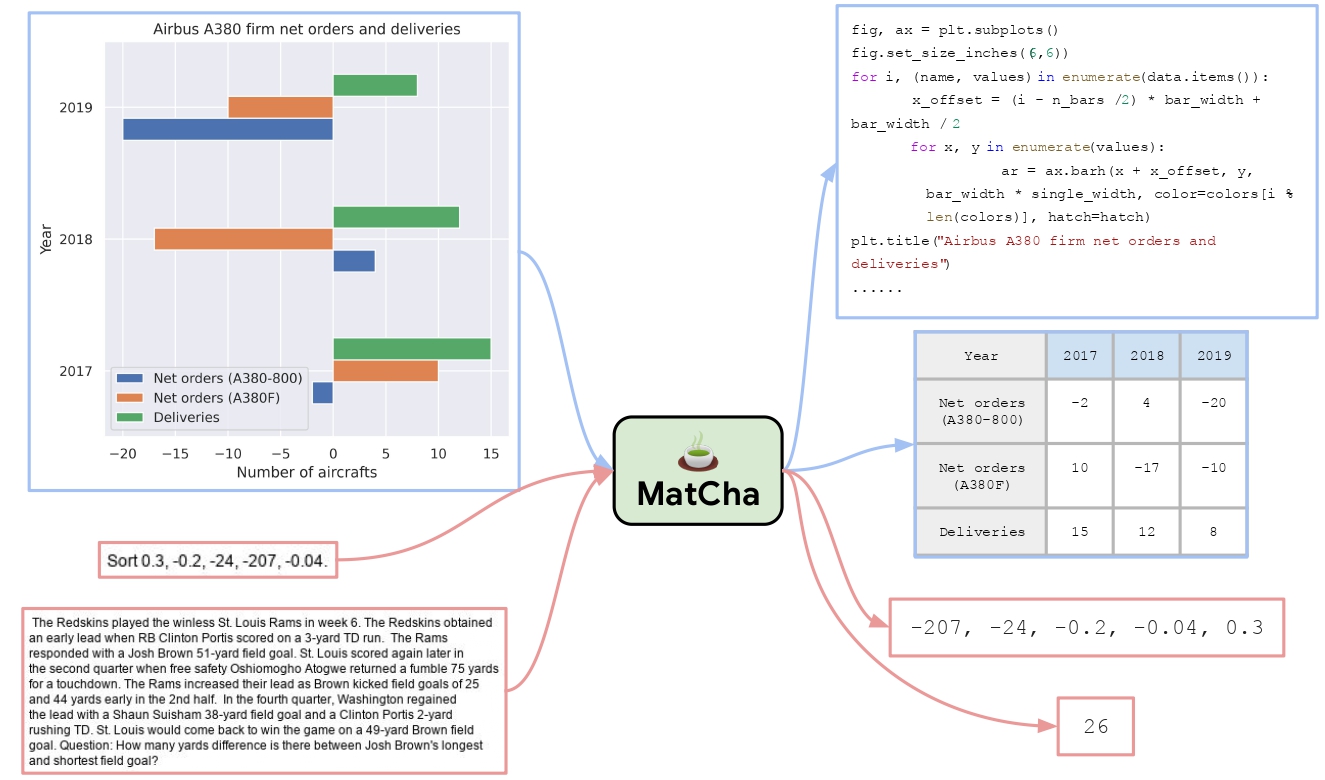

🚀 MatCha - 在PlotQA - v1數據集上微調的模型卡片

MatCha是一個經過微調的模型,在PlotQA - v1數據集上進行了優化。這個微調後的檢查點可能更適合圖表問答任務,能為視覺語言數據的處理帶來更出色的效果。

🚀 快速開始

從T5x轉換到Hugging Face

你可以使用convert_pix2struct_checkpoint_to_pytorch.py腳本進行轉換,如下所示:

python convert_pix2struct_checkpoint_to_pytorch.py --t5x_checkpoint_path PATH_TO_T5X_CHECKPOINTS --pytorch_dump_path PATH_TO_SAVE --is_vqa

如果你要轉換一個大模型,請運行:

python convert_pix2struct_checkpoint_to_pytorch.py --t5x_checkpoint_path PATH_TO_T5X_CHECKPOINTS --pytorch_dump_path PATH_TO_SAVE --use-large --is_vqa

保存後,你可以使用以下代碼片段將轉換後的模型推送到Hugging Face Hub:

from transformers import Pix2StructForConditionalGeneration, Pix2StructProcessor

model = Pix2StructForConditionalGeneration.from_pretrained(PATH_TO_SAVE)

processor = Pix2StructProcessor.from_pretrained(PATH_TO_SAVE)

model.push_to_hub("USERNAME/MODEL_NAME")

processor.push_to_hub("USERNAME/MODEL_NAME")

運行預測

要運行預測,請參考matcha - chartqa模型卡片中的說明。

✨ 主要特性

論文摘要指出:

圖表、圖形和信息圖等視覺語言數據在人類世界中無處不在。然而,最先進的視覺語言模型在處理這些數據時表現不佳。我們提出了MATCHA(數學推理和圖表反渲染預訓練),以增強視覺語言模型對圖表和語言數據進行聯合建模的能力。具體來說,我們提出了幾個預訓練任務,涵蓋了圖表解構和數值推理,這些是視覺語言建模中的關鍵能力。我們從最近提出的圖像到文本視覺語言模型Pix2Struct開始進行MATCHA預訓練。在PlotQA和ChartQA等標準基準測試中,MATCHA模型比最先進的方法高出近20%。我們還研究了MATCHA預訓練在截圖、教科書圖表和文檔圖形等領域的遷移效果,並觀察到整體有所改進,驗證了MATCHA預訓練在更廣泛的視覺語言任務中的實用性。

📚 詳細文檔

目錄

- 簡要總結

- 使用模型

- 貢獻者

- 引用信息

簡要總結

如上述特性中所述,MATCHA模型通過特定的預訓練任務,提升了視覺語言模型處理圖表和語言數據的能力,在多個基準測試中表現出色,並且在不同領域有較好的遷移效果。

使用模型

從T5x轉換到Hugging Face

提供了具體的腳本使用方法和大模型轉換的額外參數。

運行預測

提供了參考的模型卡片鏈接。

貢獻者

該模型最初由Fangyu Liu、Francesco Piccinno等人貢獻,並由Younes Belkada添加到Hugging Face生態系統中。

引用信息

如果你想引用這項工作,請考慮引用原始論文:

@misc{liu2022matcha,

title={MatCha: Enhancing Visual Language Pretraining with Math Reasoning and Chart Derendering},

author={Fangyu Liu and Francesco Piccinno and Syrine Krichene and Chenxi Pang and Kenton Lee and Mandar Joshi and Yasemin Altun and Nigel Collier and Julian Martin Eisenschlos},

year={2022},

eprint={2212.09662},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

📄 許可證

本模型使用的許可證為Apache - 2.0。

📦 模型信息

| 屬性 |

詳情 |

| 支持語言 |

en、fr、ro、de、多語言 |

| 推理功能 |

不支持 |

| 任務類型 |

視覺問答 |

| 許可證 |

Apache - 2.0 |

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語