🚀 Llama-3.1-SauerkrautLM-70b-Instruct

このモデルは、Spectrum Fine-Tuningを用いた大規模言語モデルの省資源ファインチューニングの可能性を示す、ファインチューニング済みモデルです。

🚀 クイックスタート

このドキュメントでは、Llama-3.1-SauerkrautLM-70b-Instructモデルについて詳しく説明します。モデルの概要、トレーニング手順、評価結果、免責事項、およびコンタクト情報などが含まれています。

✨ 主な機能

- Spectrum Fine-Tuningを活用:モデルのレイヤーの15%を対象に、Spectrum Fine-Tuningを行いました。

- 独特なデータセットを使用:ドイツ語と英語のSauerkraut Mix v2データセットを用いて、効率的なクロスリンガル転移学習を実現しました。

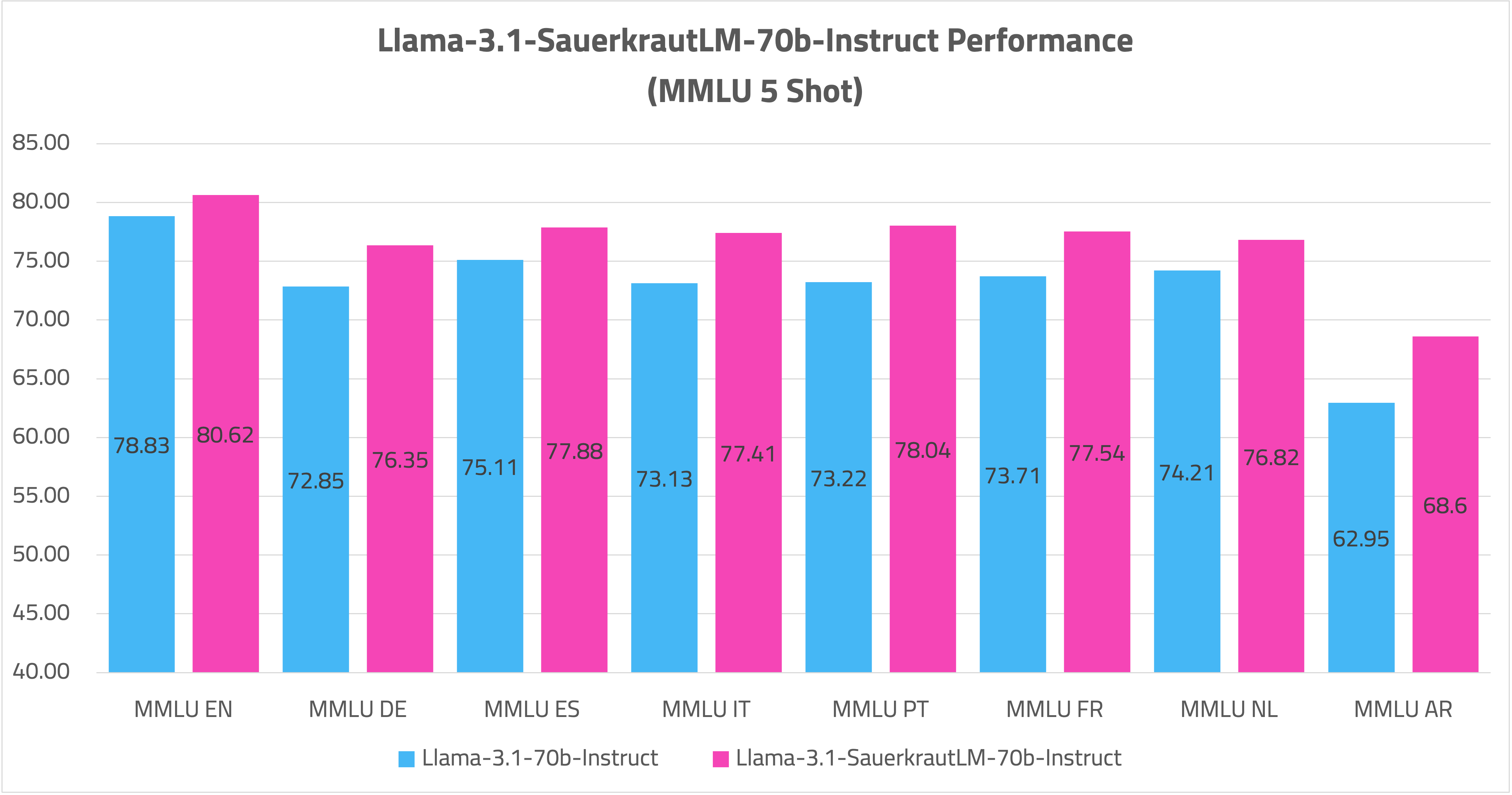

- マルチリンガル能力の向上:クロスリンガル知識の転移により、アラビア語、イタリア語、フランス語、スペイン語、オランダ語、ポルトガル語などの複数言語での性能が向上しました。

📦 インストール

ドキュメントにインストール手順に関する具体的な内容が記載されていないため、このセクションをスキップします。

💻 使用例

ドキュメントにコード例が記載されていないため、このセクションをスキップします。

📚 ドキュメント

🔍 Llama-3.1-SauerkrautLM-70b-Instructの概要

| モデル |

HF |

EXL2 |

GGUF |

AWQ |

| Llama-3.1-SauerkrautLM-70b-Instruct |

リンク |

近日公開 |

近日公開 |

近日公開 |

📋 モデルの詳細

📈 トレーニング手順

このモデルは、Spectrum Fine-Tuningを用いた大規模言語モデルの省資源ファインチューニングの可能性を示しています。以下はトレーニング手順の概要です。

ドイツ語 - 英語データのファインチューニング

- モデルのレイヤーの15%を対象に、Spectrum Fine-Tuningを行いました。

- ドイツ語と英語の独特なSauerkraut Mix v2データセットを使用しました。

- 独自の高精度ファインチューニングアプローチを実装しました。

Sauerkraut Mix v2を用いたクロスリンガル転移学習

- Sauerkraut Mix v2データセットをクロスリンガル転移の基礎として利用しました。

- この独特なデータセットは主にドイツ語と英語に焦点を当てており、モデルが他の言語に知識を転移することを可能にしました。

- 各言語の大量のトレーニングデータを必要とせずに、アラビア語、イタリア語、フランス語、スペイン語、オランダ語、ポルトガル語の能力を向上させました。

- バイリンガルデータセットを用いたマルチリンガル改善の有効性を実証しました。

Sauerkraut Mix v2

- 言語モデル用の高品質データセットで、ドイツ語と英語に焦点を当てています。

- 入念に選択された高品質データセットの組み合わせです。

- 独自の高精度生成技術を用いて作成された最先端の合成データセットです。

- ファインチューニングとクロスリンガル転移の両方の主要なリソースとして機能します。

🎯 目的と結果

このトレーニングの主な目的は2つあります。

- レイヤーのわずか15%を対象としたSpectrum Fine-Tuningが、700億パラメータのモデルの能力を大幅に向上させることができ、従来のファインチューニングアプローチに比べてわずかなリソースしか必要としないことを示すこと。

- Sauerkraut Mix v2データセットを用いたクロスリンガル転移学習の有効性を示し、大量の言語固有のトレーニングデータを必要とせずにマルチリンガル能力を向上させること。

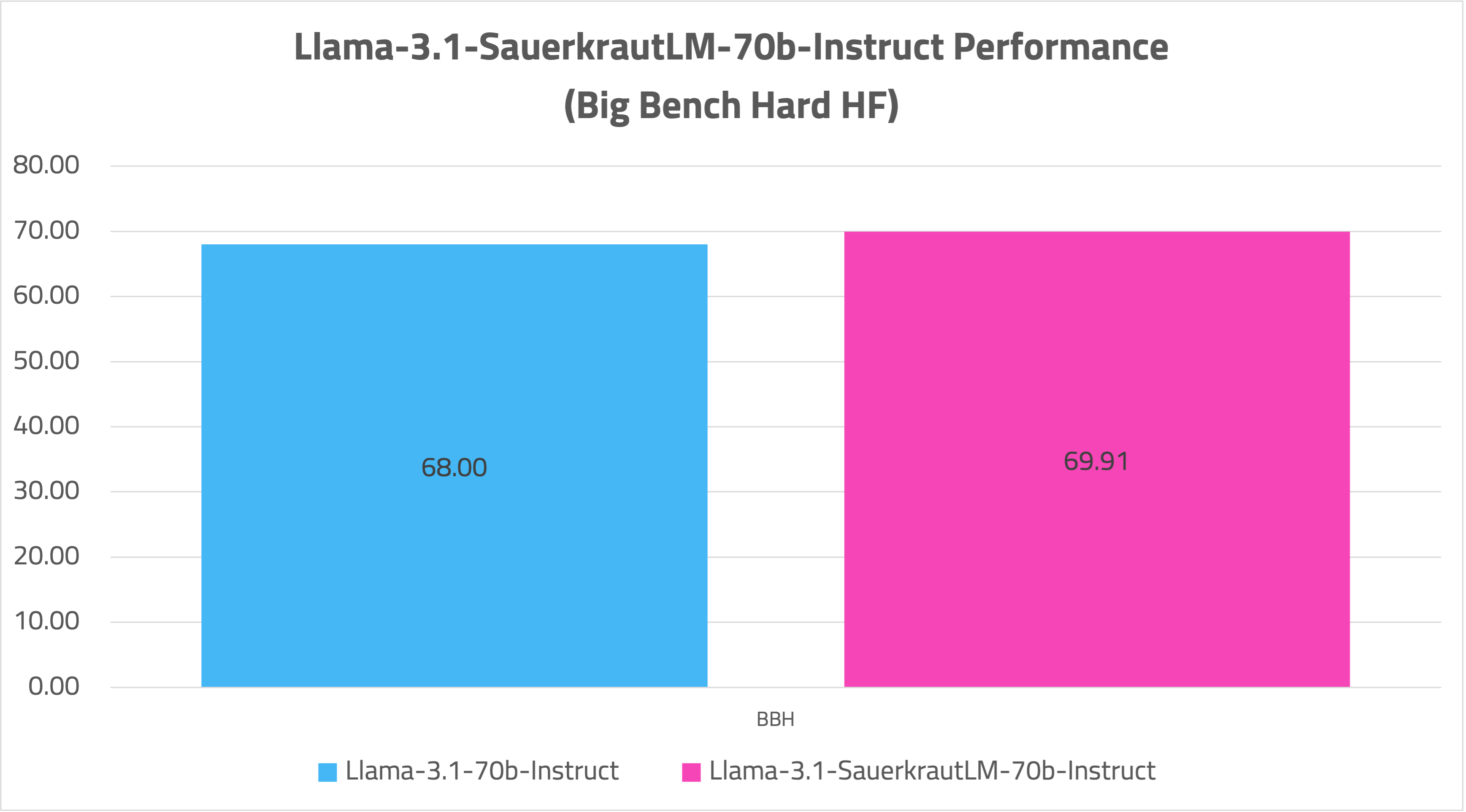

結果は顕著でした。

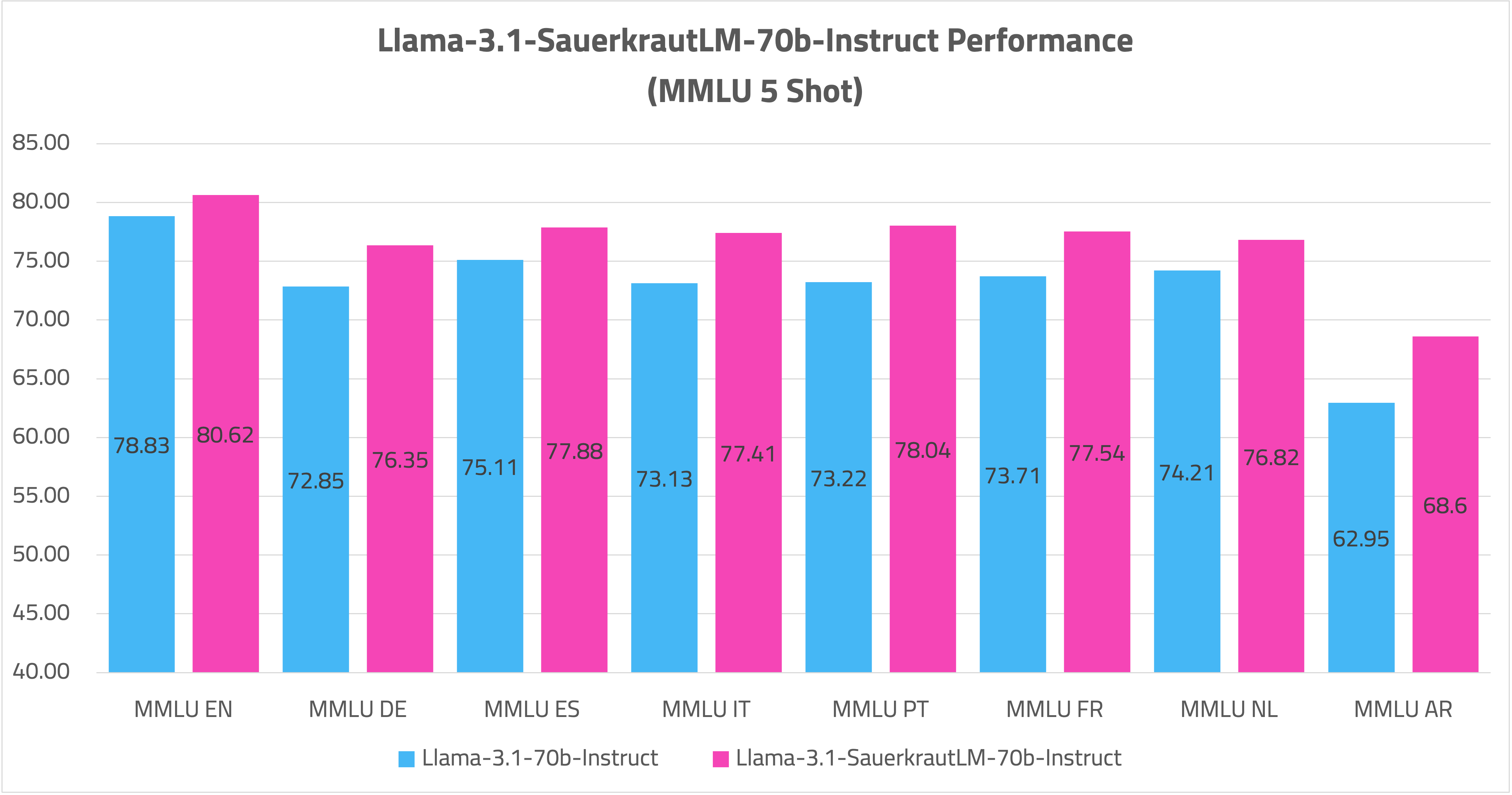

- モデルは、MMLU Multilingualでの印象的なベンチマークによって示されるように、マルチリンガルスキルを大幅に向上させました。

主要な発見

- Spectrum Fine-Tuningは、大規模言語モデルの複数言語での能力を効率的に向上させることができ、以前に獲得した知識の大部分を保持することができます。

- Sauerkraut Mix v2データセットは、クロスリンガル転移の効果的な基礎となり、バイリンガルベースからのマルチリンガル改善を可能にします。

- このアプローチは、各ターゲット言語の大量のトレーニングデータを必要とせずに、強力なマルチリンガルモデルを作成するための省資源な方法を示しています。

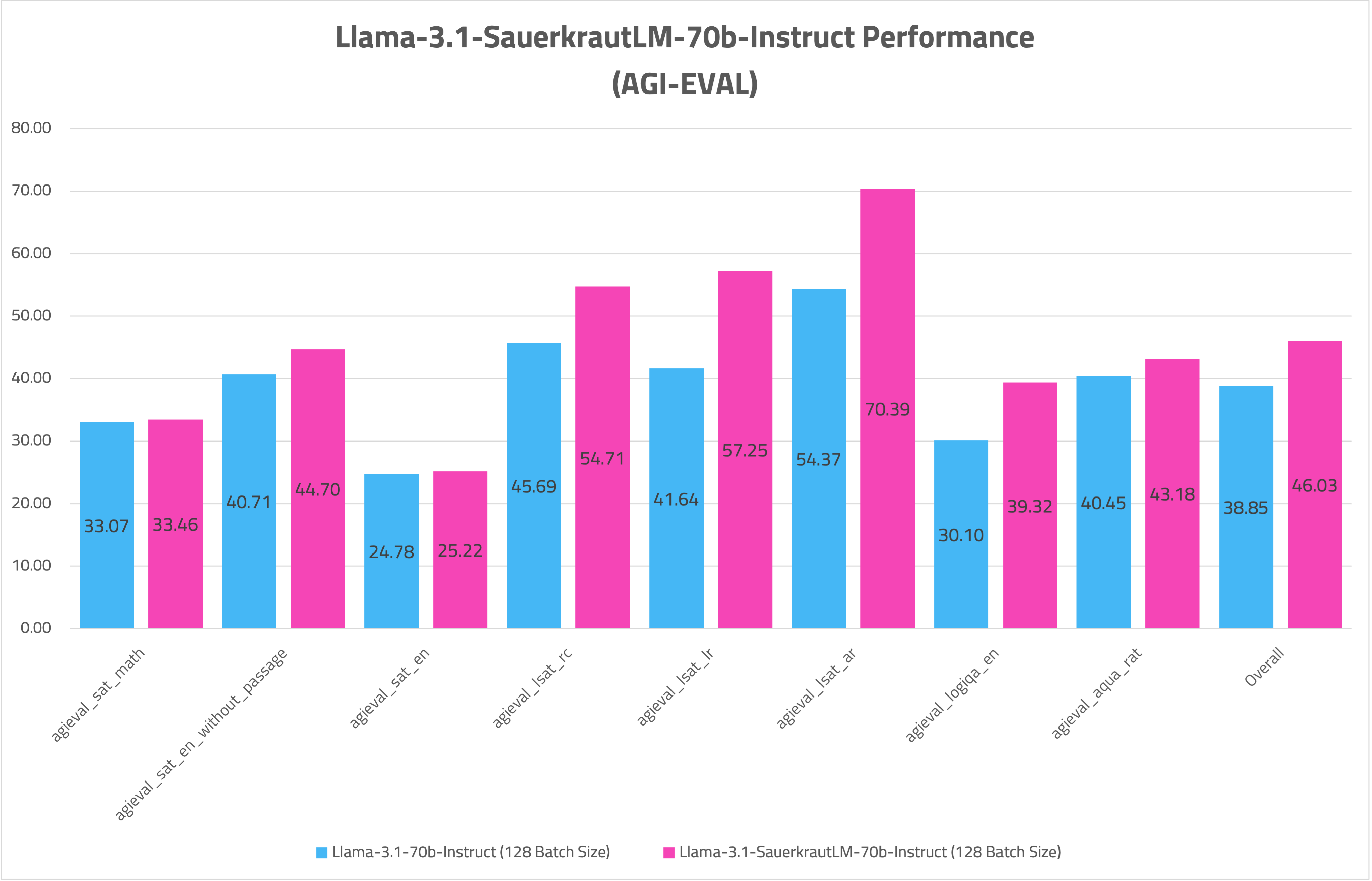

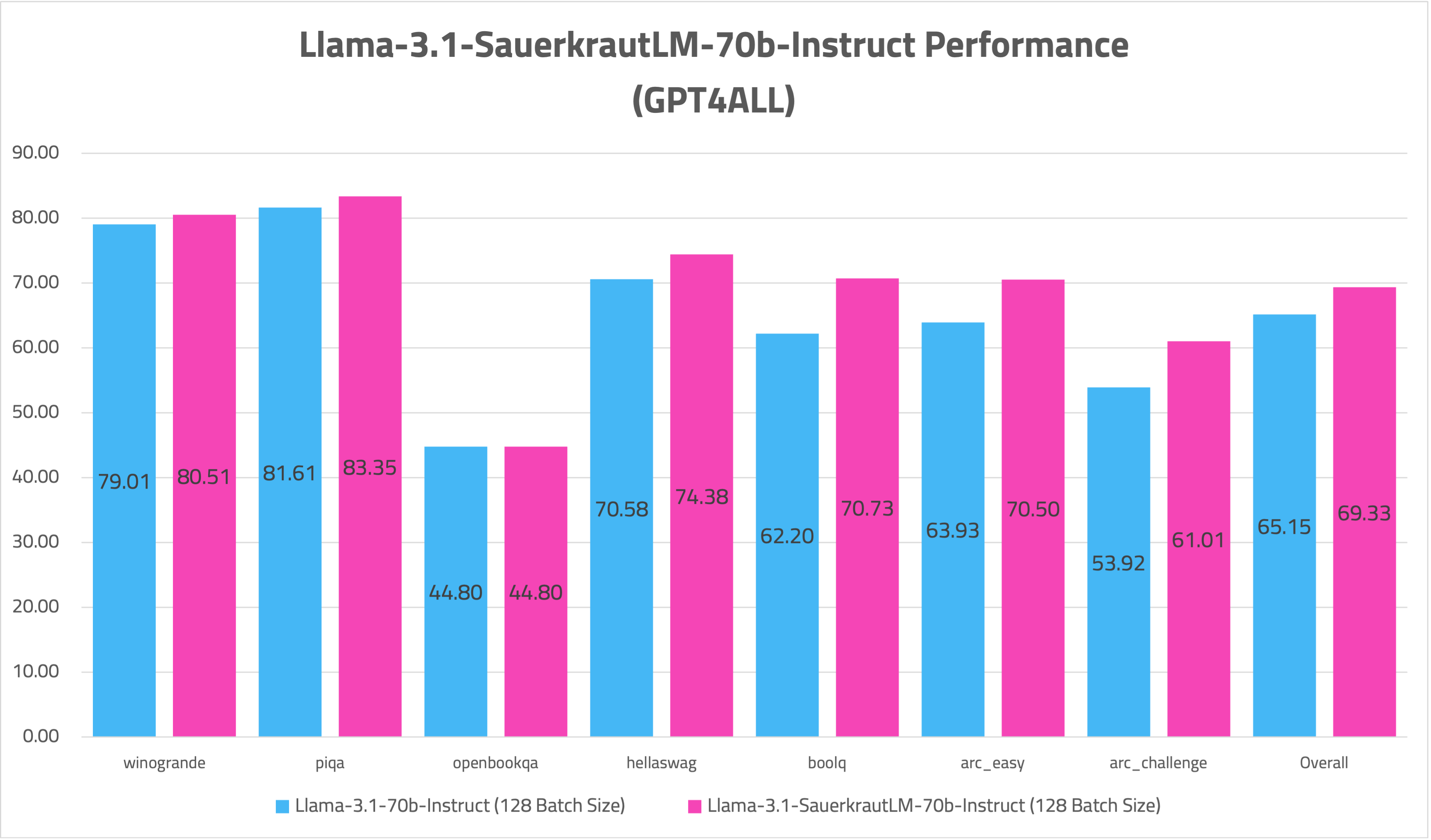

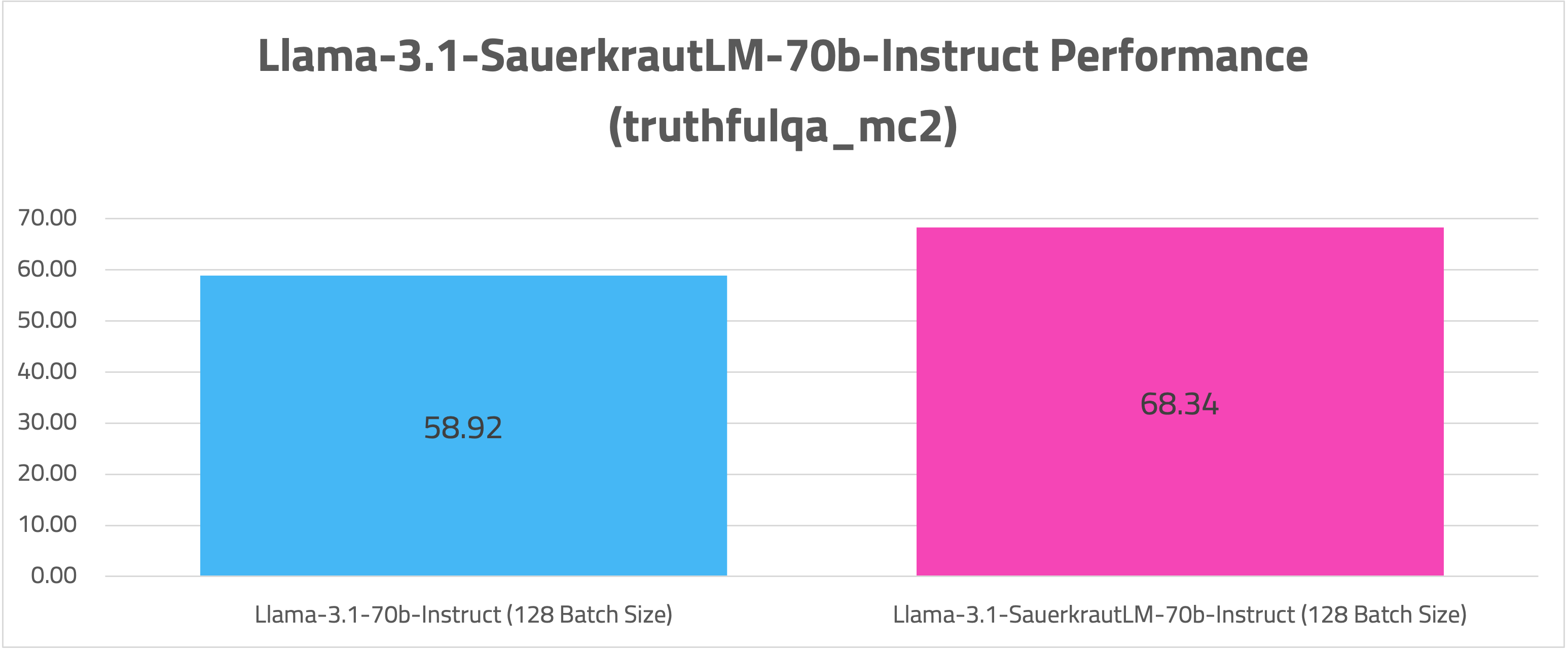

🧪 評価

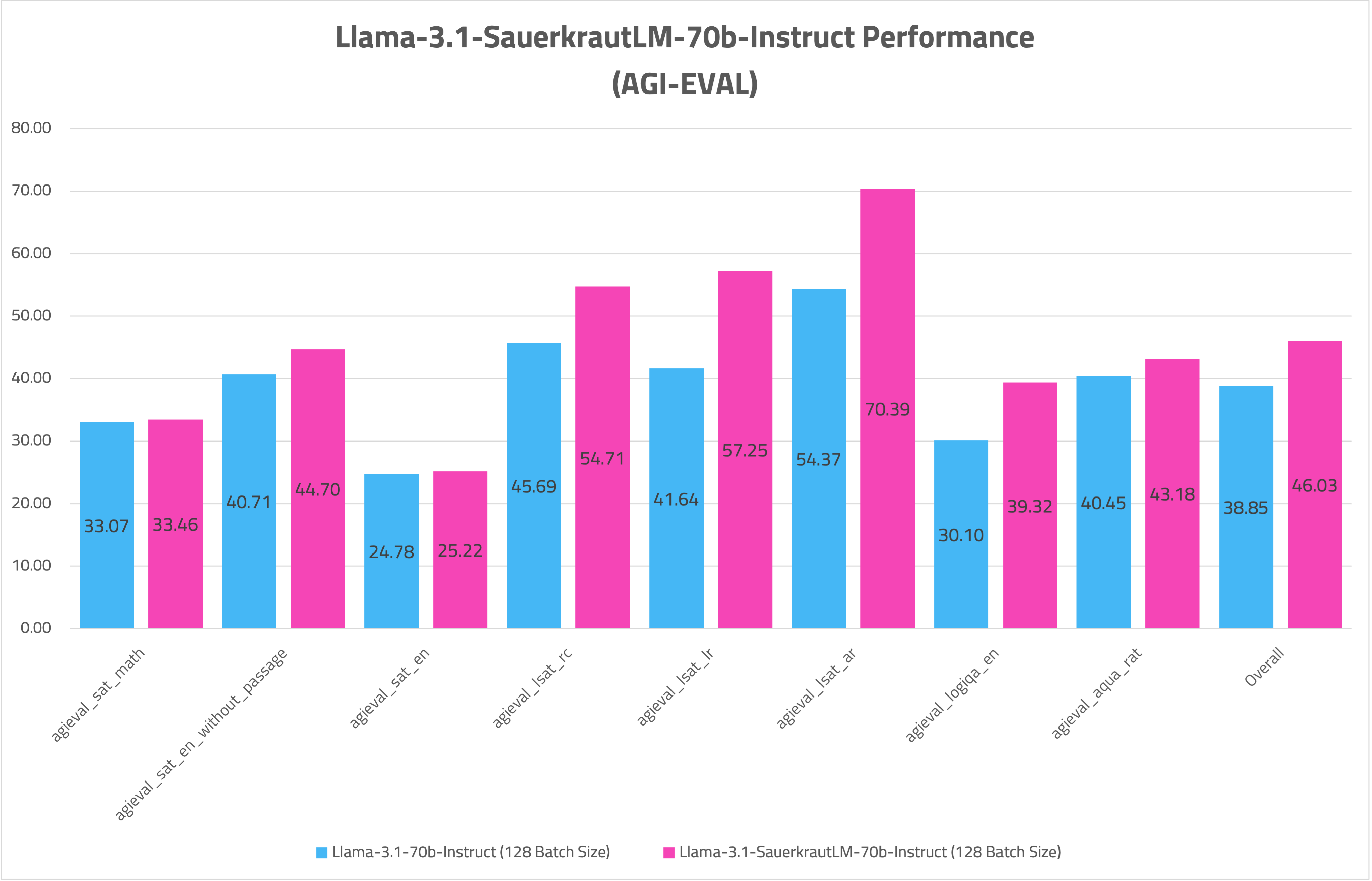

- AGIEVAL

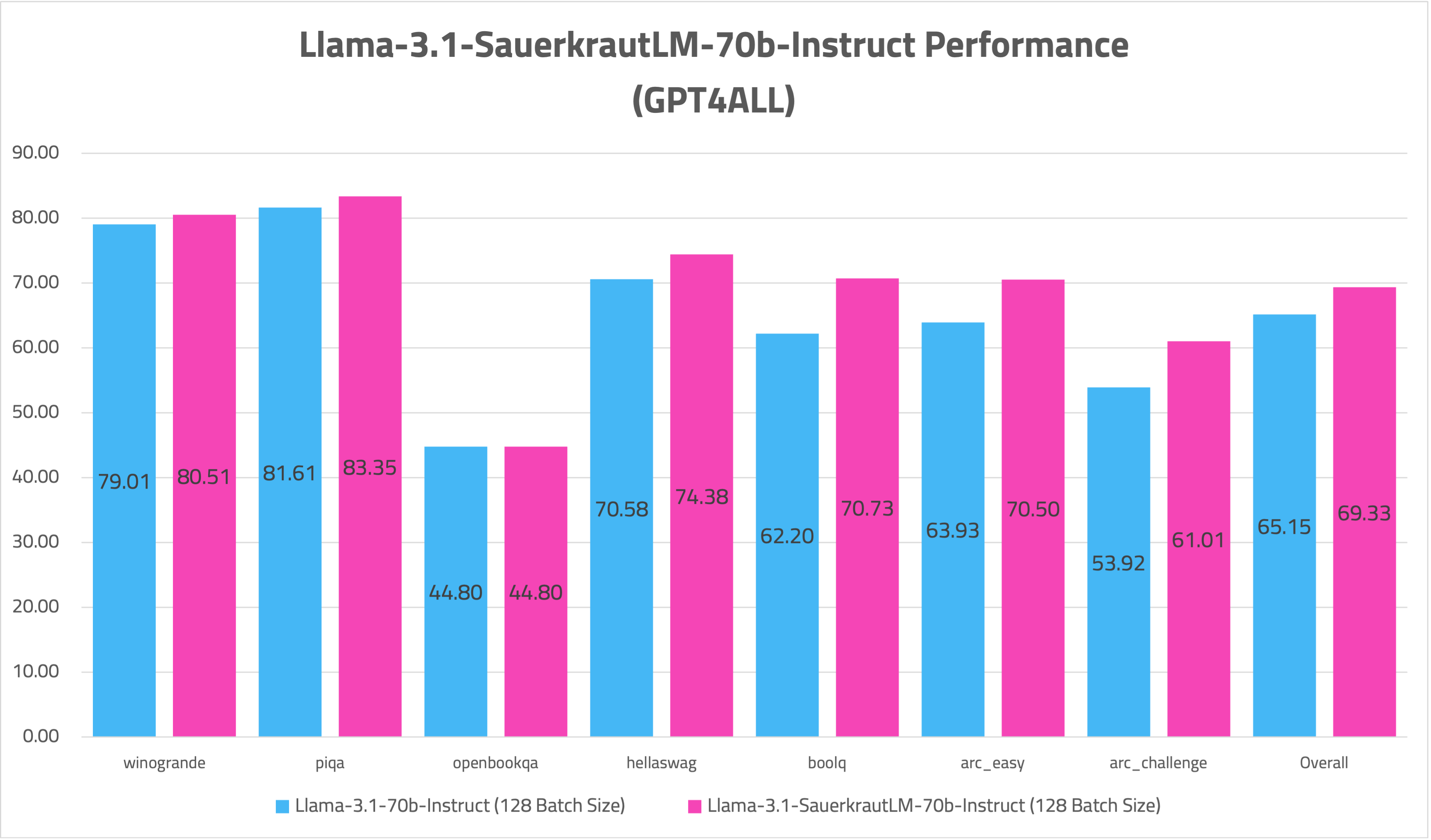

- GPT4ALL

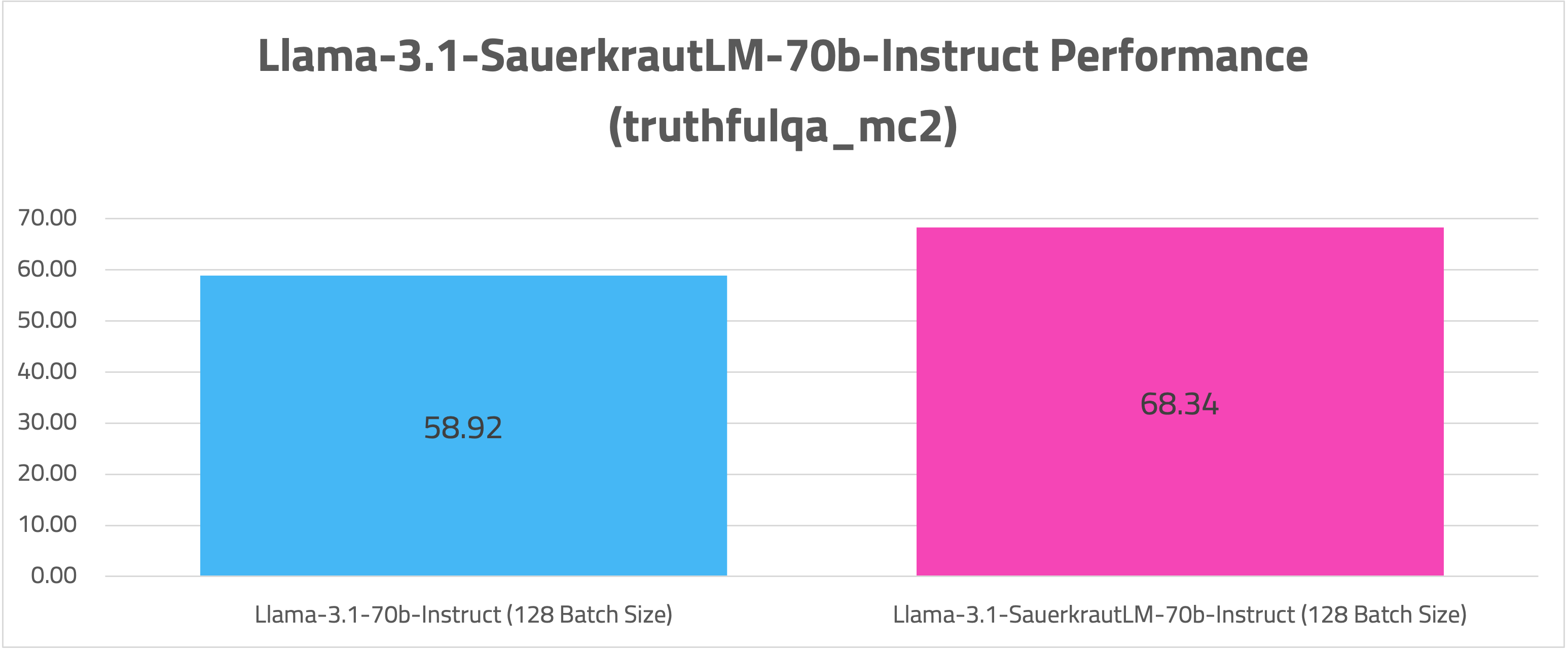

- TRUTHFULQA

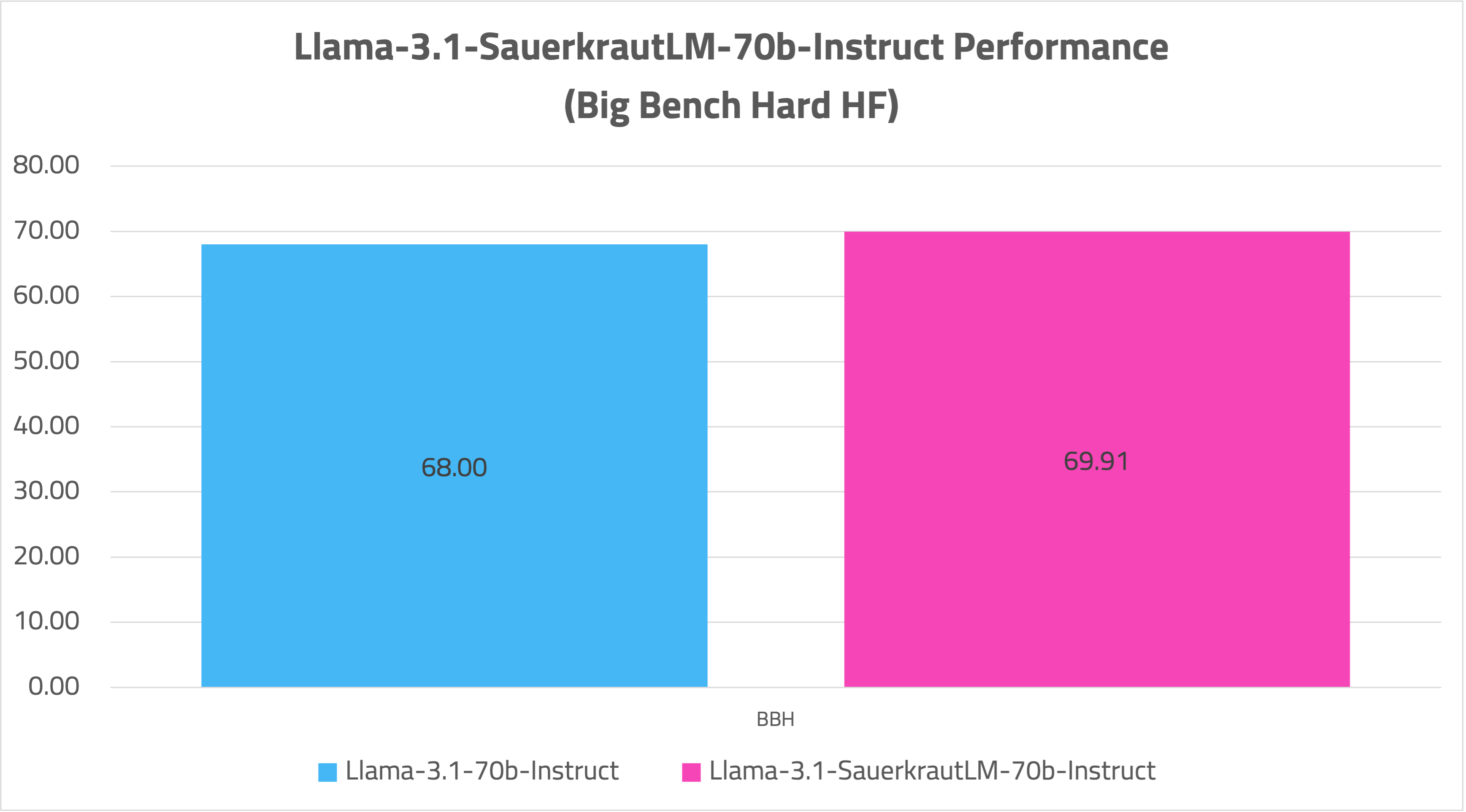

- BBH-HF

- MMLU-Multilingual

⚠️ 免責事項

私たちは、データクレンジングに最善を尽くしていますが、検閲されていないコンテンツが漏れる可能性を完全に排除することはできません。しかし、一貫した適切な動作を保証することはできません。したがって、何らかの問題や不適切なコンテンツに遭遇した場合、提供されている連絡先を通じて私たちに通知していただけるようお願いします。また、これらのモデルのライセンスは法的なアドバイスを構成するものではないことを理解することが重要です。私たちは、私たちのモデルを利用する第三者の行動について責任を負いません。

📞 コンタクト

ビジネスアプリケーション向けのカスタムLLMに興味がある場合は、当社のウェブサイトを通じてお問い合わせください。また、フィードバックや提案も大歓迎です。

🤝 コラボレーション

当社のスタートアップであるVAGO solutionsでは、多様な目的と要件に対応する堅牢な言語モデルの開発を継続的に進めています。私たちは、このプロジェクトへの支援と投資を積極的に求めています。もし、将来の課題に共同で取り組むことに興味がある場合は、VAGO solutionsまでお問い合わせください。

🙏 謝辞

meta-llamaに、オープンソースコミュニティにこのような貴重なモデルを提供してくれたことに感謝いたします。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語