🚀 ByT5 - xl

ByT5は、GoogleのT5のトークナイザーを使用しないバージョンで、一般的にMT5のアーキテクチャに従っています。ByT5は、平均20のUTF - 8文字のスパンマスクを使用し、教師あり学習を一切行わず、mC4でのみ事前学習されています。そのため、このモデルは下流タスクで使用する前に微調整する必要があります。ByT5は、ノイズの多いテキストデータで特に良好な性能を発揮します。例えば、google/byt5-xlはTweetQAでmt5-xlを大幅に上回っています。

🚀 クイックスタート

ByT5は、生のUTF - 8バイトで動作し、トークナイザーを使用せずに利用できます。

💻 使用例

基本的な使用法

from transformers import T5ForConditionalGeneration

import torch

model = T5ForConditionalGeneration.from_pretrained('google/byt5-xl')

input_ids = torch.tensor([list("Life is like a box of chocolates.".encode("utf-8"))]) + 3

labels = torch.tensor([list("La vie est comme une boîte de chocolat.".encode("utf-8"))]) + 3

loss = model(input_ids, labels=labels).loss

高度な使用法

バッチ推論とトレーニングの場合は、パディングのためにトークナイザークラスを使用することをおすすめします。

from transformers import T5ForConditionalGeneration, AutoTokenizer

model = T5ForConditionalGeneration.from_pretrained('google/byt5-xl')

tokenizer = AutoTokenizer.from_pretrained('google/byt5-xl')

model_inputs = tokenizer(["Life is like a box of chocolates.", "Today is Monday."], padding="longest", return_tensors="pt")

labels = tokenizer(["La vie est comme une boîte de chocolat.", "Aujourd'hui c'est lundi."], padding="longest", return_tensors="pt").input_ids

loss = model(**model_inputs, labels=labels).loss

📚 ドキュメント

概要

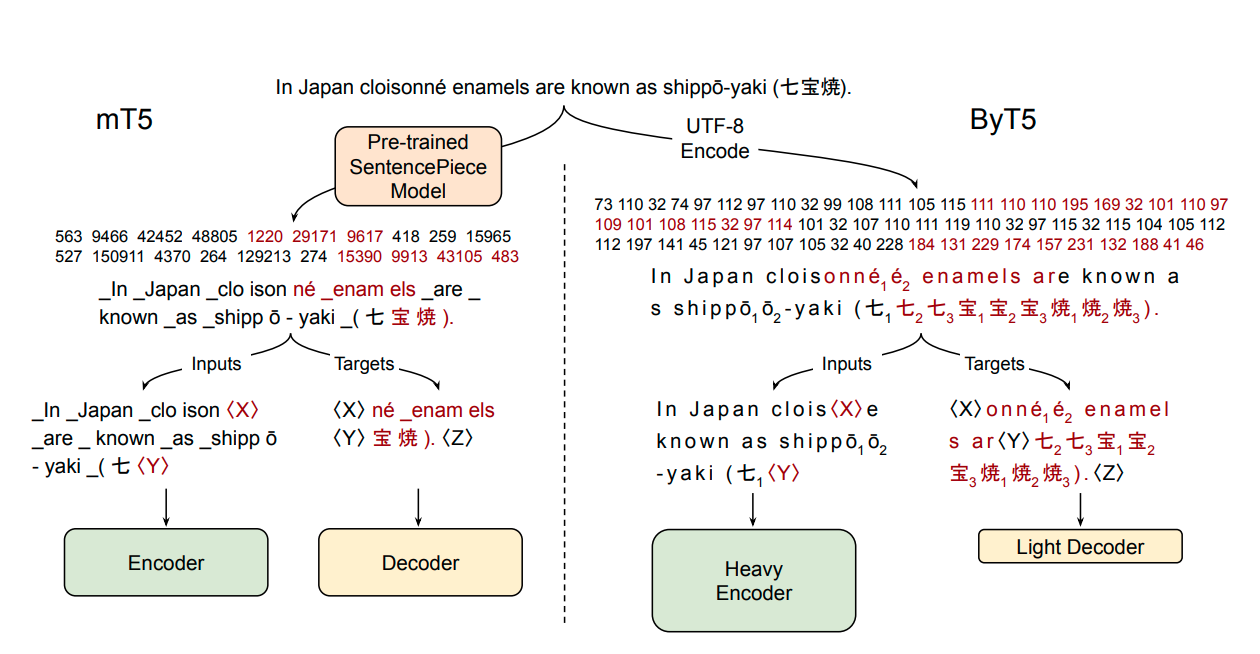

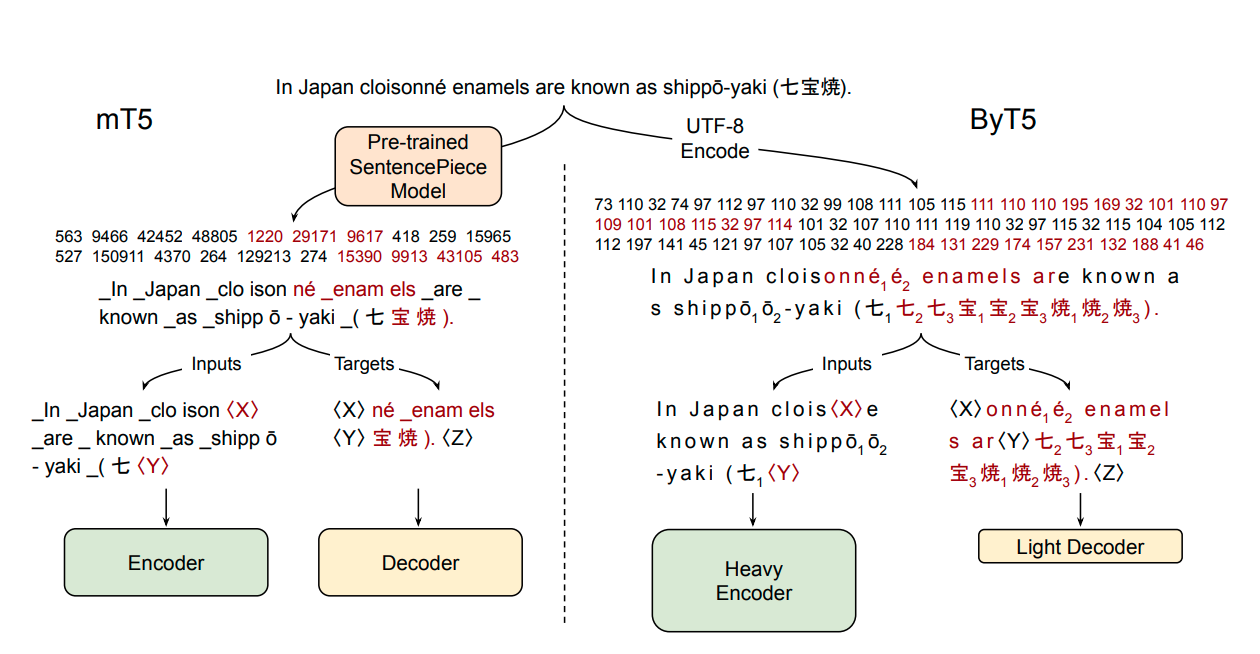

ほとんどの広く使用されている事前学習言語モデルは、単語またはサブワード単位に対応するトークンのシーケンスで動作します。テキストをトークンのシーケンスとしてエンコードするには、通常、モデルとは独立したアーティファクトとして作成されるトークナイザーが必要です。代わりに生のテキスト(バイトまたは文字)で直接動作するトークンフリーのモデルには多くの利点があります。すなわち、どの言語のテキストでもそのまま処理でき、ノイズに対してより強く、複雑でエラーが発生しやすいテキスト前処理パイプラインを削除することで技術的負債を最小限に抑えることができます。バイトまたは文字シーケンスはトークンシーケンスよりも長いため、これまでのトークンフリーモデルの研究では、生のテキストで直接動作するコストを分散させるために新しいモデルアーキテクチャを導入することが多かったです。この論文では、標準的なTransformerアーキテクチャを最小限の変更でバイトシーケンスを処理するために使用できることを示します。パラメータ数、トレーニングFLOP、および推論速度の観点からトレードオフを慎重に分析し、バイトレベルのモデルがトークンレベルのモデルと競争力があることを示します。また、バイトレベルのモデルはノイズに対して大幅に強く、綴りや発音に敏感なタスクでより良い性能を発揮することを実証します。私たちの貢献の一環として、T5アーキテクチャに基づく新しい事前学習済みバイトレベルのTransformerモデルのセットと、実験で使用したすべてのコードとデータを公開します。

📄 ライセンス

このモデルはApache - 2.0ライセンスの下で提供されています。

言語サポート

このモデルは以下の言語をサポートしています。

- multilingual

- af

- am

- ar

- az

- be

- bg

- bn

- ca

- ceb

- co

- cs

- cy

- da

- de

- el

- en

- eo

- es

- et

- eu

- fa

- fi

- fil

- fr

- fy

- ga

- gd

- gl

- gu

- ha

- haw

- hi

- hmn

- ht

- hu

- hy

- ig

- is

- it

- iw

- ja

- jv

- ka

- kk

- km

- kn

- ko

- ku

- ky

- la

- lb

- lo

- lt

- lv

- mg

- mi

- mk

- ml

- mn

- mr

- ms

- mt

- my

- ne

- nl

- no

- ny

- pa

- pl

- ps

- pt

- ro

- ru

- sd

- si

- sk

- sl

- sm

- sn

- so

- sq

- sr

- st

- su

- sv

- sw

- ta

- te

- tg

- th

- tr

- uk

- und

- ur

- uz

- vi

- xh

- yi

- yo

- zh

- zu

データセット

このモデルはmC4データセットを使用して事前学習されています。

論文情報

論文: ByT5: Towards a token - free future with pre - trained byte - to - byte models

著者: Linting Xue, Aditya Barua, Noah Constant, Rami Al - Rfou, Sharan Narang, Mihir Kale, Adam Roberts, Colin Raffel

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語