T5 Large Ssm

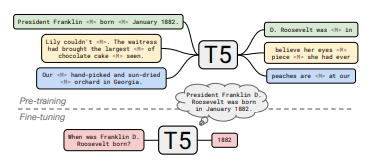

T5アーキテクチャに基づく閉卷式質問応答モデルで、事前学習と増分学習により外部知識源を必要としない質問応答能力を実現します。

ダウンロード数 75

リリース時間 : 3/2/2022

モデル概要

このモデルはT5アーキテクチャを採用し、まずC4データセットで事前学習を行い、次にウィキペディアで増分学習を行い、閉卷式質問応答タスクに特化しています。下流タスクで微調整する必要があります。

モデル特徴

閉卷式質問応答能力

外部知識源やコンテキストに依存せず、直接モデルパラメータから知識を検索して質問に答えます。

二段階学習

まずC4データセットで標準的なノイズ除去事前学習を行い、次にウィキペディアで顕著な断片マスク増分学習を行います。

拡張性

研究によると、モデルの性能は規模の拡大とともに向上し、オープンドメイン質問応答システムと同等の性能を発揮します。

モデル能力

知識検索

質問応答生成

テキスト理解

使用事例

教育

知識質問応答システム

外部知識ベースにアクセスする必要のないインテリジェント質問応答システムを構築します。

検索に依存するオープンドメインシステムと同等の性能を発揮します。

研究

知識封入研究

言語モデルのパラメータに封入された知識量を研究します。

モデルパラメータが知識を効果的に保存および検索できることを検証しました。

おすすめAIモデル

Llama 3 Typhoon V1.5x 8b Instruct

タイ語専用に設計された80億パラメータの命令モデルで、GPT-3.5-turboに匹敵する性能を持ち、アプリケーションシナリオ、検索拡張生成、制限付き生成、推論タスクを最適化

大規模言語モデル Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-TinyはSODAデータセットでトレーニングされた超小型対話モデルで、エッジデバイス推論向けに設計されており、体積はCosmo-3Bモデルの約2%です。

対話システム Transformers 英語

Transformers 英語

Transformers 英語

Transformers 英語C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

RoBERTaアーキテクチャに基づく中国語抽出型QAモデルで、与えられたテキストから回答を抽出するタスクに適しています。

質問応答システム 中国語

R

uer

2,694

98