🚀 GoogleのT5(クローズドブック質問応答用)

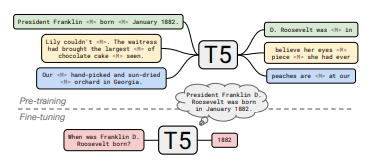

このモデルは、クローズドブック質問応答(Closed Book Question Answering)に特化したGoogleのT5モデルです。事前学習とファインチューニングを経て、質問に対する回答能力を向上させています。

🚀 クイックスタート

GoogleのT5 を使用した クローズドブック質問応答 のモデルです。

このモデルは、まず C4 データセットを用いてT5のノイズ除去目的で事前学習され、次に Wikipedia データセットを用いて REALM の顕著なスパンマスキング目的で追加の事前学習が行われ、最後に Natural Questions (NQ) データセットでファインチューニングされました。

⚠️ 重要提示

このモデルは、Natural Questions (NQ) のトレインデータの100%を使って10,000ステップでファインチューニングされています。

他のコミュニティのチェックポイントは こちら です。

論文: How Much Knowledge Can You Pack

Into the Parameters of a Language Model?

著者: Adam Roberts, Colin Raffel, Noam Shazeer

✨ 主な機能

このモデルは、事前学習とファインチューニングを通じて、クローズドブック質問応答タスクで良好な性能を発揮します。モデルサイズに応じて性能が向上することが確認されています。

📚 ドキュメント

Natural Questions - テストセットでの結果

| ID |

リンク |

完全一致率 |

| T5-small |

https://huggingface.co/google/t5-small-ssm-nq |

25.5 |

| T5-large |

https://huggingface.co/google/t5-large-ssm-nq |

30.4 |

| T5-xl |

https://huggingface.co/google/t5-xl-ssm-nq |

35.6 |

| T5-xxl |

https://huggingface.co/google/t5-xxl-ssm-nq |

37.9 |

| T5-3b |

https://huggingface.co/google/t5-3b-ssm-nq |

33.2 |

| T5-11b |

https://huggingface.co/google/t5-11b-ssm-nq |

36.6 |

概要

最近の研究では、非構造化テキストで学習されたニューラル言語モデルが、自然言語クエリを使用して暗黙的に知識を保存および取得できることが明らかになっています。この論文では、事前学習されたモデルを外部のコンテキストや知識にアクセスせずに質問に答えるようにファインチューニングすることで、このアプローチの実用性を測定しています。結果として、このアプローチはモデルサイズに応じて拡張可能であり、質問に答える際に外部の知識ソースから明示的に回答を取得するオープンドメインシステムと競合する性能を発揮することが示されています。再現性と将来の研究を容易にするために、コードと学習済みモデルを こちら で公開しています。

💻 使用例

基本的な使用法

このモデルは、以下のように クローズドブック質問応答 に使用できます。

from transformers import AutoModelForSeq2SeqLM, AutoTokenizer

t5_qa_model = AutoModelForSeq2SeqLM.from_pretrained("google/t5-xl-ssm-nq")

t5_tok = AutoTokenizer.from_pretrained("google/t5-xl-ssm-nq")

input_ids = t5_tok("When was Franklin D. Roosevelt born?", return_tensors="pt").input_ids

gen_output = t5_qa_model.generate(input_ids)[0]

print(t5_tok.decode(gen_output, skip_special_tokens=True))

📄 ライセンス

このモデルは Apache-2.0 ライセンスの下で提供されています。

📦 データセット情報

| 属性 |

详情 |

| モデルタイプ |

Closed Book Question Answering |

| 学習データ |

C4、Wikipedia、Natural Questions |

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語