モデル概要

モデル特徴

モデル能力

使用事例

license: apache-2.0 language:

- en

- zh pipeline_tag: text-to-video library_name: diffusers tags:

- video

- video-generation

ワンファン

😊 ようこそ!

目次

モデルアドレス

V1.1:

| 名称 | ストレージ容量 | Hugging Face | Model Scope | 説明 |

|---|---|---|---|---|

| Wan2.1-Fun-V1.1-1.3B-InP | 19.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-V1.1-1.3Bテキスト/画像から動画生成の重み、マルチ解像度でトレーニングされ、開始/終了画像予測をサポート。 |

| Wan2.1-Fun-V1.1-14B-InP | 47.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-V1.1-14Bテキスト/画像から動画生成の重み、マルチ解像度でトレーニングされ、開始/終了画像予測をサポート。 |

| Wan2.1-Fun-V1.1-1.3B-Control | 19.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-V1.1-1.3B動画制御重み、Canny、Depth、Pose、MLSDなどの異なる制御条件をサポート、参照画像+制御条件による制御、軌跡制御をサポート。マルチ解像度(512、768、1024)の動画予測をサポート、81フレーム、毎秒16フレームでトレーニング、多言語予測をサポート |

| Wan2.1-Fun-V1.1-14B-Control | 47.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-V1.1-14B動画制御重み、Canny、Depth、Pose、MLSDなどの異なる制御条件をサポート、参照画像+制御条件による制御、軌跡制御をサポート。マルチ解像度(512、768、1024)の動画予測をサポート、81フレーム、毎秒16フレームでトレーニング、多言語予測をサポート |

| Wan2.1-Fun-V1.1-1.3B-Control-Camera | 19.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-V1.1-1.3Bカメラ制御重み。マルチ解像度(512、768、1024)の動画予測をサポート、81フレーム、毎秒16フレームでトレーニング、多言語予測をサポート |

| Wan2.1-Fun-V1.1-14B-Control | 47.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-V1.1-14Bカメラ制御重み。マルチ解像度(512、768、1024)の動画予測をサポート、81フレーム、毎秒16フレームでトレーニング、多言語予測をサポート |

V1.0:

| 名称 | ストレージ容量 | Hugging Face | Model Scope | 説明 |

|---|---|---|---|---|

| Wan2.1-Fun-1.3B-InP | 19.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-1.3Bテキスト/画像から動画生成の重み、マルチ解像度でトレーニングされ、開始/終了画像予測をサポート。 |

| Wan2.1-Fun-14B-InP | 47.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-14Bテキスト/画像から動画生成の重み、マルチ解像度でトレーニングされ、開始/終了画像予測をサポート。 |

| Wan2.1-Fun-1.3B-Control | 19.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-1.3B動画制御重み、Canny、Depth、Pose、MLSDなどの異なる制御条件をサポート、軌跡制御をサポート。マルチ解像度(512、768、1024)の動画予測をサポート、81フレーム、毎秒16フレームでトレーニング、多言語予測をサポート |

| Wan2.1-Fun-14B-Control | 47.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-14B動画制御重み、Canny、Depth、Pose、MLSDなどの異なる制御条件をサポート、軌跡制御をサポート。マルチ解像度(512、768、1024)の動画予測をサポート、81フレーム、毎秒16フレームでトレーニング、多言語予測をサポート |

動画作品

Wan2.1-Fun-V1.1-14B-InP && Wan2.1-Fun-V1.1-1.3B-InP

Wan2.1-Fun-V1.1-14B-Control && Wan2.1-Fun-V1.1-1.3B-Control

汎用制御動画 + 参照画像:

| 参照画像 | 制御動画 | Wan2.1-Fun-V1.1-14B-Control | Wan2.1-Fun-V1.1-1.3B-Control |

|

|

|||

汎用制御動画(Canny、Pose、Depthなど)と軌跡制御:

Wan2.1-Fun-V1.1-14B-Control-Camera && Wan2.1-Fun-V1.1-1.3B-Control-Camera

| パンアップ | パン左 | パン右 |

| パンダウン | パンアップ + パン左 | パンアップ + パン右 |

クイックスタート

1. クラウド利用: AliyunDSW/Docker

a. 阿里雲 DSW 経由

DSWには無料のGPU時間があり、ユーザーは1回申請でき、申請後3ヶ月間有効です。

阿里雲はFreetierで無料GPU時間を提供しており、阿里雲PAI-DSWで利用でき、5分以内でCogVideoX-Funを起動できます。

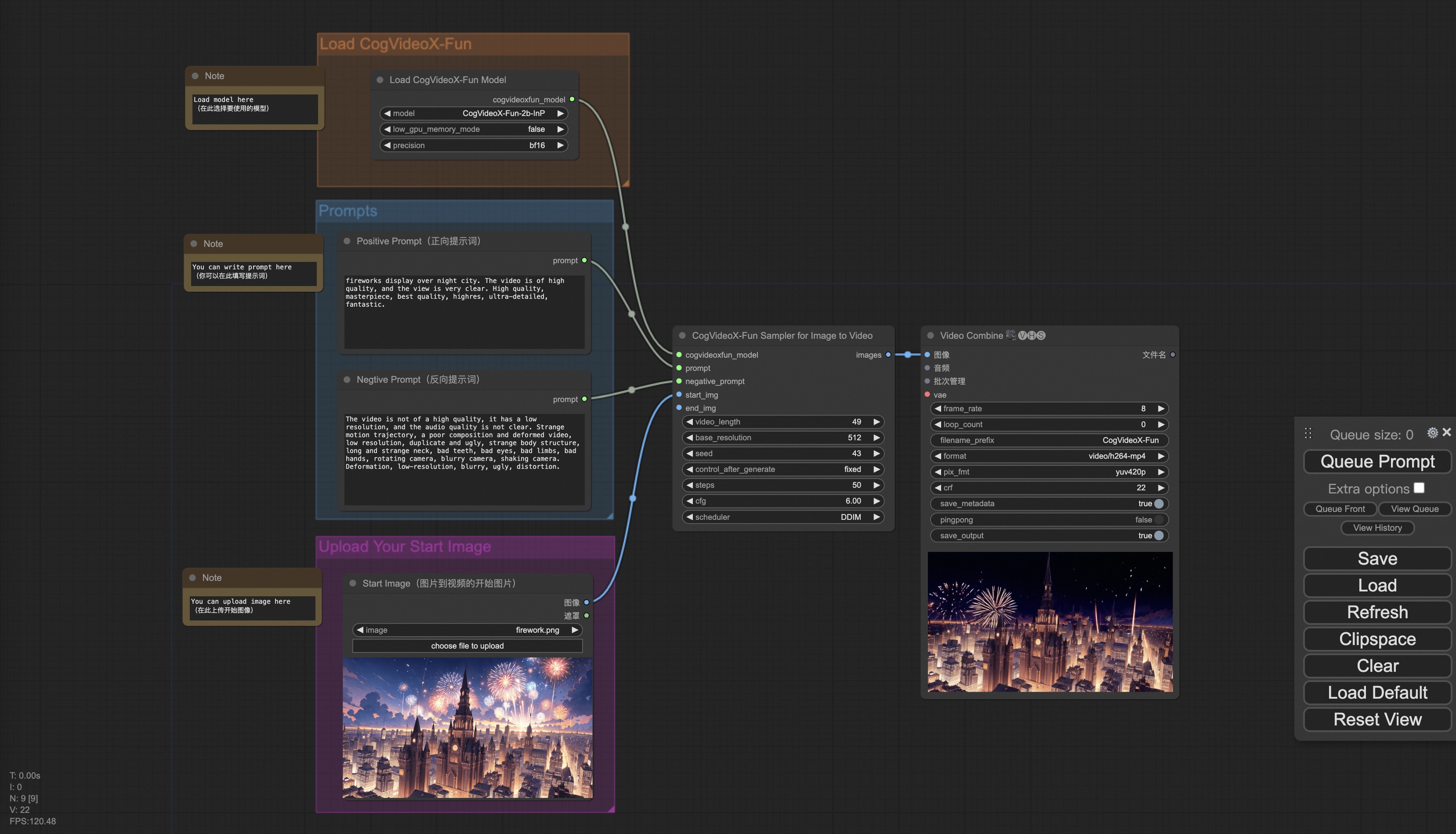

b. ComfyUI経由

当社のComfyUIインターフェースは以下の通りで、詳細はComfyUI READMEをご覧ください。

c. docker経由

dockerを使用する場合、マシンに適切にGPUドライバとCUDA環境がインストールされていることを確認し、以下のコマンドを順次実行してください:

# イメージをプル

docker pull mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# イメージに入る

docker run -it -p 7860:7860 --network host --gpus all --security-opt seccomp:unconfined --shm-size 200g mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# コードをクローン

git clone https://github.com/aigc-apps/VideoX-Fun.git

# VideoX-Funのディレクトリに入る

cd VideoX-Fun

# 重みをダウンロード

mkdir models/Diffusion_Transformer

mkdir models/Personalized_Model

# モデルをダウンロードするにはhuggingfaceリンクまたはmodelscopeリンクを使用してください。

# CogVideoX-Fun

# https://huggingface.co/alibaba-pai/CogVideoX-Fun-V1.1-5b-InP

# https://modelscope.cn/models/PAI/CogVideoX-Fun-V1.1-5b-InP

# Wan

# https://huggingface.co/alibaba-pai/Wan2.1-Fun-V1.1-14B-InP

# https://modelscope.cn/models/PAI/Wan2.1-Fun-V1.1-14B-InP

2. ローカルインストール: 環境チェック/ダウンロード/インストール

a. 環境チェック

このライブラリが以下の環境で実行可能であることを確認しました:

Windows の詳細:

- OS Windows 10

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU: Nvidia-3060 12G & Nvidia-3090 24G

Linux の詳細:

- OS Ubuntu 20.04, CentOS

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU:Nvidia-V100 16G & Nvidia-A10 24G & Nvidia-A100 40G & Nvidia-A100 80G

約60GBの空きディスク容量が必要です。確認してください!

b. 重みの配置

重みを指定されたパスに配置することをお勧めします:

comfyui経由:

モデルをComfyuiの重みフォルダComfyUI/models/Fun_Models/に配置:

📦 ComfyUI/

├── 📂 models/

│ └── 📂 Fun_Models/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

自身のpythonファイルまたはuiインターフェースを実行:

📦 models/

├── 📂 Diffusion_Transformer/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

├── 📂 Personalized_Model/

│ └── トレーニング済みのtransformerモデル / トレーニング済みのloraモデル(UIロード用)

使用方法

1. 生成

a、VRAM節約オプション

Wan2.1のパラメータは非常に大きいため、VRAMを節約してコンシューマーグレードのGPUに対応するために、VRAM節約オプションを考慮する必要があります。各予測ファイルにはGPU_memory_modeが提供されており、model_cpu_offload、model_cpu_offload_and_qfloat8、sequential_cpu_offloadから選択できます。このオプションはCogVideoX-Funの生成にも適用されます。

- model_cpu_offloadは、モデル全体が使用後にCPUに移動し、一部のVRAMを節約します。

- model_cpu_offload_and_qfloat8は、モデル全体が使用後にCPUに移動し、transformerモデルをfloat8で量子化し、さらに多くのVRAMを節約します。

- sequential_cpu_offloadは、モデルの各レイヤーが使用後にCPUに移動し、速度は遅いですが、大量のVRAMを節約します。

qfloat8はモデルの性能を一部低下させますが、より多くのVRAMを節約できます。VRAMが十分にある場合は、model_cpu_offloadを使用することをお勧めします。

b、ComfyUI経由

詳細はComfyUI READMEをご覧ください。

c、pythonファイルの実行

- ステップ1:対応する重みをダウンロードし、modelsフォルダに配置します。

- ステップ2:異なる重みと予測目標に応じて異なるファイルを使用して予測します。現在、このライブラリはCogVideoX-Fun、Wan2.1、Wan2.1-Funをサポートしており、examplesフォルダ内のフォルダ名で区別されています。異なるモデルは異なる機能をサポートしているため、具体的な状況に応じて区別してください。CogVideoX-Funを例に挙げます。

- テキストから動画生成:

- examples/cogvideox_fun/predict_t2v.pyファイルでprompt、neg_prompt、guidance_scale、seedを変更します。

- その後、examples/cogvideox_fun/predict_t2v.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videosフォルダに保存されます。

- 画像から動画生成:

- examples/cogvideox_fun/predict_i2v.pyファイルでvalidation_image_start、validation_image_end、prompt、neg_prompt、guidance_scale、seedを変更します。

- validation_image_startは動画の開始画像、validation_image_endは動画の終了画像です。

- その後、examples/cogvideox_fun/predict_i2v.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videos_i2vフォルダに保存されます。

- 動画から動画生成:

- examples/cogvideox_fun/predict_v2v.pyファイルでvalidation_video、validation_image_end、prompt、neg_prompt、guidance_scale、seedを変更します。

- validation_videoは動画から動画生成の参照動画です。以下の動画を使用してデモを実行できます:デモ動画

- その後、examples/cogvideox_fun/predict_v2v.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videos_v2vフォルダに保存されます。

- 汎用制御から動画生成(Canny、Pose、Depthなど):

- examples/cogvideox_fun/predict_v2v_control.pyファイルでcontrol_video、validation_image_end、prompt、neg_prompt、guidance_scale、seedを変更します。

- control_videoは制御から動画生成の制御動画で、Canny、Pose、Depthなどの演算子で抽出された動画です。以下の動画を使用してデモを実行できます:デモ動画

- その後、examples/cogvideox_fun/predict_v2v_control.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videos_v2v_controlフォルダに保存されます。

- テキストから動画生成:

- ステップ3:自身でトレーニングした他のbackboneやLoraと組み合わせたい場合は、examples/{model_name}/predict_t2v.pyおよびexamples/{model_name}/predict_i2v.pyのlora_pathを適宜変更します。

d、UIインターフェース経由

webuiはテキストから動画生成、画像から動画生成、動画から動画生成、汎用制御から動画生成(Canny、Pose、Depthなど)をサポートしています。現在、このライブラリはCogVideoX-Fun、Wan2.1、Wan2.1-Funをサポートしており、examplesフォルダ内のフォルダ名で区別されています。異なるモデルは異なる機能をサポートしているため、具体的な状況に応じて区別してください。CogVideoX-Funを例に挙げます。

- ステップ1:対応する重みをダウンロードし、modelsフォルダに配置します。

- ステップ2:examples/cogvideox_fun/app.pyファイルを実行し、gradioページに移動します。

- ステップ3:ページで生成モデルを選択し、prompt、neg_prompt、guidance_scale、seedなどを入力し、生成をクリックして結果を待ちます。結果はsampleフォルダに保存されます。

参考文献

- CogVideo: https://github.com/THUDM/CogVideo/

- EasyAnimate: https://github.com/aigc-apps/EasyAnimate

- Wan2.1: https://github.com/Wan-Video/Wan2.1/

- ComfyUI-KJNodes: https://github.com/kijai/ComfyUI-KJNodes

- ComfyUI-EasyAnimateWrapper: https://github.com/kijai/ComfyUI-EasyAnimateWrapper

- ComfyUI-CameraCtrl-Wrapper: https://github.com/chaojie/ComfyUI-CameraCtrl-Wrapper

- CameraCtrl: https://github.com/hehao13/CameraCtrl

ライセンス

このプロジェクトは Apache License (Version 2.0) を使用しています。

Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語