🚀 LaMini-Flan-T5-783M

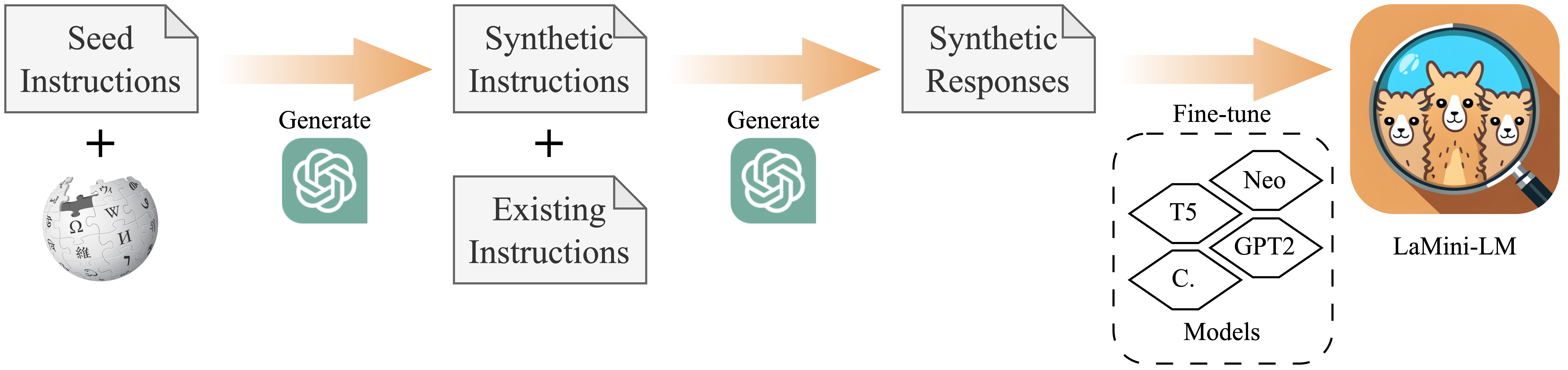

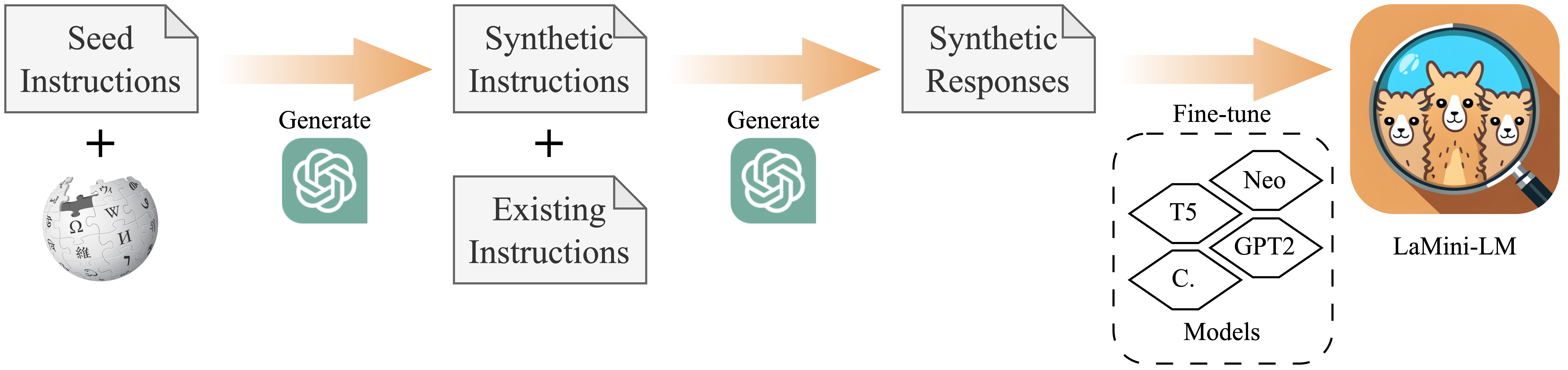

このモデルは、論文「LaMini-LM: A Diverse Herd of Distilled Models from Large-Scale Instructions」にて紹介されているLaMini-LMモデルシリーズの一つです。このモデルは、google/flan-t5-largeをLaMini-instruction dataset(命令微調整用の258万件のサンプルを含む)で微調整したバージョンです。データセットに関する詳細情報は、プロジェクトリポジトリを参照してください。

以下に、LaMini-LMシリーズの他のモデルを示します。✩ が付いているモデルは、そのサイズ/アーキテクチャにおいて総合的な性能が最も良いため、使用をおすすめします。詳細は論文を参照してください。

🚀 クイックスタート

想定される使用方法

このモデルは、自然言語で記述された人間の命令に応答するために使用することをおすすめします。

以下に、HuggingFaceのpipeline()を使用してモデルをロードし、使用する方法を示します。

from transformers import pipeline

checkpoint = "{model_name}"

model = pipeline('text2text-generation', model = checkpoint)

input_prompt = 'Please let me know your thoughts on the given place and why you think it deserves to be visited: \n"Barcelona, Spain"'

generated_text = model(input_prompt, max_length=512, do_sample=True)[0]['generated_text']

print("Response", generated_text)

✨ 主な機能

このモデルは、自然言語で記述された命令に対して応答することができます。

📦 インストール

pip install -q transformers

💻 使用例

基本的な使用法

from transformers import pipeline

checkpoint = "{model_name}"

model = pipeline('text2text-generation', model = checkpoint)

input_prompt = 'Please let me know your thoughts on the given place and why you think it deserves to be visited: \n"Barcelona, Spain"'

generated_text = model(input_prompt, max_length=512, do_sample=True)[0]['generated_text']

print("Response", generated_text)

📚 ドキュメント

学習手順

このモデルは、google/flan-t5-largeを初期化し、LaMini-instruction datasetで微調整しています。総パラメータ数は783Mです。

学習ハイパーパラメータ

学習時には以下のハイパーパラメータが使用されました。

- learning_rate: 0.0005

- train_batch_size: 128

- eval_batch_size: 64

- seed: 42

- gradient_accumulation_steps: 4

- total_train_batch_size: 512

- optimizer: Adam with betas=(0.9,0.999) and epsilon=1e-08

- lr_scheduler_type: linear

- num_epochs: 5

評価

下流のNLPタスクに対する自動評価と、ユーザー向けの命令に対する人間評価の2種類の評価を行っています。詳細については、論文を参照してください。

制限事項

詳細情報が必要です。

🔧 技術詳細

このモデルは、google/flan-t5-largeを初期化し、LaMini-instruction datasetで微調整しています。総パラメータ数は783Mです。

📄 ライセンス

このモデルは、CC By NC 4.0ライセンスの下で提供されています。

引用

@article{lamini-lm,

author = {Minghao Wu and

Abdul Waheed and

Chiyu Zhang and

Muhammad Abdul-Mageed and

Alham Fikri Aji

},

title = {LaMini-LM: A Diverse Herd of Distilled Models from Large-Scale Instructions},

journal = {CoRR},

volume = {abs/2304.14402},

year = {2023},

url = {https://arxiv.org/abs/2304.14402},

eprinttype = {arXiv},

eprint = {2304.14402}

}

モデル情報

LaMini-LMシリーズのモデル一覧

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語