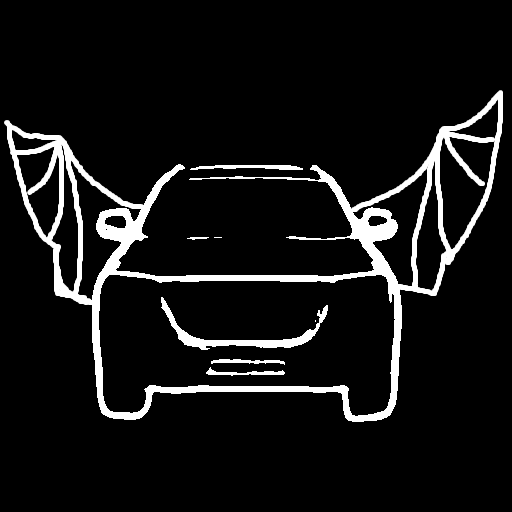

🚀 T2I Adapter - Zoedepth

T2I Adapterは、Stable Diffusionに追加の条件付けを提供するネットワークです。各T2Iチェックポイントは、異なるタイプの条件付けを入力として受け取り、特定の基本Stable Diffusionチェックポイントと共に使用されます。

このチェックポイントは、Stable Diffusion 1.5チェックポイントに対して、ZoeDepthの深度推定による条件付けを提供します。

✨ 主な機能

T2I Adapterは、Stable Diffusionに追加の条件付けを提供することで、より多くの制御可能な能力を引き出すことができます。このチェックポイントは、ZoeDepthの深度推定に基づいて、画像生成を制御することができます。

📦 インストール

依存関係のインストール

pip install diffusers transformers matplotlib

💻 使用例

基本的な使用法

from PIL import Image

import torch

import numpy as np

import matplotlib

from diffusers import T2IAdapter, StableDiffusionAdapterPipeline

def colorize(value, vmin=None, vmax=None, cmap='gray_r', invalid_val=-99, invalid_mask=None, background_color=(128, 128, 128, 255), gamma_corrected=False, value_transform=None):

"""Converts a depth map to a color image.

Args:

value (torch.Tensor, numpy.ndarry): Input depth map. Shape: (H, W) or (1, H, W) or (1, 1, H, W). All singular dimensions are squeezed

vmin (float, optional): vmin-valued entries are mapped to start color of cmap. If None, value.min() is used. Defaults to None.

vmax (float, optional): vmax-valued entries are mapped to end color of cmap. If None, value.max() is used. Defaults to None.

cmap (str, optional): matplotlib colormap to use. Defaults to 'magma_r'.

invalid_val (int, optional): Specifies value of invalid pixels that should be colored as 'background_color'. Defaults to -99.

invalid_mask (numpy.ndarray, optional): Boolean mask for invalid regions. Defaults to None.

background_color (tuple[int], optional): 4-tuple RGB color to give to invalid pixels. Defaults to (128, 128, 128, 255).

gamma_corrected (bool, optional): Apply gamma correction to colored image. Defaults to False.

value_transform (Callable, optional): Apply transform function to valid pixels before coloring. Defaults to None.

Returns:

numpy.ndarray, dtype - uint8: Colored depth map. Shape: (H, W, 4)

"""

if isinstance(value, torch.Tensor):

value = value.detach().cpu().numpy()

value = value.squeeze()

if invalid_mask is None:

invalid_mask = value == invalid_val

mask = np.logical_not(invalid_mask)

vmin = np.percentile(value[mask],2) if vmin is None else vmin

vmax = np.percentile(value[mask],85) if vmax is None else vmax

if vmin != vmax:

value = (value - vmin) / (vmax - vmin)

else:

value = value * 0.

value[invalid_mask] = np.nan

cmapper = matplotlib.cm.get_cmap(cmap)

if value_transform:

value = value_transform(value)

value = cmapper(value, bytes=True)

img = value[...]

img[invalid_mask] = background_color

if gamma_corrected:

img = img / 255

img = np.power(img, 2.2)

img = img * 255

img = img.astype(np.uint8)

return img

model = torch.hub.load("isl-org/ZoeDepth", "ZoeD_N", pretrained=True)

img = Image.open('./images/zoedepth_in.png')

out = model.infer_pil(img)

zoedepth_image = Image.fromarray(colorize(out)).convert('RGB')

zoedepth_image.save('images/zoedepth.png')

adapter = T2IAdapter.from_pretrained("TencentARC/t2iadapter_zoedepth_sd15v1", torch_dtype=torch.float16)

pipe = StableDiffusionAdapterPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5", adapter=adapter, safety_checker=None, torch_dtype=torch.float16, variant="fp16"

)

pipe.to('cuda')

zoedepth_image_out = pipe(prompt="motorcycle", image=zoedepth_image).images[0]

zoedepth_image_out.save('images/zoedepth_out.png')

📚 ドキュメント

モデルの詳細

-

開発者: T2I-Adapter: Learning Adapters to Dig out More Controllable Ability for Text-to-Image Diffusion Models

-

モデルの種類: 拡散ベースのテキストから画像への生成モデル

-

言語: 英語

-

ライセンス: Apache 2.0

-

詳細情報のリソース: GitHubリポジトリ, 論文

-

引用情報:

@misc{

title={T2I-Adapter: Learning Adapters to Dig out More Controllable Ability for Text-to-Image Diffusion Models},

author={Chong Mou, Xintao Wang, Liangbin Xie, Yanze Wu, Jian Zhang, Zhongang Qi, Ying Shan, Xiaohu Qie},

year={2023},

eprint={2302.08453},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

チェックポイント

📄 ライセンス

このモデルは、Apache 2.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語