🚀 CogVideoX-Fun

😊 ようこそ!

English | 简体中文

🚀 クイックスタート

1. クラウドでの使用: AliyunDSW/Docker

a. 阿里云 DSW を通じて

DSW には無料の GPU 利用時間があり、ユーザーは1回申請でき、申請後3か月間有効です。

阿里云はFreetierで無料の GPU 利用時間を提供しており、取得して阿里云 PAI - DSW で使用すると、5分以内に CogVideoX - Fun を起動できます。

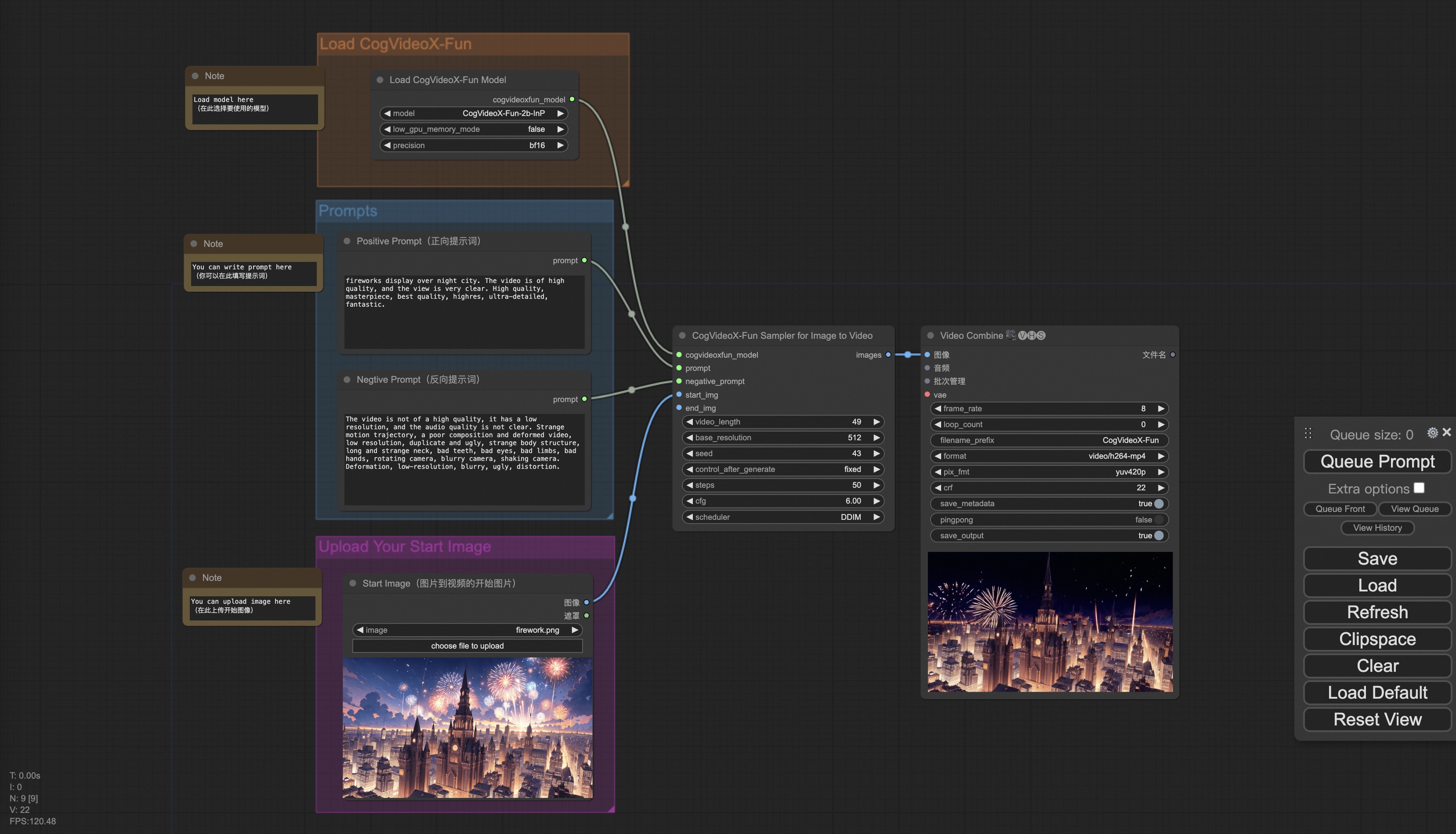

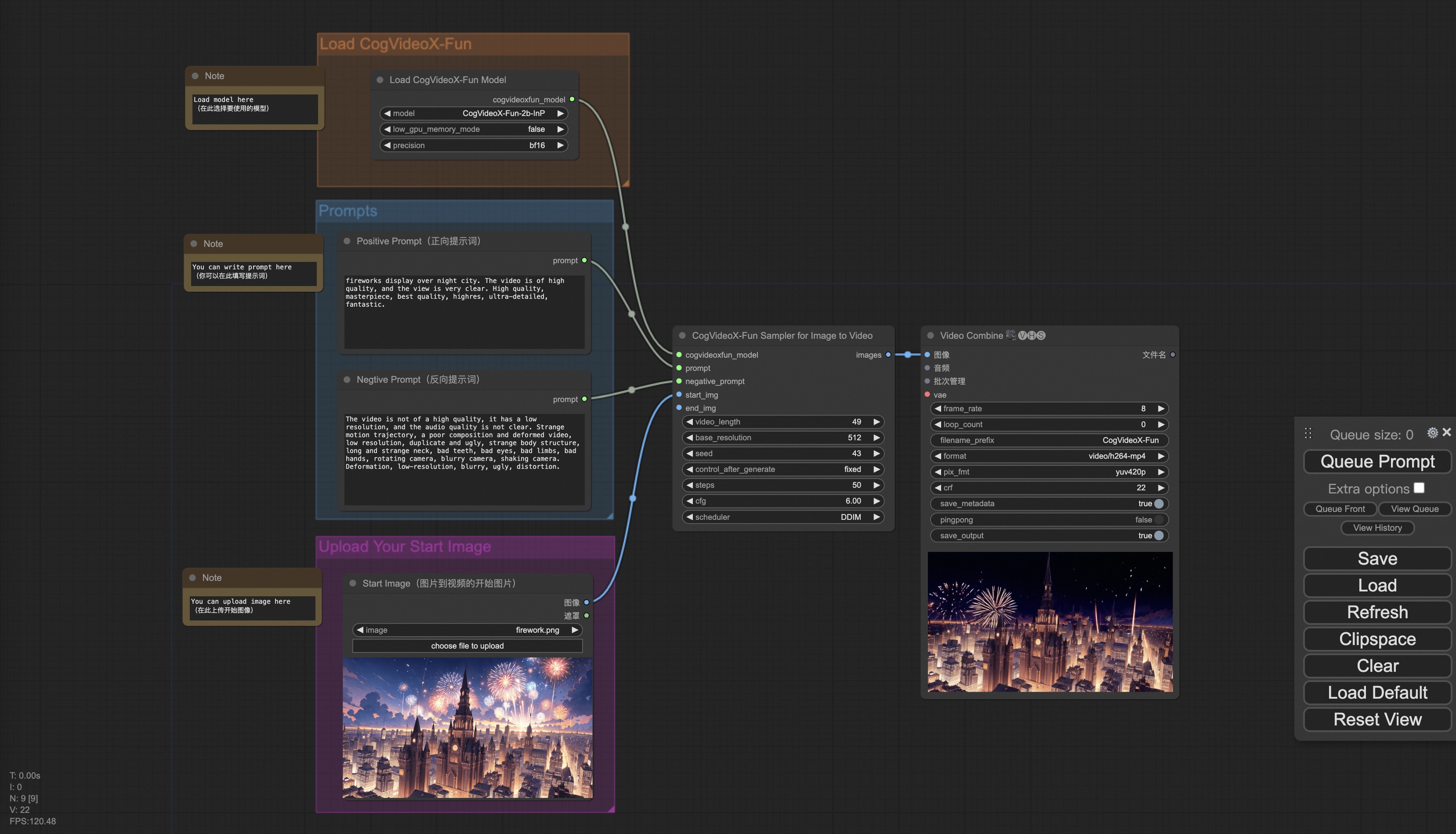

b. ComfyUI を通じて

ComfyUI のインターフェイスは以下の通りです。詳細はComfyUI READMEを参照してください。

c. docker を通じて

docker を使用する場合は、マシンに正しく GPU ドライバと CUDA 環境がインストールされていることを確認し、以下のコマンドを順に実行してください。

# pull image

docker pull mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# enter image

docker run -it -p 7860:7860 --network host --gpus all --security-opt seccomp:unconfined --shm-size 200g mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# clone code

git clone https://github.com/aigc-apps/CogVideoX-Fun.git

# enter CogVideoX-Fun's dir

cd CogVideoX-Fun

# download weights

mkdir models/Diffusion_Transformer

mkdir models/Personalized_Model

wget https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/cogvideox_fun/Diffusion_Transformer/CogVideoX-Fun-2b-InP.tar.gz -O models/Diffusion_Transformer/CogVideoX-Fun-2b-InP.tar.gz

cd models/Diffusion_Transformer/

tar -xvf CogVideoX-Fun-2b-InP.tar.gz

cd ../../

2. ローカルインストール: 環境チェック/ダウンロード/インストール

a. 環境チェック

CogVideoX - Fun が以下の環境で実行できることを確認しています。

Windows の詳細情報:

- オペレーティングシステム Windows 10

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU: Nvidia - 3060 12G & Nvidia - 3090 24G

Linux の詳細情報:

- オペレーティングシステム Ubuntu 20.04, CentOS

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU:Nvidia - V100 16G & Nvidia - A10 24G & Nvidia - A100 40G & Nvidia - A100 80G

約 60GB の空きディスク容量が必要ですので、確認してください。

b. 重みの配置

重みを指定されたパスに配置することをおすすめします。

📦 models/

├── 📂 Diffusion_Transformer/

│ ├── 📂 CogVideoX-Fun-2b-InP/

│ └── 📂 CogVideoX-Fun-5b-InP/

├── 📂 Personalized_Model/

│ └── あなたが訓練したトランスフォーマーモデル / あなたが訓練した lora モデル (UI ロード用)

✨ 主な機能

CogVideoX - Funは、CogVideoX構造を修正したパイプラインで、生成条件がより自由なCogVideoXです。AI画像とビデオの生成、Diffusion TransformerのベースラインモデルとLoraモデルの訓練に使用できます。すでに訓練されたCogVideoX - Funモデルから直接予測を行い、異なる解像度で6秒程度、fps8のビデオ(1~49フレーム)を生成することもサポートしています。また、ユーザーが独自のベースラインモデルとLoraモデルを訓練し、一定のスタイル変換を行うこともサポートしています。

新機能:

- コードの作成!現在、WindowsとLinuxをサポートしています。2bと5bで最大256x256x49から1024x1024x49の任意の解像度のビデオ生成をサポートしています。[ 2024.09.18 ]

機能概要:

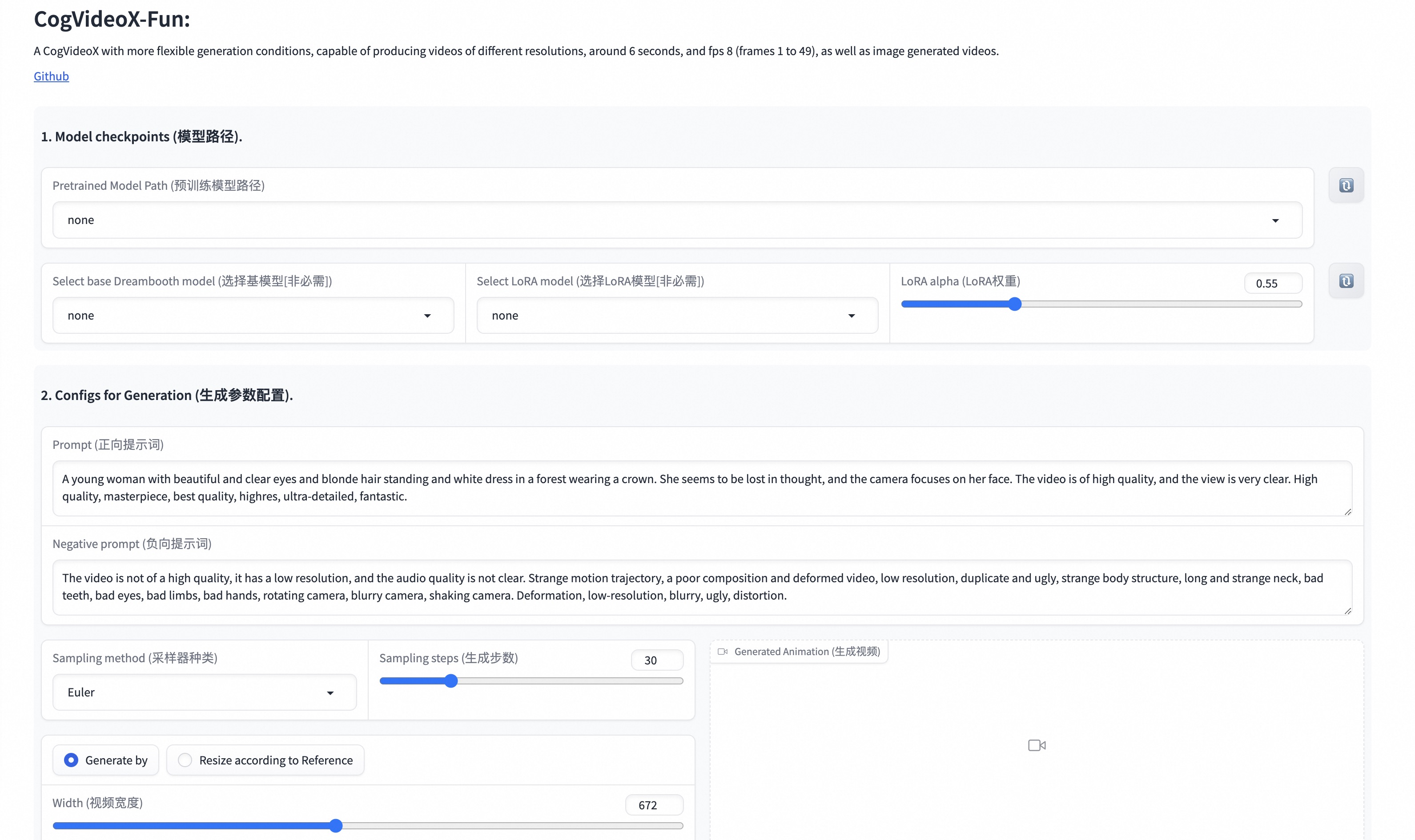

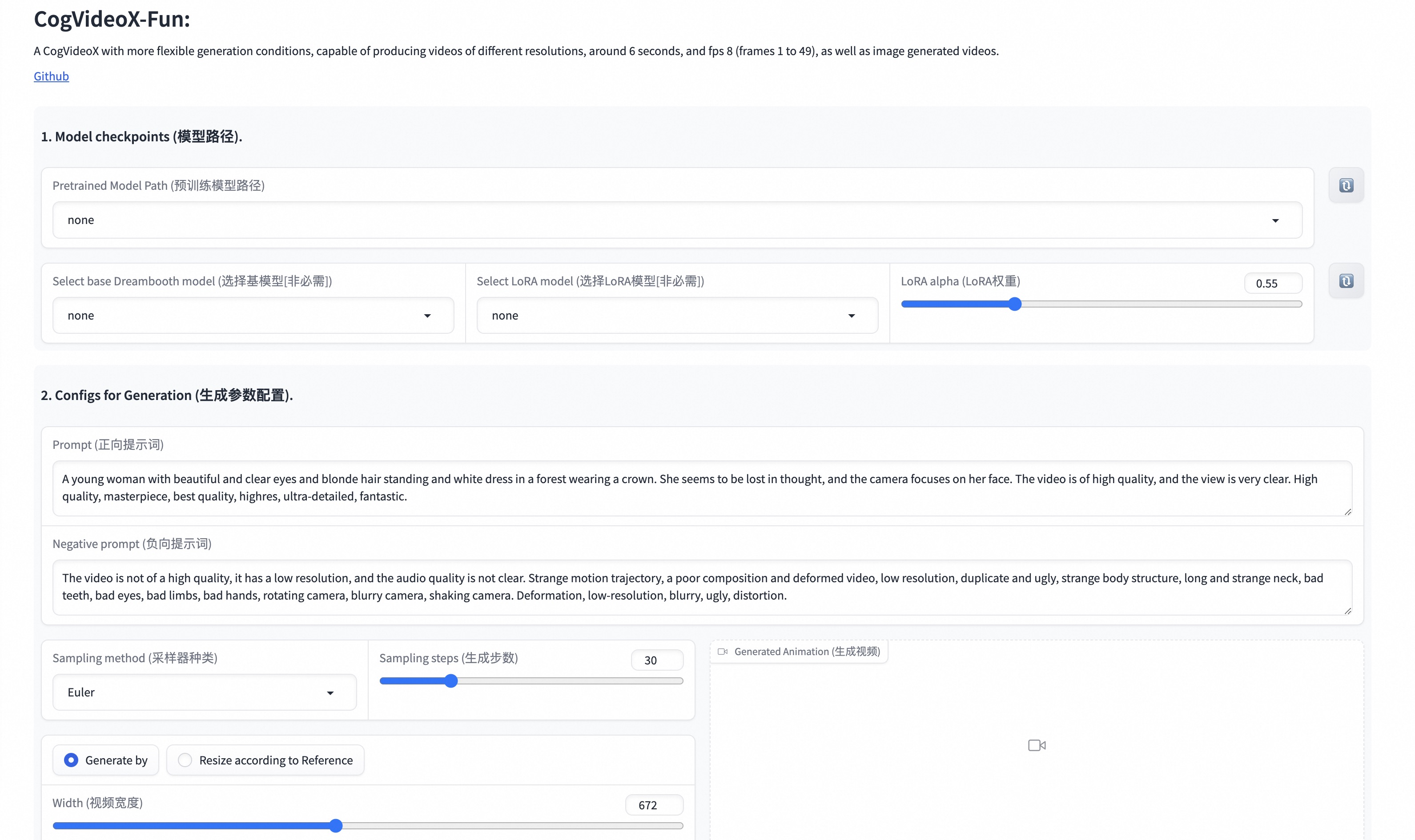

UIインターフェイスは以下の通りです。

📦 インストール

上記の「クイックスタート」セクションを参照してください。

💻 使用例

1. 生成

a. ビデオ生成

i、Pythonファイルの実行

- 手順1:対応する重みをダウンロードし、modelsフォルダに配置します。

- 手順2:predict_t2v.pyファイルでprompt、neg_prompt、guidance_scale、seedを変更します。

- 手順3:predict_t2v.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox - fun - videos - t2vフォルダに保存されます。

- 手順4:独自に訓練した他のバックボーンとLoraを組み合わせたい場合は、predict_t2v.py内のpredict_t2v.pyとlora_pathを適宜変更します。

ii、UIインターフェイスを通じて

- 手順1:対応する重みをダウンロードし、modelsフォルダに配置します。

- 手順2:app.pyファイルを実行し、gradioページにアクセスします。

- 手順3:ページで生成モデルを選択し、prompt、neg_prompt、guidance_scale、seedなどを入力し、生成をクリックして生成結果を待ちます。結果はsampleフォルダに保存されます。

iii、ComfyUIを通じて

詳細はComfyUI READMEを参照してください。

2. モデル訓練

完全なCogVideoX - Fun訓練チェーンには、データ前処理とVideo DiT訓練が含まれるべきです。

a. データ前処理

画像データを使用してloraモデルを訓練する簡単なデモを提供しています。詳細はwikiを参照してください。

完全な長いビデオの切り分け、クリーニング、記述のデータ前処理チェーンは、video caption部分のREADMEを参照して行うことができます。

文生図ビデオの生成モデルを訓練する場合は、データセットを次の形式で配置する必要があります。

📦 project/

├── 📂 datasets/

│ ├── 📂 internal_datasets/

│ ├── 📂 train/

│ │ ├── 📄 00000001.mp4

│ │ ├── 📄 00000002.jpg

│ │ └── 📄 .....

│ └── 📄 json_of_internal_datasets.json

json_of_internal_datasets.jsonは標準的なJSONファイルです。JSON内のfile_pathは相対パスに設定できます。

[

{

"file_path": "train/00000001.mp4",

"text": "A group of young men in suits and sunglasses are walking down a city street.",

"type": "video"

},

{

"file_path": "train/00000002.jpg",

"text": "A group of young men in suits and sunglasses are walking down a city street.",

"type": "image"

},

.....

]

絶対パスに設定することもできます。

[

{

"file_path": "/mnt/data/videos/00000001.mp4",

"text": "A group of young men in suits and sunglasses are walking down a city street.",

"type": "video"

},

{

"file_path": "/mnt/data/train/00000001.jpg",

"text": "A group of young men in suits and sunglasses are walking down a city street.",

"type": "image"

},

.....

]

b. Video DiTの訓練

データ前処理時にデータの形式が相対パスの場合は、scripts/train.shに以下の設定を行います。

export DATASET_NAME="datasets/internal_datasets/"

export DATASET_META_NAME="datasets/internal_datasets/json_of_internal_datasets.json"

...

train_data_format="normal"

データの形式が絶対パスの場合は、scripts/train.shに以下の設定を行います。

export DATASET_NAME=""

export DATASET_META_NAME="/mnt/data/json_of_internal_datasets.json"

最後に、以下のコマンドを実行します。

sh scripts/train.sh

いくつかのパラメータの設定詳細については、Readme TrainとReadme Loraを参照してください。

📚 ドキュメント

ビデオ作品

展示されている結果はすべて画像からビデオを生成したものです。

CogVideoX-Fun-5B

解像度1024

解像度768

解像度512

CogVideoX-Fun-2B

解像度768

モデルの場所

| 名前 |

ストレージ容量 |

Hugging Face |

Model Scope |

説明 |

| CogVideoX-Fun-2b-InP.tar.gz |

解凍前 9.7 GB / 解凍後 13.0 GB |

🤗Link |

😄Link |

公式の画像からビデオへの重み。多解像度(512、768、1024、1280)のビデオ予測をサポートし、49フレーム、毎秒8フレームで訓練されています。 |

| CogVideoX-Fun-5b-InP.tar.gz |

解凍前 16.0GB / 解凍後 20.0 GB |

🤗Link |

😄Link |

公式の画像からビデオへの重み。多解像度(512、768、1024、1280)のビデオ予測をサポートし、49フレーム、毎秒8フレームで訓練されています。 |

将来の計画

参考文献

- CogVideo: https://github.com/THUDM/CogVideo/

- EasyAnimate: https://github.com/aigc-apps/EasyAnimate

📄 ライセンス

このプロジェクトは Apache License (Version 2.0) を採用しています。

CogVideoX - 2B モデル(対応するTransformersモジュール、VAEモジュールを含む)は Apache 2.0 ライセンス の下で公開されています。

CogVideoX - 5B モデル(Transformer モジュール)はCogVideoXライセンスの下で公開されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語