🚀 ~ GenZ ~

GenZは、オープンソースコミュニティにおける大規模言語モデル(LLM)へのアクセスを民主化することを目指したプロジェクトです。我々は、オープンソースの協力によって、AI技術の進歩を加速させることができると信じています。

🚀 クイックスタート

Hugging FaceでGenZモデルを使用するには、以下の手順に従ってください。

1️⃣ 必要なモジュールをインポートする

まず、transformersライブラリとtorchから必要なモジュールをインポートします。

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("budecosystem/genz-70b", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("budecosystem/genz-70b", torch_dtype=torch.bfloat16, rope_scaling={"type": "dynamic", "factor": 2})

prompt = "### User:\nWrite a python flask code for login management\n\n### Assistant:\n"

inputs = tokenizer(prompt, return_tensors="pt")

sample = model.generate(**inputs, max_length=128)

print(tokenizer.decode(sample[0]))

もっと直感的にモデルと対話したい場合は、GitHubページに移動してリポジトリをクローンし、generate.pyスクリプトを実行して試してみてください。

✨ 主な機能

- 高度なテキスト生成:GenZは、MetaのオープンソースLlama V2 70Bパラメータモデルをベースに微調整された大規模言語モデルです。高度なテキスト生成能力を持ち、ユーザーのプロンプトに対して高品質な応答を提供します。

- 多様なパラメータと量子化:我々は、異なるパラメータ数(7B、13B、70B)と量子化(32ビットと4ビット)の一連のモデルをオープンソースコミュニティに公開する予定です。小さな量子化バージョンのモデルは、個人用コンピュータでも使用できるようになっています。

- 継続的な改善:我々は、GenZを継続的に改善することにコミットしています。定期的に様々なデータセットでモデルを微調整し、性能を向上させます。

📦 インストール

Hugging FaceでGenZモデルを使用するには、上記のクイックスタートセクションの手順に従ってください。

💻 使用例

基本的な使用法

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("budecosystem/genz-70b", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("budecosystem/genz-70b", torch_dtype=torch.bfloat16, rope_scaling={"type": "dynamic", "factor": 2})

prompt = "### User:\nWrite a python flask code for login management\n\n### Assistant:\n"

inputs = tokenizer(prompt, return_tensors="pt")

sample = model.generate(**inputs, max_length=128)

print(tokenizer.decode(sample[0]))

📚 ドキュメント

マイルストーンリリース ️🏁

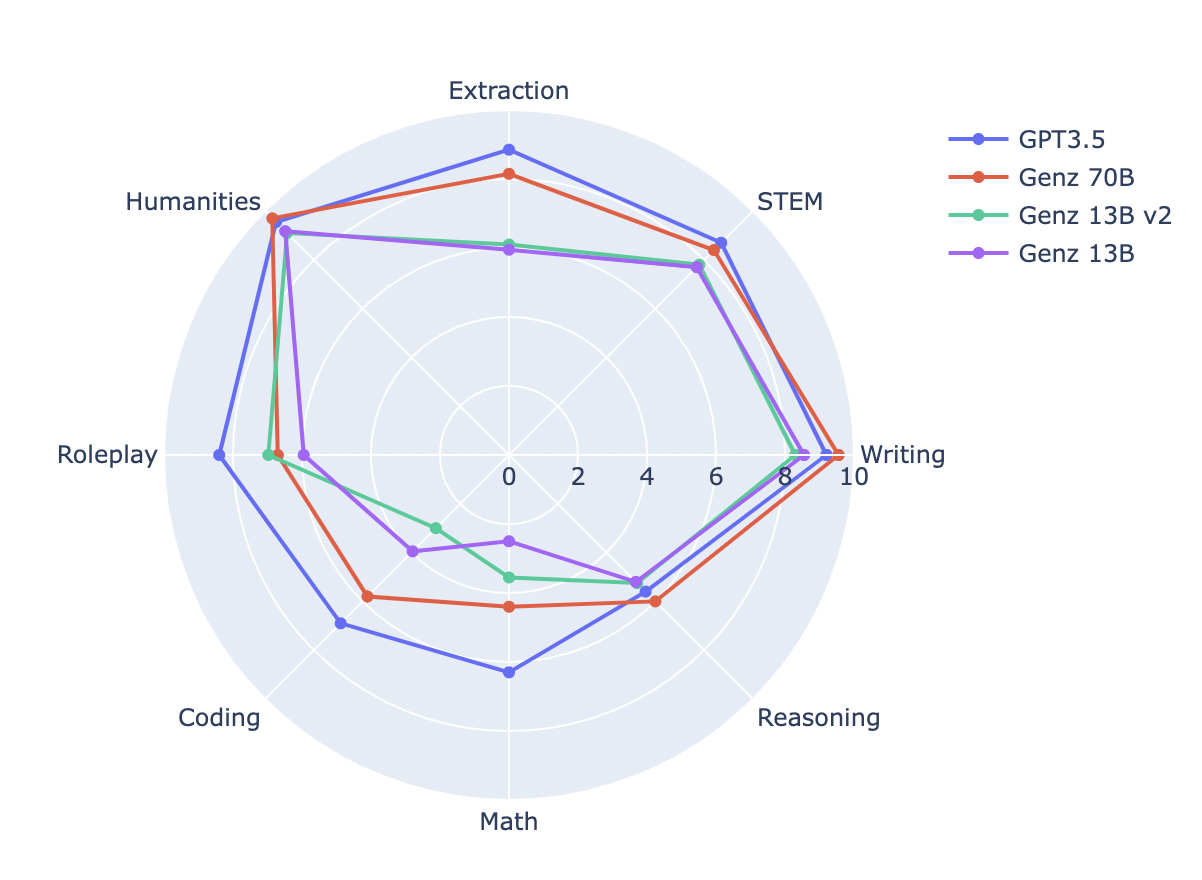

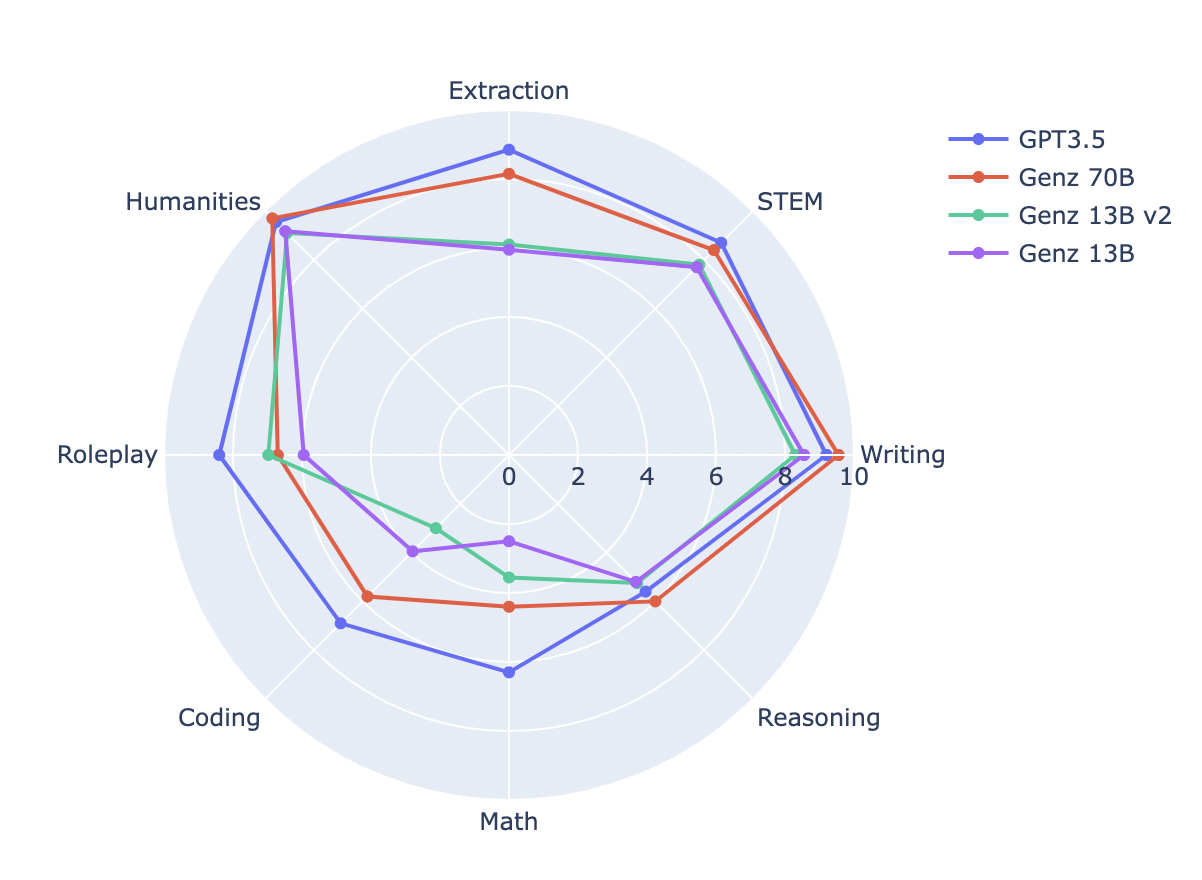

評価 🎯

ベンチマーク比較

GenZモデルを比較し、微調整によって達成された改善を確認しました。

| モデル名 |

MT Bench |

MMLU |

Human Eval |

BBH |

| Genz 13B |

6.12 |

53.62 |

17.68 |

37.76 |

| Genz 13B v2 |

6.79 |

53.68 |

21.95 |

38.1 |

| Genz 70B |

7.33 |

70.32 |

37.8 |

54.69 |

MT Benchスコア

MT Benchスコアは、モデルの性能を包括的に評価するための重要な指標です。

GenZ 70Bのモデルカード 📄

モデルの詳細

- 開発者:Bud Ecosystem

- ベースの事前学習モデルタイプ:Llama V2 70B

- モデルアーキテクチャ:GenZ 70Bは、Llama V2 70Bをベースに微調整された自己回帰型言語モデルで、最適化されたトランスフォーマーアーキテクチャを採用しています。微調整には、教師付き微調整(SFT)を使用しています。

- ライセンス:このモデルは、カスタム商用ライセンスの下で商用利用可能です。詳細については、Meta AI Model and Library Downloads をご覧ください。

意図された使用法 💼

直接的な使用

GenZ 70Bは、大規模言語モデルの研究に強力なツールとして設計されています。また、特定のユースケースに合わせてさらに特化および微調整するための優れた基盤となります。

- テキスト要約

- テキスト生成

- チャットボット作成

- など

範囲外の使用 🚩

GenZ 70Bは多用途ですが、以下のような使用は範囲外です。

- リスクの十分な評価と軽減策なしでの本番環境での使用

- 無責任または有害と見なされる可能性のある使用ケース

- 適用される法律や規制、貿易コンプライアンス法に違反する使用

- Llama 2の許容使用ポリシーとライセンス契約で禁止されている他の使用方法

推奨事項 🧠

GenZ 70Bのユーザーは、関心のある特定のタスクセットに合わせてモデルを微調整することをお勧めします。本番環境での使用には、適切な予防策とガードレールを講じる必要があります。

トレーニングの詳細 📚

微調整トレーニングデータ

微調整には、OpenAssistantの命令微調整データセットやThought SourceのChain Of Thought(CoT)アプローチなど、さまざまなデータセットを使用しました。これらの多様なデータソースは、モデルの様々なタスクでの能力を向上させるのに役立ちました。

ハイパーパラメータ

微調整に使用したハイパーパラメータは以下の通りです。

| ハイパーパラメータ |

値 |

| ウォームアップ比率 |

0.04 |

| 学習率スケジューラタイプ |

コサイン |

| 学習率 |

2e-5 |

| トレーニングエポック数 |

3 |

| デバイスあたりのトレーニングバッチサイズ |

4 |

| 勾配累積ステップ |

4 |

| 精度 |

FP16 |

| オプティマイザ |

AdamW |

🔧 技術詳細

GenZ 70Bは、Llama V2 70Bをベースに微調整された自己回帰型言語モデルです。微調整には、教師付き微調整(SFT)を使用し、多様なデータセットを用いてモデルの能力を向上させました。

📄 ライセンス

このモデルは、カスタム商用ライセンスの下で商用利用可能です。詳細については、Meta AI Model and Library Downloads をご覧ください。

👀 これからの展望

我々は、GenZのこれからの旅程に興奮しています。モデルを継続的に改善し、オープンソースコミュニティが何を構築するかを楽しみにしています。我々は協力の力を信じており、一緒に何が達成できるかを楽しみにしています。

コードについては、GitHubを確認してください -> GenZ

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語