🚀 タイフーン-7B: タイ語の大規模言語モデル(事前学習済み)

タイフーン-7Bは、70億のパラメータを持つ事前学習済みのタイ語🇹🇭の大規模言語モデルで、Mistral-7Bをベースにしています。

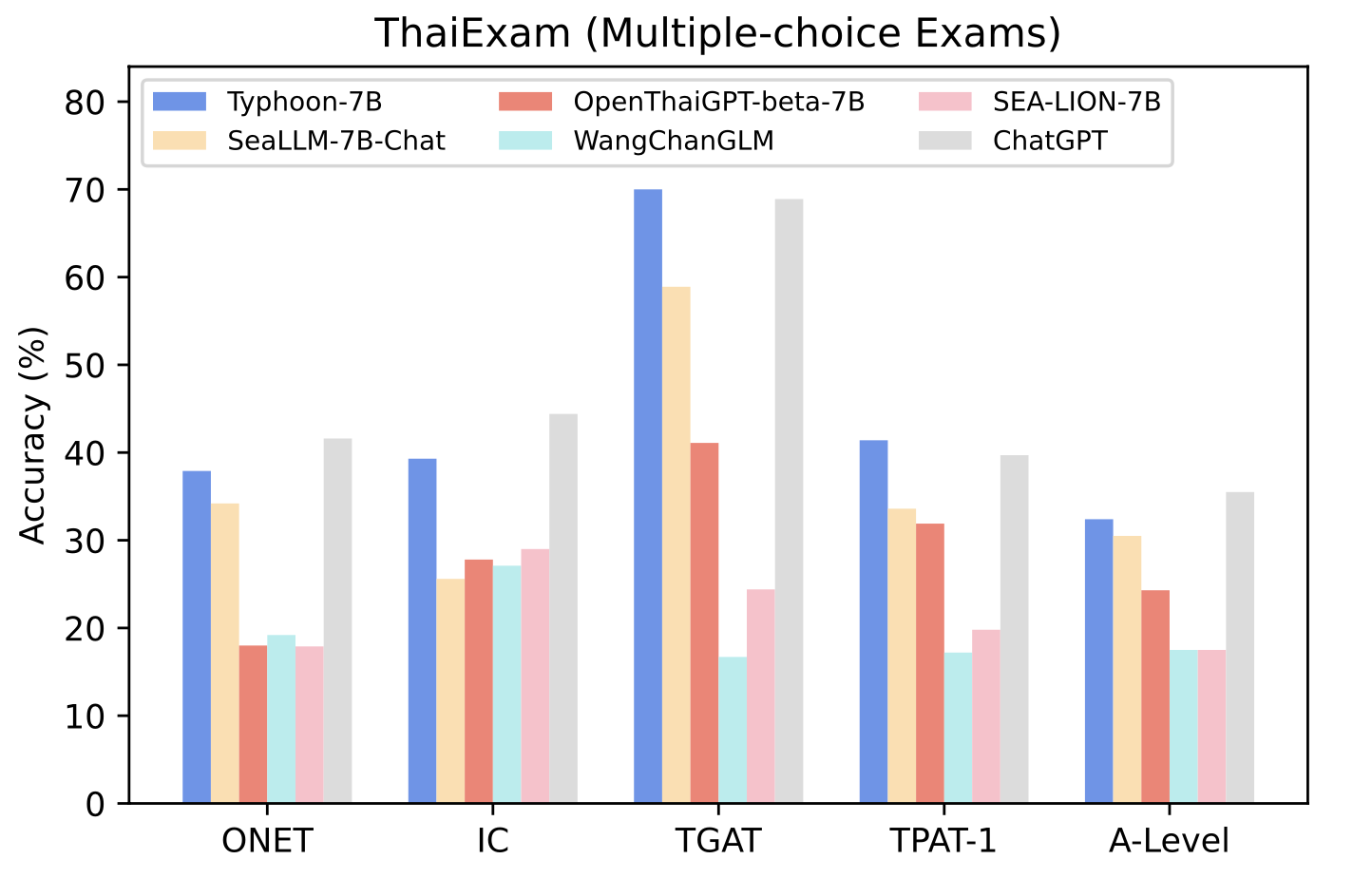

タイフーン-7Bは、タイ語の試験ベンチマークで評価されたところ、執筆時点ですべてのオープンソースのタイ語モデルを上回っています。また、命令調整されたバリアントは、命令に従うタスクで最高の結果を達成します。さらに、タイ語での性能はGPT - 3.5と同等であり、タイ語テキストのトークン化においては2.62倍効率的です。

これは命令調整されたモデルではありません - ワンショット/フューショット学習または命令微調整を行わないと、人間の命令に従うことができない場合があります。また、このモデルにはモデレーション機構がないため、有害または不適切な応答を生成する可能性があります。

命令調整済みモデル(チャットモデル)は近日公開予定です。ベータ版の登録は、https://opentyphoon.ai/ で開いています。また、将来のモデルリリースについては、https://twitter.com/opentyphoon をフォローしてください。

このモデルの詳細については、論文をご覧ください。

🚀 クイックスタート

このモデルを使用するには、transformers 4.34.0以上が必要です。

✨ 主な機能

- タイ語と英語に対応した事前学習済みモデルで、タイ語のベンチマークで高い性能を発揮します。

- 命令調整済みバリアントは命令に従うタスクで優れた結果を出します。

- タイ語のトークン化においてGPT - 3.5よりも効率的です。

📚 ドキュメント

モデルの説明

| 属性 |

详情 |

| モデルタイプ |

7B事前学習済みのデコーダー専用モデル |

| 要件 |

transformers 4.34.0以上 |

| 主要言語 |

タイ語🇹🇭と英語🇬🇧 |

| ライセンス |

Apache - 2.0(商用可) |

タイ語ベンチマークでの性能

| モデル |

ONET |

IC |

TGAT |

TPAT - 1 |

A - Level |

| タイフーン-7B |

0.379 |

0.393 |

0.700 |

0.414 |

0.324 |

| SeaLLM - 7B |

0.342 |

0.256 |

0.589 |

0.336 |

0.305 |

| OpenThaiGPT - beta - 7B |

0.180 |

0.278 |

0.411 |

0.319 |

0.243 |

| WangChanGLM |

0.192 |

0.271 |

0.167 |

0.172 |

0.175 |

| SEA - LION - 7B |

0.179 |

0.290 |

0.244 |

0.198 |

0.175 |

| 人間の平均 |

0.318 |

- |

0.472 |

0.406 |

- |

想定される用途と制限

このモデルは事前学習済みのベースモデルです。したがって、ワンショット/フューショット学習または命令微調整を行わないと、人間の命令に従うことができない場合があります。また、このモデルにはモデレーション機構がないため、有害または不適切な応答を生成する可能性があります。

🔗 フォロー

https://twitter.com/opentyphoon

💬 サポート / 質問

https://discord.gg/us5gAYmrxw

SCB 10X AIチーム

- Kunat Pipatanakul, Phatrasek Jirabovonvisut, Potsawee Manakul, Sittipong Sripaisarnmongkol, Ruangsak Patomwong, Pathomporn Chokchainant, Kasima Tharnpipitchai

- もしあなたの作業にタイフーン-7Bが役立った場合は、以下のように引用してください。

@article{pipatanakul2023typhoon,

title={Typhoon: Thai Large Language Models},

author={Kunat Pipatanakul and Phatrasek Jirabovonvisut and Potsawee Manakul and Sittipong Sripaisarnmongkol and Ruangsak Patomwong and Pathomporn Chokchainant and Kasima Tharnpipitchai},

year={2023},

journal={arXiv preprint arXiv:2312.13951},

url={https://arxiv.org/abs/2312.13951}

}

📞 お問い合わせ

- 一般的な問い合わせと協力に関しては、kasima@scb10x.com、pathomporn@scb10x.comまで

- 技術的な問い合わせは、kunat@scb10x.comまで

📄 ライセンス

このモデルはApache - 2.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語