🚀 ITALIAN-LEGAL-BERT: イタリア法律向け事前学習済みTransformer言語モデル

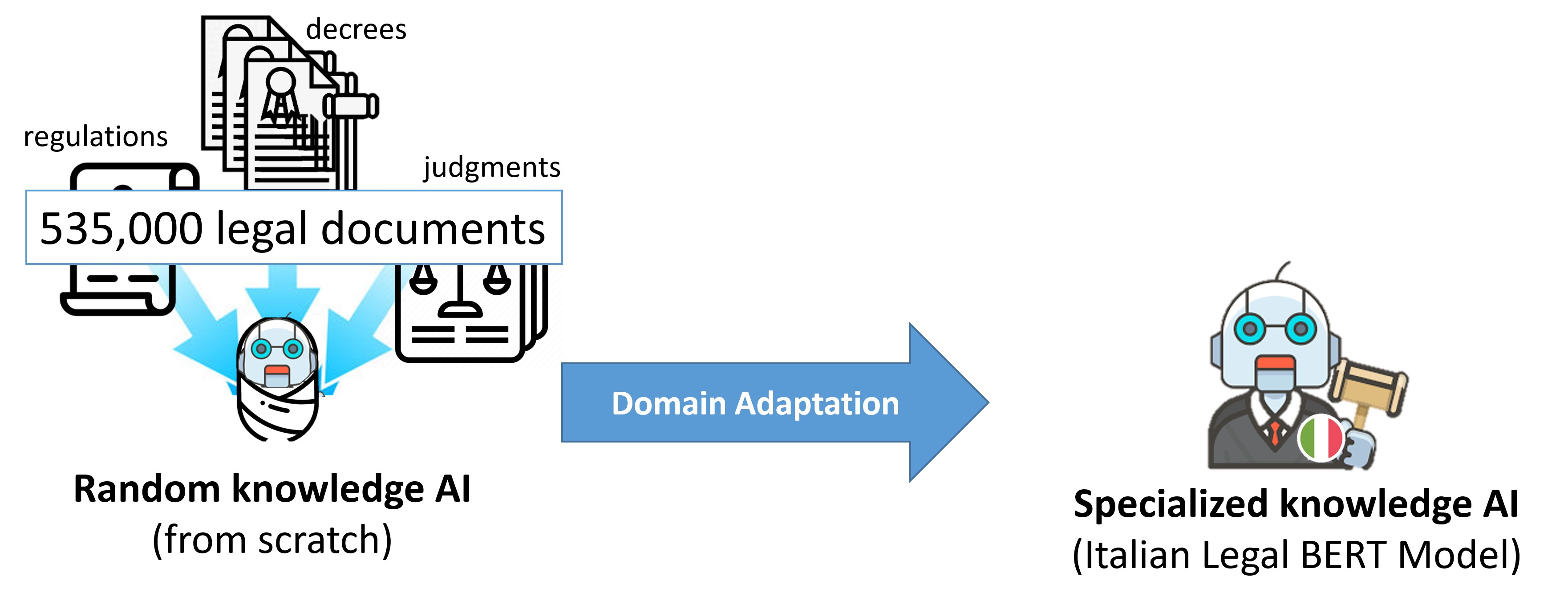

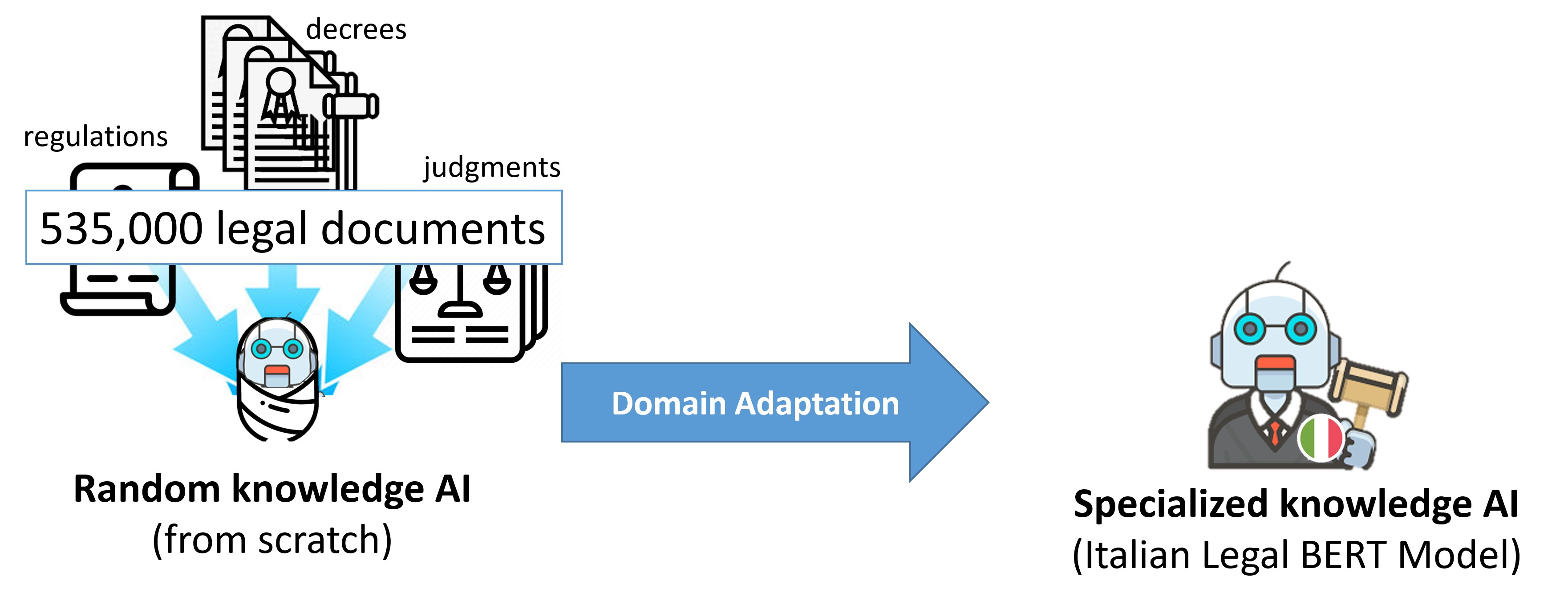

ITALIAN-LEGAL-BERTは、イタリア民法コーパスでイタリア語のBERTモデルを追加で事前学習した、bert-base-italian-xxl-casedに基づくモデルです。様々なドメイン固有のタスクにおいて、「汎用的な」イタリア語のBERTよりも良い結果を達成します。

🚀 クイックスタート

ITALIAN-LEGAL-BERTは、イタリア語の法律文書に特化した事前学習済みモデルです。以下の手順で簡単に使用できます。

✨ 主な機能

- イタリア民法コーパスで追加事前学習されているため、法律関連のタスクで高い性能を発揮します。

- 複数のバリアントが用意されており、長文ドキュメントやゼロからの事前学習など、様々なニーズに対応しています。

📦 インストール

このモデルはHugging FaceのTransformersライブラリを使用してロードできます。以下のコードを実行してください。

from transformers import AutoModel, AutoTokenizer

model_name = "dlicari/Italian-Legal-BERT"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModel.from_pretrained(model_name)

💻 使用例

基本的な使用法

from transformers import AutoModel, AutoTokenizer

model_name = "dlicari/Italian-Legal-BERT"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModel.from_pretrained(model_name)

高度な使用法

Transformersライブラリのfill-maskパイプラインを使用して、推論を行うことができます。

from transformers import pipeline

model_name = "dlicari/Italian-Legal-BERT"

fill_mask = pipeline("fill-mask", model_name)

fill_mask("Il [MASK] ha chiesto revocarsi l'obbligo di pagamento")

また、このCOLAB: ITALIAN-LEGAL-BERT: Minimal Start for Italian Legal Downstream Tasksでは、文の類似度、文の分類、固有表現抽出などのタスクでの使用方法が紹介されています。

- https://colab.research.google.com/drive/1ZOWaWnLaagT_PX6MmXMP2m3MAOVXkyRK?usp=sharing

📚 ドキュメント

モデルのバリアント

-

- FROM SCRATCH:CamemBERTアーキテクチャに基づき、イタリア語の法律文書でゼロから事前学習されたITALIAN-LEGAL-BERTのバリアントです(ITA-LEGAL-BERT-SC)。

- FROM SCRATCH:CamemBERTアーキテクチャに基づき、イタリア語の法律文書でゼロから事前学習されたITALIAN-LEGAL-BERTのバリアントです(ITA-LEGAL-BERT-SC)。

-

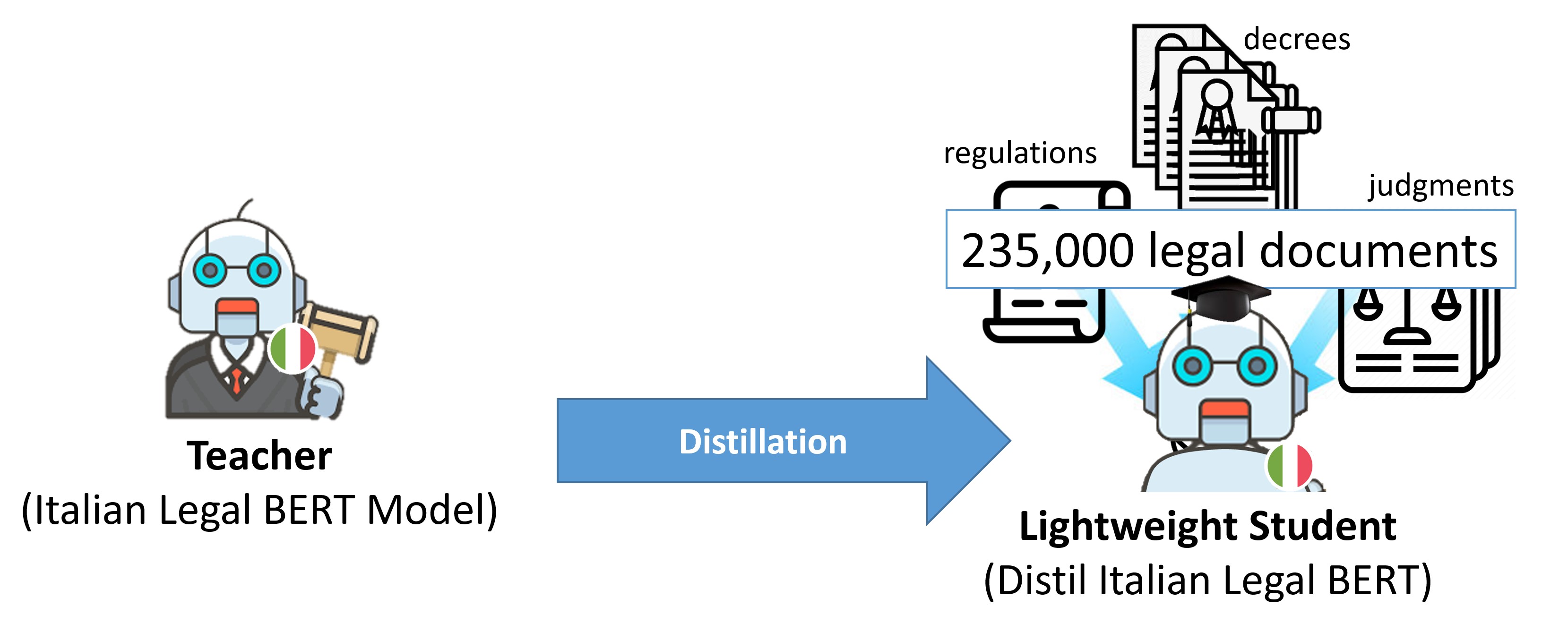

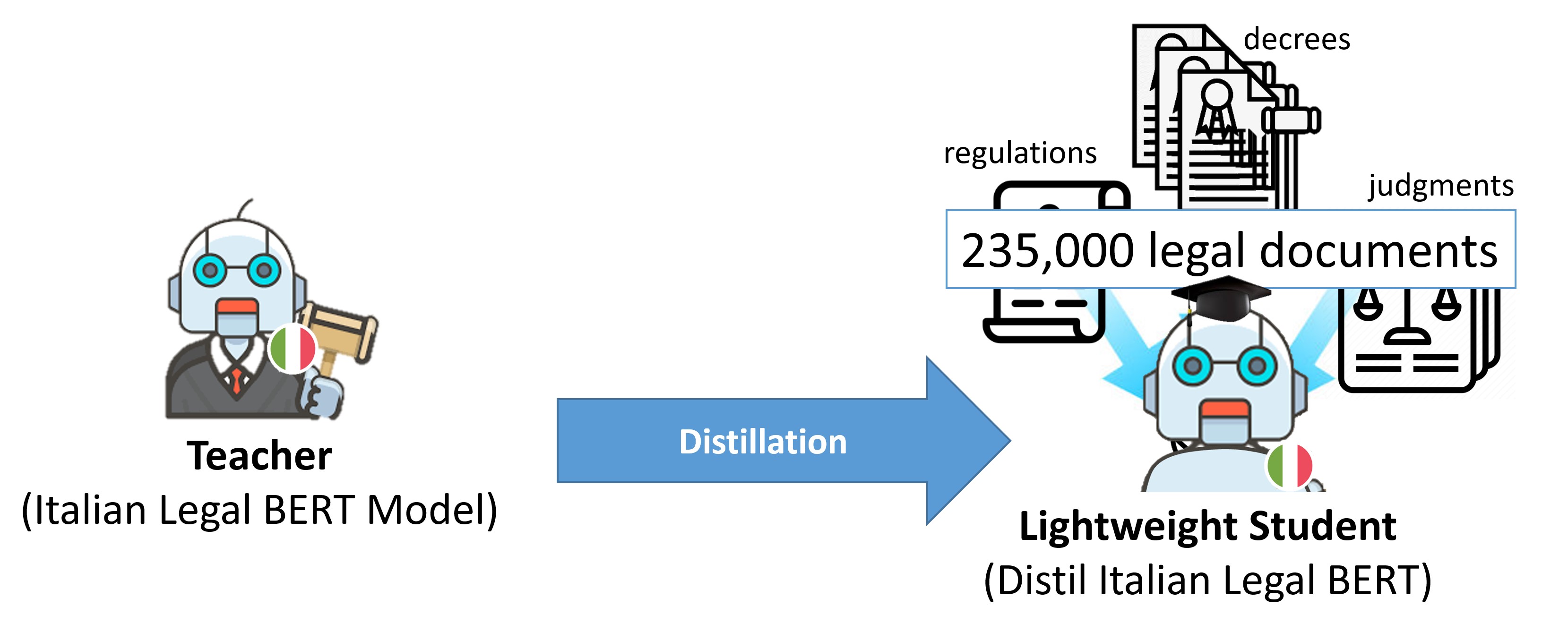

- DISTILLED:ITALIAN-LEGAL-BERTの蒸留バージョンです( DISTIL-ITA-LEGAL-BERT)。

- DISTILLED:ITALIAN-LEGAL-BERTの蒸留バージョンです( DISTIL-ITA-LEGAL-BERT)。

-

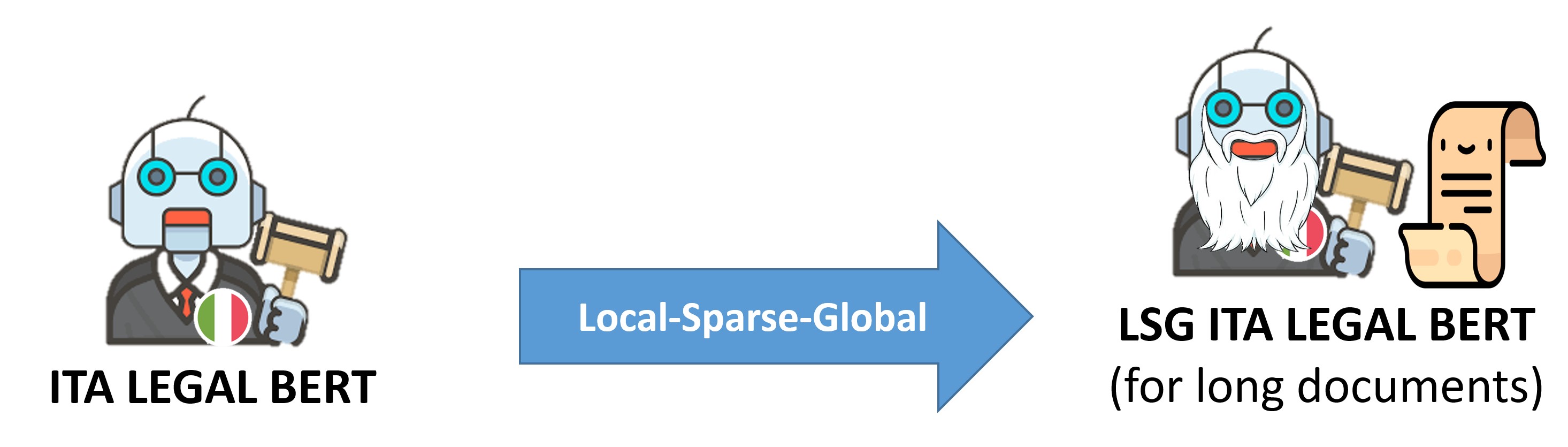

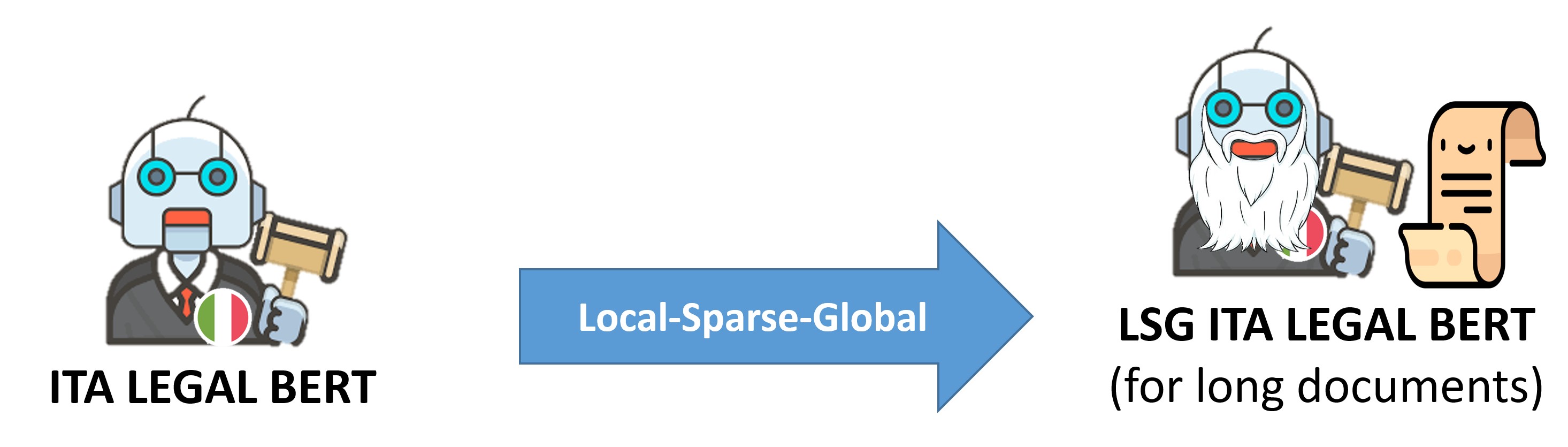

- 長文ドキュメント用

- [LSG ITA LEGAL BERT](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT):ITALIAN-LEGAL-BERTのLocal-Sparse-Globalバージョン(追加事前学習済み)

- [LSG ITA LEGAL BERT-SC](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT-SC):ITALIAN-LEGAL-BERT-SCのLocal-Sparse-Globalバージョン(ゼロから事前学習)

- 長文ドキュメント用

- [LSG ITA LEGAL BERT](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT):ITALIAN-LEGAL-BERTのLocal-Sparse-Globalバージョン(追加事前学習済み)

- [LSG ITA LEGAL BERT-SC](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT-SC):ITALIAN-LEGAL-BERT-SCのLocal-Sparse-Globalバージョン(ゼロから事前学習)

学習手順

ITALIAN-LEGAL-BERTは、ITALIAN XXL BERTで初期化され、国立判例アーカイブからの3.7GBの前処理済みテキストでさらに4エポック事前学習されました。使用したパラメータは以下の通りです。

- アーキテクチャ:BERT

- オプティマイザ:AdamW

- 初期学習率:5e-5(線形学習率減衰、最終値2.525e-9)

- シーケンス長:512

- バッチサイズ:10(GPU容量により制限)

- 学習ステップ数:840万

- デバイス:1*GPU V100 16GB

📄 ライセンス

このモデルはAFL-3.0ライセンスの下で提供されています。

📚 引用

もしこのリソースや論文が役に立った場合は、以下の引用をあなたの論文に含めてください。

@inproceedings{licari_italian-legal-bert_2022,

address = {Bozen-Bolzano, Italy},

series = {{CEUR} {Workshop} {Proceedings}},

title = {{ITALIAN}-{LEGAL}-{BERT}: {A} {Pre}-trained {Transformer} {Language} {Model} for {Italian} {Law}},

volume = {3256},

shorttitle = {{ITALIAN}-{LEGAL}-{BERT}},

url = {https://ceur-ws.org/Vol-3256/#km4law3},

language = {en},

urldate = {2022-11-19},

booktitle = {Companion {Proceedings} of the 23rd {International} {Conference} on {Knowledge} {Engineering} and {Knowledge} {Management}},

publisher = {CEUR},

author = {Licari, Daniele and Comandè, Giovanni},

editor = {Symeonidou, Danai and Yu, Ran and Ceolin, Davide and Poveda-Villalón, María and Audrito, Davide and Caro, Luigi Di and Grasso, Francesca and Nai, Roberto and Sulis, Emilio and Ekaputra, Fajar J. and Kutz, Oliver and Troquard, Nicolas},

month = sep,

year = {2022},

note = {ISSN: 1613-0073},

file = {Full Text PDF:https://ceur-ws.org/Vol-3256/km4law3.pdf},

}

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語 -

-  -

-  - 長文ドキュメント用

- [LSG ITA LEGAL BERT](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT):ITALIAN-LEGAL-BERTのLocal-Sparse-Globalバージョン(追加事前学習済み)

- [LSG ITA LEGAL BERT-SC](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT-SC):ITALIAN-LEGAL-BERT-SCのLocal-Sparse-Globalバージョン(ゼロから事前学習)

- 長文ドキュメント用

- [LSG ITA LEGAL BERT](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT):ITALIAN-LEGAL-BERTのLocal-Sparse-Globalバージョン(追加事前学習済み)

- [LSG ITA LEGAL BERT-SC](https://huggingface.co/dlicari/lsg16k-Italian-Legal-BERT-SC):ITALIAN-LEGAL-BERT-SCのLocal-Sparse-Globalバージョン(ゼロから事前学習)