🚀 [Google的T5 - 闭卷问答模型]

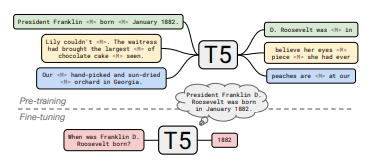

本项目基于Google的T5模型,用于闭卷问答任务。该模型通过在多个大型数据集上进行预训练和微调,能够在不借助外部知识源的情况下回答问题,为自然语言处理领域的知识问答提供了有效的解决方案。

🚀 快速开始

本模型可按如下方式用于闭卷问答:

from transformers import AutoModelForSeq2SeqLM, AutoTokenizer

t5_qa_model = AutoModelForSeq2SeqLM.from_pretrained("google/t5-11b-ssm-nq")

t5_tok = AutoTokenizer.from_pretrained("google/t5-11b-ssm-nq")

input_ids = t5_tok("When was Franklin D. Roosevelt born?", return_tensors="pt").input_ids

gen_output = t5_qa_model.generate(input_ids)[0]

print(t5_tok.decode(gen_output, skip_special_tokens=True))

✨ 主要特性

📦 安装指南

文档中未提及具体安装步骤,故跳过此章节。

💻 使用示例

基础用法

from transformers import AutoModelForSeq2SeqLM, AutoTokenizer

t5_qa_model = AutoModelForSeq2SeqLM.from_pretrained("google/t5-11b-ssm-nq")

t5_tok = AutoTokenizer.from_pretrained("google/t5-11b-ssm-nq")

input_ids = t5_tok("When was Franklin D. Roosevelt born?", return_tensors="pt").input_ids

gen_output = t5_qa_model.generate(input_ids)[0]

print(t5_tok.decode(gen_output, skip_special_tokens=True))

📚 详细文档

模型信息

自然问题测试集结果

| 编号 |

链接 |

精确匹配率 |

| T5-small |

https://huggingface.co/google/t5-small-ssm-nq |

25.5 |

| T5-large |

https://huggingface.co/google/t5-large-ssm-nq |

30.4 |

| T5-xl |

https://huggingface.co/google/t5-xl-ssm-nq |

35.6 |

| T5-xxl |

https://huggingface.co/google/t5-xxl-ssm-nq |

37.9 |

| T5-3b |

https://huggingface.co/google/t5-3b-ssm-nq |

33.2 |

| T5-11b |

https://huggingface.co/google/t5-11b-ssm-nq |

36.6 |

相关链接

摘要

近期研究发现,在非结构化文本上训练的神经语言模型可以使用自然语言查询隐式地存储和检索知识。在这篇简短的论文中,我们通过微调预训练模型在不访问任何外部上下文或知识的情况下回答问题,来衡量这种方法的实际效用。我们表明,这种方法随着模型规模的增大而表现更好,并且在回答问题时与从外部知识源显式检索答案的开放域系统具有竞争力。为了便于复现和未来研究,我们在https://goo.gle/t5-cbqa 上发布了我们的代码和训练好的模型。

🔧 技术细节

文档中未提及具体技术实现细节,故跳过此章节。

📄 许可证

本模型使用的许可证为:apache-2.0。

⚠️ 重要提示

该模型在Natural Questions (NQ)的全部训练分割数据上进行了10000步的微调。

💡 使用建议

文档中未提及使用建议,故跳过此提示。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语