🚀 ColQwen2.5-3b-multilingual-v1.0:基于Qwen2.5-VL-3B-Instruct和ColBERT策略的多语言视觉检索器

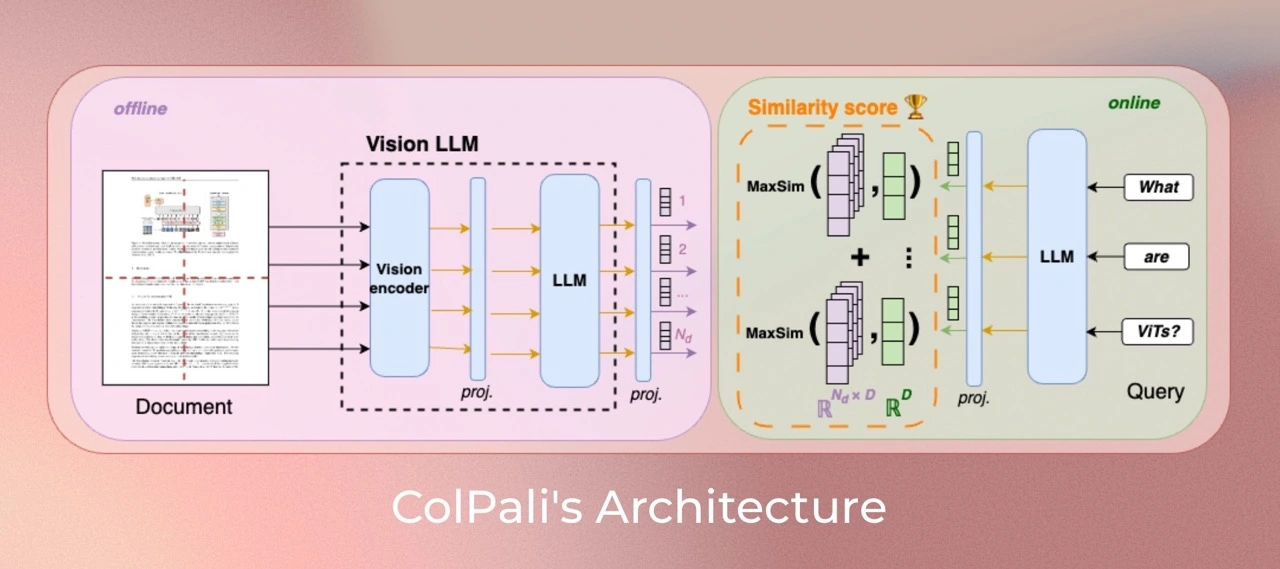

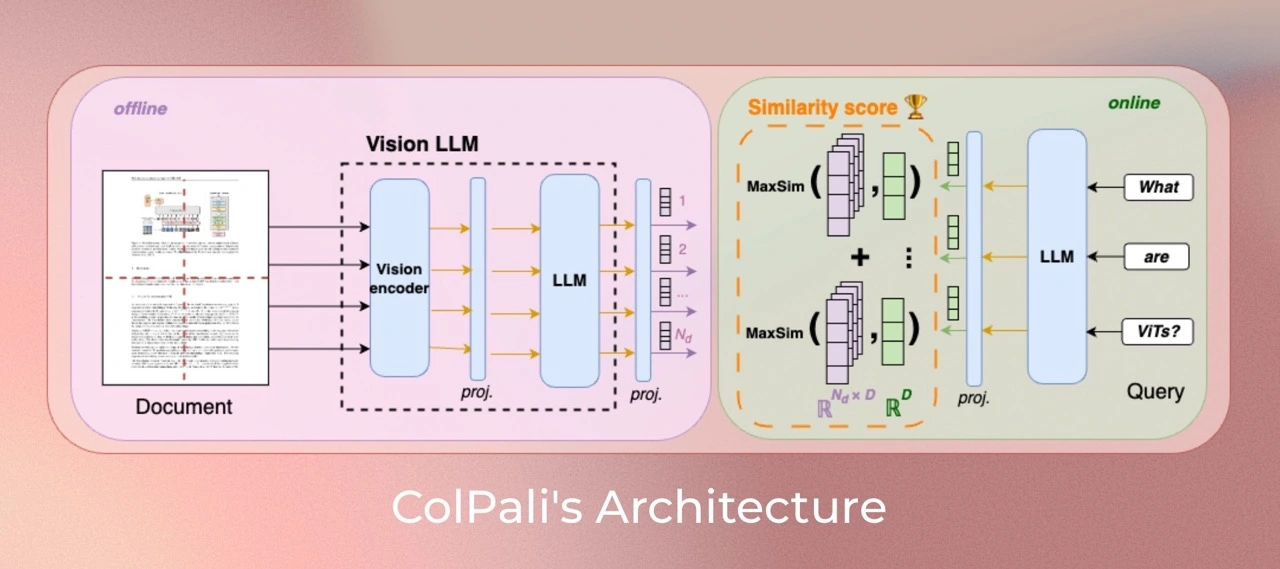

ColQwen是一个基于视觉语言模型(VLMs)的新型模型架构和训练策略的模型,旨在通过视觉特征高效地对文档进行索引。它是Qwen2.5-VL-3B的扩展版本,能够生成ColBERT风格的文本和图像多向量表示。该模型在论文ColPali: Efficient Document Retrieval with Vision Language Models中被提出,并首次在此仓库中发布。

这是在8xH100 80GB上训练的基础版本,每个设备的批量大小为128,训练了8个周期。

✨ 主要特性

- 多语言支持:支持英语、法语、西班牙语、意大利语和德语等多种语言。

- 多模态嵌入:能够处理文本和图像的多模态嵌入。

- 高效检索:基于ColBERT策略,能够高效地进行文本到视觉文档(T→VD)的检索。

📦 安装指南

pip install git+https://github.com/illuin-tech/colpali

pip install transformers==4.49.0

pip install flash-attn --no-build-isolation

💻 使用示例

基础用法

import torch

from PIL import Image

from colpali_engine.models import ColQwen2_5, ColQwen2_5_Processor

model = ColQwen2_5.from_pretrained(

"tsystems/colqwen2.5-3b-multilingual-v1.0",

torch_dtype=torch.bfloat16,

device_map="cuda:0",

).eval()

processor = ColQwen2_5_Processor.from_pretrained("tsystems/colqwen2.5-3b-multilingual-v1.0")

images = [

Image.new("RGB", (32, 32), color="white"),

Image.new("RGB", (16, 16), color="black"),

]

queries = [

"Is attention really all you need?",

"What is the amount of bananas farmed in Salvador?",

]

batch_images = processor.process_images(images).to(model.device)

batch_queries = processor.process_queries(queries).to(model.device)

with torch.no_grad():

image_embeddings = model(**batch_images)

query_embeddings = model(**batch_queries)

scores = processor.score_multi_vector(query_embeddings, image_embeddings)

📚 详细文档

版本特性

此模型接受动态图像分辨率输入,不会像ColPali那样调整图像大小或改变其宽高比。最大分辨率设置为最多创建768个图像块。实验表明,增加图像块数量可以显著提高性能,但会增加内存需求。

此版本使用colpali-engine==0.3.9进行训练。

数据

- 德语和英语:来自

tsystems/vqa_de_en_batch1数据集。

- 多语言数据集:来自

llamaindex/vdr-multilingual-train。

- 合成数据:来自

openbmb/VisRAG-Ret-Train-Synthetic-data数据集。

- 领域内VQA数据集:来自

openbmb/VisRAG-Ret-Train-In-domain-data数据集。

- Colpali数据集:来自

vidore/colpali_train_set。

模型训练

参数

我们使用低秩适配器(LoRA)对语言模型的Transformer层以及最终随机初始化的投影层进行训练,其中alpha=128,r=128。使用paged_adamw_8bit优化器,在8xH100 GPU上进行分布式数据并行训练(通过accelerate),学习率为2e-4,采用线性衰减,热身步骤为1%,每个设备的批量大小为128,使用bfloat16格式。

局限性

- 适用范围:该模型主要关注PDF类型的文档和资源丰富的语言,可能在其他文档类型或资源较少的语言上的泛化能力有限。

- 支持情况:该模型依赖于从ColBERT后期交互机制派生的多向量检索,可能需要进行工程化工作才能适应缺乏原生多向量支持的广泛使用的向量检索框架。

许可证

ColQwen2.5的视觉语言骨干模型(Qwen2.5-VL)遵循apache2.0许可证。附加在模型上的适配器遵循MIT许可证。

引用

如果您在研究中使用了该组织的模型,请按以下方式引用原始论文:

@misc{faysse2024colpaliefficientdocumentretrieval,

title={ColPali: Efficient Document Retrieval with Vision Language Models},

author={Manuel Faysse and Hugues Sibille and Tony Wu and Bilel Omrani and Gautier Viaud and Céline Hudelot and Pierre Colombo},

year={2024},

eprint={2407.01449},

archivePrefix={arXiv},

primaryClass={cs.IR},

url={https://arxiv.org/abs/2407.01449},

}

开发团队

T-Systems International

信息表格

| 属性 |

详情 |

| 模型类型 |

基于Qwen2.5-VL-3B-Instruct的多语言视觉检索器 |

| 训练数据 |

openbmb/VisRAG-Ret-Train-Synthetic-data、openbmb/VisRAG-Ret-Train-In-domain-data、tsystems/vqa_de_en_batch1、vidore/colpali_train_set、llamaindex/vdr-multilingual-train、Metric-AI/tabfquad_train_set |

| 支持语言 |

英语、法语、西班牙语、意大利语、德语 |

| 基础模型 |

Qwen/Qwen2.5-VL-3B-Instruct |

| 标签 |

多模态嵌入、多语言嵌入、文本到视觉文档(T→VD)检索 |

| 库名称 |

transformers |

| 任务类型 |

视觉文档检索 |

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语