模型概述

模型特點

模型能力

使用案例

🚀 Controlnet - v1.1 - MLSD版本

Controlnet v1.1是一個強大的圖像生成模型,它是Controlnet v1.0的繼任者。該模型能夠與Stable Diffusion結合使用,通過額外的條件輸入,如邊緣圖、分割圖等,實現對圖像生成過程的精細控制,為圖像創作帶來更多可能性。

🚀 快速開始

安裝依賴

若要使用此檢查點處理圖像以創建輔助條件,需要安裝以下外部依賴:

- 安裝https://github.com/patrickvonplaten/controlnet_aux

$ pip install controlnet_aux==0.3.0

- 安裝

diffusers及相關包:

$ pip install diffusers transformers accelerate

運行示例代碼

import torch

import os

from huggingface_hub import HfApi

from pathlib import Path

from diffusers.utils import load_image

from PIL import Image

import numpy as np

from controlnet_aux import MLSDdetector

from diffusers import (

ControlNetModel,

StableDiffusionControlNetPipeline,

UniPCMultistepScheduler,

)

checkpoint = "lllyasviel/control_v11p_sd15_mlsd"

image = load_image(

"https://huggingface.co/lllyasviel/control_v11p_sd15_mlsd/resolve/main/images/input.png"

)

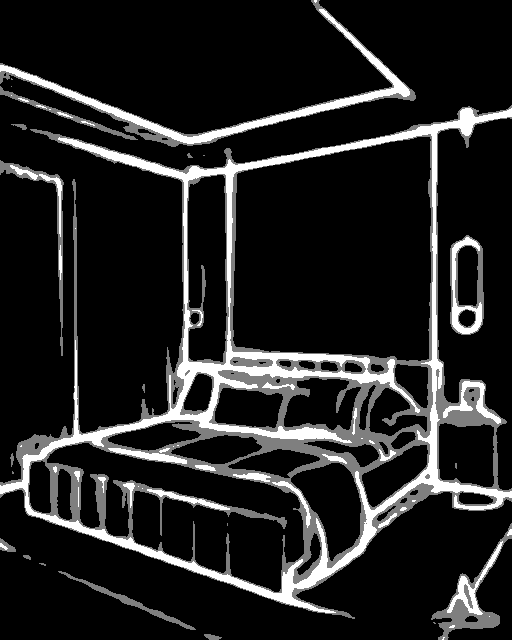

prompt = "royal chamber with fancy bed"

processor = MLSDdetector.from_pretrained('lllyasviel/ControlNet')

control_image = processor(image)

control_image.save("./images/control.png")

controlnet = ControlNetModel.from_pretrained(checkpoint, torch_dtype=torch.float16)

pipe = StableDiffusionControlNetPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5", controlnet=controlnet, torch_dtype=torch.float16

)

pipe.scheduler = UniPCMultistepScheduler.from_config(pipe.scheduler.config)

pipe.enable_model_cpu_offload()

generator = torch.manual_seed(0)

image = pipe(prompt, num_inference_steps=30, generator=generator, image=control_image).images[0]

image.save('images/image_out.png')

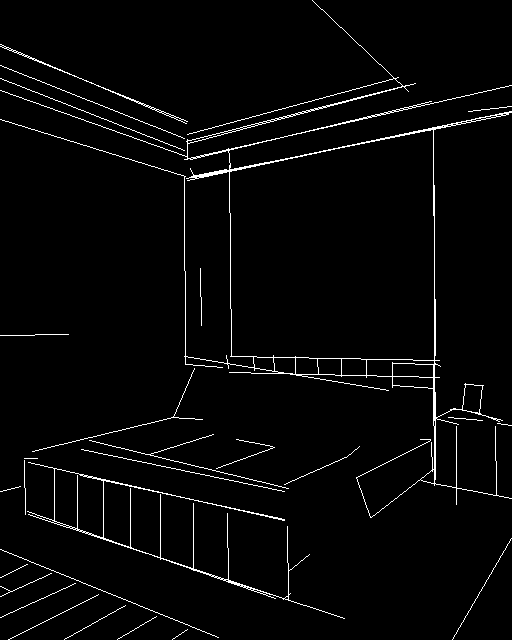

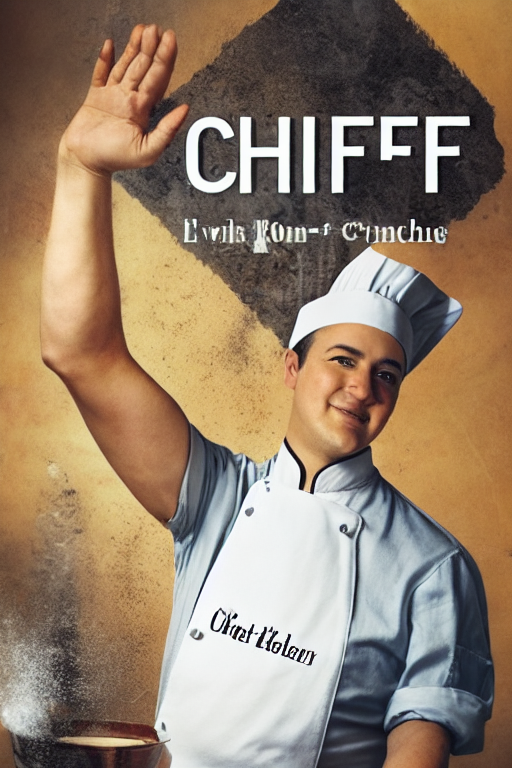

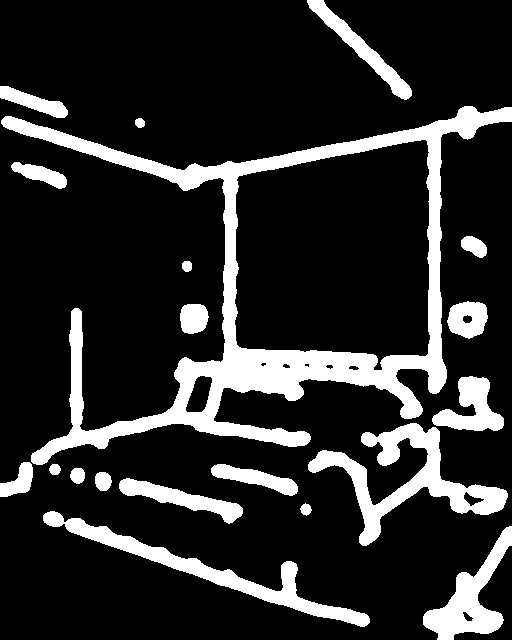

示例圖片

✨ 主要特性

- 條件控制:ControlNet可以控制預訓練的大型擴散模型,支持額外的輸入條件,如邊緣圖、分割圖、關鍵點等。

- 高效訓練:訓練ControlNet的速度與微調擴散模型相當,並且可以在個人設備上進行訓練。

- 數據適應性強:即使訓練數據集較小(< 50k),學習過程也很穩健;若有強大的計算集群,模型也能擴展到大量(數百萬到數十億)數據。

📦 安裝指南

安裝外部依賴

$ pip install controlnet_aux==0.3.0

安裝diffusers及相關包

$ pip install diffusers transformers accelerate

💻 使用示例

基礎用法

推薦將此檢查點與Stable Diffusion v1-5結合使用,因為該檢查點是在其上進行訓練的。實驗表明,該檢查點也可與其他擴散模型(如經過微調的Stable Diffusion)一起使用。

import torch

import os

from huggingface_hub import HfApi

from pathlib import Path

from diffusers.utils import load_image

from PIL import Image

import numpy as np

from controlnet_aux import MLSDdetector

from diffusers import (

ControlNetModel,

StableDiffusionControlNetPipeline,

UniPCMultistepScheduler,

)

checkpoint = "lllyasviel/control_v11p_sd15_mlsd"

image = load_image(

"https://huggingface.co/lllyasviel/control_v11p_sd15_mlsd/resolve/main/images/input.png"

)

prompt = "royal chamber with fancy bed"

processor = MLSDdetector.from_pretrained('lllyasviel/ControlNet')

control_image = processor(image)

control_image.save("./images/control.png")

controlnet = ControlNetModel.from_pretrained(checkpoint, torch_dtype=torch.float16)

pipe = StableDiffusionControlNetPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5", controlnet=controlnet, torch_dtype=torch.float16

)

pipe.scheduler = UniPCMultistepScheduler.from_config(pipe.scheduler.config)

pipe.enable_model_cpu_offload()

generator = torch.manual_seed(0)

image = pipe(prompt, num_inference_steps=30, generator=generator, image=control_image).images[0]

image.save('images/image_out.png')

📚 詳細文檔

模型詳情

| 屬性 | 詳情 |

|---|---|

| 開發者 | Lvmin Zhang, Maneesh Agrawala |

| 模型類型 | 基於擴散的文本到圖像生成模型 |

| 語言 | 英文 |

| 許可證 | CreativeML OpenRAIL M許可證是一種Open RAIL M許可證,改編自BigScience和RAIL Initiative在負責任的AI許可領域的共同工作。另見關於BLOOM Open RAIL許可證的文章,本許可證基於該文章。 |

| 更多信息資源 | GitHub倉庫,論文 |

| 引用格式 | @misc{zhang2023adding, title={Adding Conditional Control to Text-to-Image Diffusion Models}, author={Lvmin Zhang and Maneesh Agrawala}, year={2023}, eprint={2302.05543}, archivePrefix={arXiv}, primaryClass={cs.CV} } |

模型介紹

Controlnet由Lvmin Zhang和Maneesh Agrawala在論文Adding Conditional Control to Text-to-Image Diffusion Models中提出。論文摘要如下:

我們提出了一種神經網絡結構ControlNet,用於控制預訓練的大型擴散模型,以支持額外的輸入條件。ControlNet以端到端的方式學習特定任務的條件,即使訓練數據集較小(< 50k),學習過程也很穩健。此外,訓練ControlNet的速度與微調擴散模型相當,並且可以在個人設備上進行訓練。或者,如果有強大的計算集群,模型可以擴展到大量(數百萬到數十億)數據。我們報告稱,像Stable Diffusion這樣的大型擴散模型可以通過ControlNet進行增強,以支持邊緣圖、分割圖、關鍵點等條件輸入。這可能會豐富控制大型擴散模型的方法,並進一步促進相關應用的發展。

其他發佈的檢查點v1-1

作者發佈了14種不同的檢查點,每種都在不同類型的條件下與Stable Diffusion v1-5一起訓練:

| 模型名稱 | 控制圖像概述 | 條件圖像 | 控制圖像示例 | 生成圖像示例 |

|---|---|---|---|---|

| lllyasviel/control_v11p_sd15_canny |

使用Canny邊緣檢測進行訓練 | 黑色背景上帶有白色邊緣的單色圖像。 |  |

|

| lllyasviel/control_v11e_sd15_ip2p |

使用像素到像素指令進行訓練 | 無條件。 |  |

|

| lllyasviel/control_v11p_sd15_inpaint |

使用圖像修復進行訓練 | 無條件。 |  |

|

| lllyasviel/control_v11p_sd15_mlsd |

使用多級線段檢測進行訓練 | 帶有註釋線段的圖像。 |  |

|

| lllyasviel/control_v11f1p_sd15_depth |

使用深度估計進行訓練 | 帶有深度信息的圖像,通常表示為灰度圖像。 |  |

|

| lllyasviel/control_v11p_sd15_normalbae |

使用表面法線估計進行訓練 | 帶有表面法線信息的圖像,通常表示為彩色編碼圖像。 |  |

|

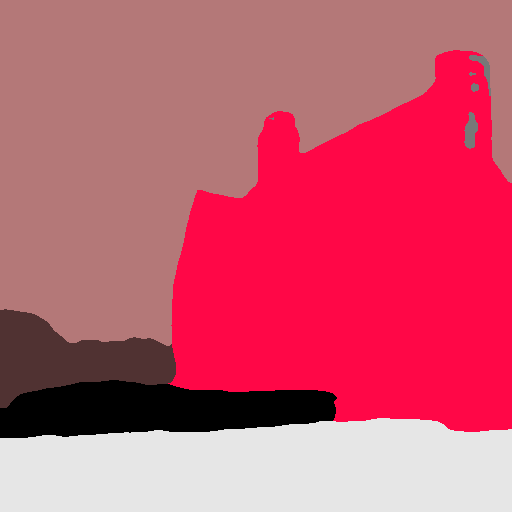

| lllyasviel/control_v11p_sd15_seg |

使用圖像分割進行訓練 | 帶有分割區域的圖像,通常表示為彩色編碼圖像。 |  |

|

| lllyasviel/control_v11p_sd15_lineart |

使用線稿生成進行訓練 | 帶有線稿的圖像,通常是白色背景上的黑色線條。 |  |

|

| lllyasviel/control_v11p_sd15s2_lineart_anime |

使用動漫線稿生成進行訓練 | 帶有動漫風格線稿的圖像。 |  |

|

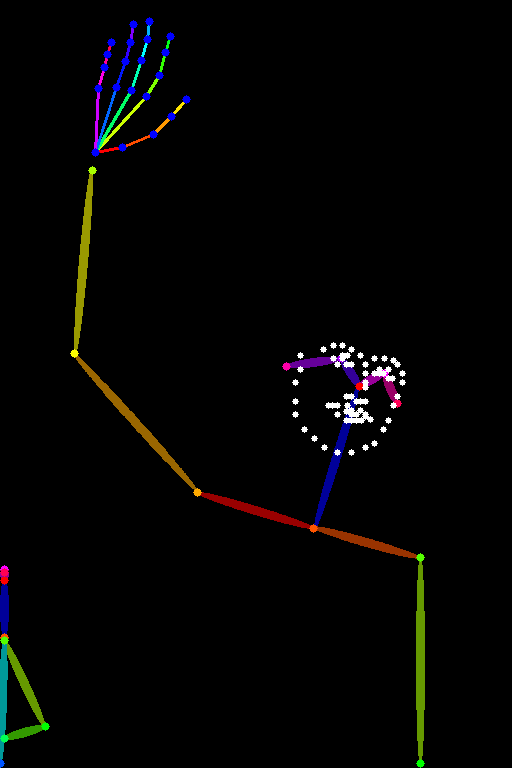

| lllyasviel/control_v11p_sd15_openpose |

使用人體姿勢估計進行訓練 | 帶有人體姿勢的圖像,通常表示為一組關鍵點或骨架。 |  |

|

| lllyasviel/control_v11p_sd15_scribble |

使用基於塗鴉的圖像生成進行訓練 | 帶有塗鴉的圖像,通常是隨機或用戶繪製的筆觸。 |  |

|

| lllyasviel/control_v11p_sd15_softedge |

使用軟邊緣圖像生成進行訓練 | 帶有軟邊緣的圖像,通常用於創建更具繪畫感或藝術效果的圖像。 |  |

|

| lllyasviel/control_v11e_sd15_shuffle |

使用圖像打亂進行訓練 | 帶有打亂補丁或區域的圖像。 |  |

|

| lllyasviel/control_v11f1e_sd15_tile |

使用圖像平鋪進行訓練 | 模糊圖像或圖像的一部分。 |  |

|

MLSD 1.1的改進

- 訓練數據集優化:之前的cnet 1.0訓練數據集存在幾個問題,包括(1)一小部分灰度人體圖像被重複數千次,導致之前的模型有些容易生成灰度人體圖像;(2)一些圖像質量低、非常模糊或有明顯的JPEG偽影;(3)一小部分圖像由於數據處理腳本中的錯誤而存在錯誤的配對提示。新模型修復了訓練數據集的所有問題,在許多情況下應該更加合理。

- 數據集擴充:通過使用MLSD查找包含超過16條直線的圖像,新增了300K張圖像,擴大了訓練數據集。

- 數據增強:在訓練中應用了一些合理的數據增強方法,如隨機左右翻轉。

- 持續訓練:從MLSD 1.0恢復訓練,並使用A100 80G GPU進行了200小時的持續訓練。

更多信息

如需更多信息,請查看Diffusers ControlNet博客文章和官方文檔。

📄 許可證

本模型使用CreativeML OpenRAIL M許可證。該許可證是一種Open RAIL M許可證,改編自BigScience和RAIL Initiative在負責任的AI許可領域的共同工作。另見關於BLOOM Open RAIL許可證的文章,本許可證基於該文章。

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語