モデル概要

モデル特徴

モデル能力

使用事例

🚀 Wan-Fun

😊 ようこそ!このプロジェクトはテキストから動画を生成する機能を提供し、便利な動画生成体験を実現します。

🚀 クイックスタート

1. クラウドでの使用: AliyunDSW/Docker

a. 阿里云 DSW を通じて

DSW には無料の GPU 利用時間があり、ユーザーは一度申請することができ、申請後3ヶ月間有効です。

阿里云はFreetierで無料の GPU 利用時間を提供しており、これを取得して阿里云 PAI - DSW で使用することで、5分以内に CogVideoX - Fun を起動できます。

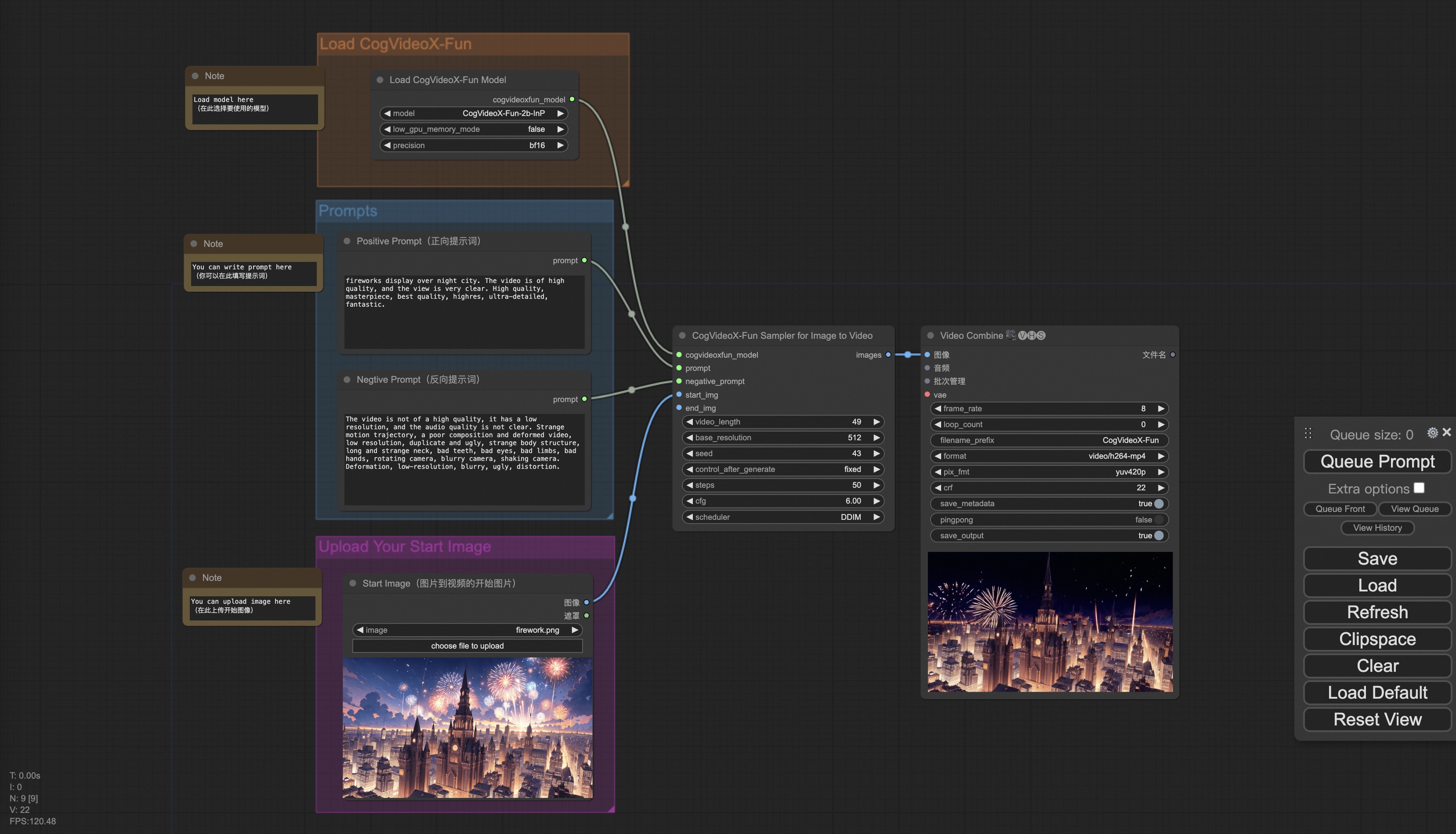

b. ComfyUI を通じて

私たちの ComfyUI インターフェイスは以下の通りです。詳細はComfyUI READMEを参照してください。

c. Docker を通じて

Docker を使用する場合は、マシンに正しく GPU ドライバーと CUDA 環境がインストールされていることを確認し、以下のコマンドを順に実行してください。

# pull image

docker pull mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# enter image

docker run -it -p 7860:7860 --network host --gpus all --security-opt seccomp:unconfined --shm-size 200g mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# clone code

git clone https://github.com/aigc-apps/VideoX-Fun.git

# enter VideoX-Fun's dir

cd VideoX-Fun

# download weights

mkdir models/Diffusion_Transformer

mkdir models/Personalized_Model

# Please use the hugginface link or modelscope link to download the model.

# CogVideoX-Fun

# https://huggingface.co/alibaba-pai/CogVideoX-Fun-V1.1-5b-InP

# https://modelscope.cn/models/PAI/CogVideoX-Fun-V1.1-5b-InP

# Wan

# https://huggingface.co/alibaba-pai/Wan2.1-Fun-V1.1-14B-InP

# https://modelscope.cn/models/PAI/Wan2.1-Fun-V1.1-14B-InP

2. ローカルインストール: 環境チェック/ダウンロード/インストール

a. 環境チェック

このライブラリは以下の環境で動作することを確認しています。

Windows の詳細情報:

- オペレーティングシステム Windows 10

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU: Nvidia - 3060 12G & Nvidia - 3090 24G

Linux の詳細情報:

- オペレーティングシステム Ubuntu 20.04, CentOS

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU:Nvidia - V100 16G & Nvidia - A10 24G & Nvidia - A100 40G & Nvidia - A100 80G

約 60GB の空きディスク容量が必要ですので、確認してください。

b. 重みの配置

重みを指定されたパスに配置することをおすすめします。

ComfyUI を通じて:

モデルを Comfyui の重みフォルダComfyUI/models/Fun_Models/に配置します。

📦 ComfyUI/

├── 📂 models/

│ └── 📂 Fun_Models/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

独自の Python ファイルまたは UI インターフェイスを実行する場合:

📦 models/

├── 📂 Diffusion_Transformer/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

├── 📂 Personalized_Model/

│ └── your trained trainformer model / your trained lora model (for UI load)

✨ 主な機能

このプロジェクトはテキストから動画を生成する機能を提供し、異なるバージョンのモデルをサポートしています。また、ComfyUI や Docker を通じた簡単な起動方法や、さまざまな生成モード(文生動画、図生動画、動画生動画など)を提供しています。

📦 インストール

上述の「クイックスタート」セクションに記載されているクラウドでの使用方法(AliyunDSW/Docker)またはローカルインストール方法を参照してください。

💻 使用例

基本的な使用法

1. 生成

a、显存節約方案

Wan2.1 のパラメータが非常に大きいため、消費者向け GPU での使用に適応するために显存節約方案を考慮する必要があります。各予測ファイルには GPU_memory_mode が提供されており、model_cpu_offload、model_cpu_offload_and_qfloat8、sequential_cpu_offload から選択できます。この方案は CogVideoX - Fun の生成にも適用されます。

- model_cpu_offload は、モデルの使用後に全体が CPU に移動し、一部の显存を節約します。

- model_cpu_offload_and_qfloat8 は、モデルの使用後に全体が CPU に移動し、transformer モデルを float8 で量子化することで、より多くの显存を節約します。

- sequential_cpu_offload は、モデルの各層が使用後に CPU に移動し、速度は遅いですが、大量の显存を節約します。

qfloat8 はモデルの性能を一部低下させますが、より多くの显存を節約できます。显存が十分な場合は、model_cpu_offload の使用をおすすめします。

b、ComfyUI を通じて

詳細はComfyUI READMEを参照してください。

c、Python ファイルを実行する

- ステップ 1:対応する重みをダウンロードし、models フォルダに配置します。

- ステップ 2:異なる重みと予測目標に応じて、異なるファイルを使用して予測を行います。現在、このライブラリは CogVideoX - Fun、Wan2.1、Wan2.1 - Fun をサポートしており、examples フォルダ内のフォルダ名で区別されます。異なるモデルがサポートする機能は異なるため、具体的な状況に応じて区別してください。CogVideoX - Fun を例に説明します。

- 文生動画:

- examples/cogvideox_fun/predict_t2v.py ファイル内の prompt、neg_prompt、guidance_scale、seed を修正します。

- その後、examples/cogvideox_fun/predict_t2v.py ファイルを実行し、生成結果を待ちます。結果は samples/cogvideox - fun - videos フォルダに保存されます。

- 图生動画:

- examples/cogvideox_fun/predict_i2v.py ファイル内の validation_image_start、validation_image_end、prompt、neg_prompt、guidance_scale、seed を修正します。

- validation_image_start は動画の開始画像、validation_image_end は動画の終了画像です。

- その後、examples/cogvideox_fun/predict_i2v.py ファイルを実行し、生成結果を待ちます。結果は samples/cogvideox - fun - videos_i2v フォルダに保存されます。

- 動画生動画:

- examples/cogvideox_fun/predict_v2v.py ファイル内の validation_video、validation_image_end、prompt、neg_prompt、guidance_scale、seed を修正します。

- validation_video は動画生動画の参照動画です。以下の動画を使用してデモを実行できます:デモ動画

- その後、examples/cogvideox_fun/predict_v2v.py ファイルを実行し、生成結果を待ちます。結果は samples/cogvideox - fun - videos_v2v フォルダに保存されます。

- 普通控制生動画(Canny、Pose、Depth など):

- examples/cogvideox_fun/predict_v2v_control.py ファイル内の control_video、validation_image_end、prompt、neg_prompt、guidance_scale、seed を修正します。

- control_video は制御生動画の制御動画で、Canny、Pose、Depth などのオペレーターで抽出された動画です。以下の動画を使用してデモを実行できます:デモ動画

- その後、examples/cogvideox_fun/predict_v2v_control.py ファイルを実行し、生成結果を待ちます。結果は samples/cogvideox - fun - videos_v2v_control フォルダに保存されます。

- 文生動画:

- ステップ 3:独自にトレーニングした他のバックボーンと Lora を組み合わせる場合は、examples/{model_name}/predict_t2v.py 内の examples/{model_name}/predict_i2v.py と lora_path を適宜修正してください。

d、UI インターフェイスを通じて

WebUI は文生動画、图生動画、動画生動画、普通控制生動画(Canny、Pose、Depth など)をサポートしています。現在、このライブラリは CogVideoX - Fun、Wan2.1、Wan2.1 - Fun をサポートしており、examples フォルダ内のフォルダ名で区別されます。異なるモデルがサポートする機能は異なるため、具体的な状況に応じて区別してください。CogVideoX - Fun を例に説明します。

- ステップ 1:対応する重みをダウンロードし、models フォルダに配置します。

- ステップ 2:examples/cogvideox_fun/app.py ファイルを実行し、gradio ページにアクセスします。

- ステップ 3:ページで生成モデルを選択し、prompt、neg_prompt、guidance_scale、seed などを入力し、生成をクリックして、生成結果を待ちます。結果は sample フォルダに保存されます。

📚 ドキュメント

モデルアドレス

V1.1:

| 名称 | 記憶容量 | Hugging Face | Model Scope | 説明 |

|---|---|---|---|---|

| Wan2.1-Fun-V1.1-1.3B-InP | 19.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-V1.1-1.3B のテキストから動画生成の重みで、多解像度でトレーニングされ、最初と最後の画像の予測をサポートします。 |

| Wan2.1-Fun-V1.1-14B-InP | 47.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-V1.1-14B のテキストから動画生成の重みで、多解像度でトレーニングされ、最初と最後の画像の予測をサポートします。 |

| Wan2.1-Fun-V1.1-1.3B-Control | 19.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-V1.1-1.3B の動画制御重みで、Canny、Depth、Pose、MLSD などの異なる制御条件をサポートし、参照画像 + 制御条件による制御と軌跡制御をサポートします。多解像度(512、768、1024)の動画予測をサポートし、81 フレーム、毎秒 16 フレームでトレーニングされ、多言語予測をサポートします。 |

| Wan2.1-Fun-V1.1-14B-Control | 47.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-V1.1-14B の動画制御重みで、Canny、Depth、Pose、MLSD などの異なる制御条件をサポートし、参照画像 + 制御条件による制御と軌跡制御をサポートします。多解像度(512、768、1024)の動画予測をサポートし、81 フレーム、毎秒 16 フレームでトレーニングされ、多言語予測をサポートします。 |

| Wan2.1-Fun-V1.1-1.3B-Control-Camera | 19.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-V1.1-1.3B のカメラレンズ制御重みです。多解像度(512、768、1024)の動画予測をサポートし、81 フレーム、毎秒 16 フレームでトレーニングされ、多言語予測をサポートします。 |

| Wan2.1-Fun-V1.1-14B-Control | 47.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-V1.1-14B のカメラレンズ制御重みです。多解像度(512、768、1024)の動画予測をサポートし、81 フレーム、毎秒 16 フレームでトレーニングされ、多言語予測をサポートします。 |

V1.0:

| 名称 | 記憶容量 | Hugging Face | Model Scope | 説明 |

|---|---|---|---|---|

| Wan2.1-Fun-1.3B-InP | 19.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-1.3B のテキストから動画生成の重みで、多解像度でトレーニングされ、最初と最後の画像の予測をサポートします。 |

| Wan2.1-Fun-14B-InP | 47.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-14B のテキストから動画生成の重みで、多解像度でトレーニングされ、最初と最後の画像の予測をサポートします。 |

| Wan2.1-Fun-1.3B-Control | 19.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-1.3B の動画制御重みで、Canny、Depth、Pose、MLSD などの異なる制御条件をサポートし、軌跡制御をサポートします。多解像度(512、768、1024)の動画予測をサポートし、81 フレーム、毎秒 16 フレームでトレーニングされ、多言語予測をサポートします。 |

| Wan2.1-Fun-14B-Control | 47.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-14B の動画制御重みで、Canny、Depth、Pose、MLSD などの異なる制御条件をサポートし、軌跡制御をサポートします。多解像度(512、768、1024)の動画予測をサポートし、81 フレーム、毎秒 16 フレームでトレーニングされ、多言語予測をサポートします。 |

動画作品

Wan2.1-Fun-V1.1-14B-InP && Wan2.1-Fun-V1.1-1.3B-InP

Wan2.1-Fun-V1.1-14B-Control && Wan2.1-Fun-V1.1-1.3B-Control

Generic Control Video + Reference Image:

| 参照画像 | 制御動画 | Wan2.1-Fun-V1.1-14B-Control | Wan2.1-Fun-V1.1-1.3B-Control |

|

|

|||

Generic Control Video (Canny, Pose, Depth, etc.) and Trajectory Control:

Wan2.1-Fun-V1.1-14B-Control-Camera && Wan2.1-Fun-V1.1-1.3B-Control-Camera

| 上方向へのパン | 左方向へのパン | 右方向へのパン |

| 下方向へのパン | 上方向と左方向へのパン | 上方向と右方向へのパン |

📄 ライセンス

このプロジェクトは Apache License (Version 2.0) を採用しています。

参考文献

- CogVideo: https://github.com/THUDM/CogVideo/

- EasyAnimate: https://github.com/aigc-apps/EasyAnimate

- Wan2.1: https://github.com/Wan-Video/Wan2.1/

- ComfyUI-KJNodes: https://github.com/kijai/ComfyUI-KJNodes

- ComfyUI-EasyAnimateWrapper: https://github.com/kijai/ComfyUI-EasyAnimateWrapper

- ComfyUI-CameraCtrl-Wrapper: https://github.com/chaojie/ComfyUI-CameraCtrl-Wrapper

- CameraCtrl: https://github.com/hehao13/CameraCtrl

Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語