モデル概要

モデル特徴

モデル能力

使用事例

license: creativeml-openrail-m tags:

-

stable-diffusion

-

stable-diffusion-diffusers

-

text-to-image inference: true extra_gated_prompt: |- このモデルはCreativeML OpenRAIL-Mライセンスの下で公開されており、すべてのユーザーが利用可能です。 CreativeML OpenRAILライセンスでは以下の事項が規定されています:

- 違法または有害な出力やコンテンツを意図的に生成・共有するためにモデルを使用することは禁止されています

- CompVisは生成された出力に対する権利を主張せず、ユーザーはライセンスの規定に反しない限り自由に使用できます

- モデルの重みを再配布したり、商用・サービスとして利用することが可能です。その場合、ライセンスと同じ使用制限を適用し、すべてのユーザーにCreativeML OpenRAIL-Mライセンスのコピーを提供する必要があります(ライセンス全文をよくお読みください) 完全なライセンスはこちらからご確認ください: https://huggingface.co/spaces/CompVis/stable-diffusion-license

extra_gated_heading: このモデルにアクセスするにはライセンスをお読みください

Stable Diffusion v1-5 モデルカード

Stable Diffusionは、テキスト入力から写真のようにリアルな画像を生成可能な潜在拡散モデルです。 Stable Diffusionの機能について詳しくは、🤗のStable Diffusionブログをご覧ください。

Stable-Diffusion-v1-5チェックポイントはStable-Diffusion-v1-2の重みで初期化され、 その後"laion-aesthetics v2 5+"データセットで512x512解像度の画像595,000ステップにわたってファインチューニングされ、テキスト条件付けを10%ドロップすることでclassifier-free guidance samplingが改善されました。

このモデルは🧨DiffusersライブラリとRunwayML GitHubリポジトリの両方で使用できます。

Diffusers

from diffusers import StableDiffusionPipeline

import torch

model_id = "runwayml/stable-diffusion-v1-5"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda")

prompt = "火星で馬に乗る宇宙飛行士の写真"

image = pipe(prompt).images[0]

image.save("astronaut_rides_horse.png")

より詳細な説明、ユースケース、JAXでの使用例については、こちらの手順に従ってください。

オリジナルGitHubリポジトリ

-

重みをダウンロード

- v1-5-pruned-emaonly.ckpt - 4.27GB、ema-only重み。VRAM使用量が少なく、推論に適しています

- v1-5-pruned.ckpt - 7.7GB、ema+non-ema重み。VRAM使用量が多く、ファインチューニングに適しています

-

こちらの手順に従ってください。

モデル詳細

-

開発者: Robin Rombach, Patrick Esser

-

モデルタイプ: 拡散ベースのテキストから画像生成モデル

-

言語: 英語

-

ライセンス: The CreativeML OpenRAIL M licenseはOpen RAIL M licenseで、BigScienceとthe RAIL Initiativeが共同で進める責任あるAIライセンスの取り組みに基づいています。ライセンスのベースとなったBLOOM Open RAIL licenseに関する記事も参照してください。

-

モデル説明: このモデルはテキストプロンプトに基づいて画像を生成・変更するために使用できます。Imagen paperで提案された固定済みの事前学習済みテキストエンコーダー(CLIP ViT-L/14)を使用するLatent Diffusion Modelです。

-

詳細情報のリソース: GitHubリポジトリ, 論文.

-

引用:

@InProceedings{Rombach_2022_CVPR, author = {Rombach, Robin and Blattmann, Andreas and Lorenz, Dominik and Esser, Patrick and Ommer, Bj\"orn}, title = {High-Resolution Image Synthesis With Latent Diffusion Models}, booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)}, month = {June}, year = {2022}, pages = {10684-10695} }

用途

直接的な利用

このモデルは研究目的のみを意図しています。可能な研究分野とタスクには以下が含まれます:

- 有害なコンテンツを生成する可能性のあるモデルの安全な展開

- 生成モデルの限界とバイアスの調査と理解

- 芸術作品の生成とデザインその他の芸術的プロセスでの利用

- 教育的または創造的なツールでの応用

- 生成モデルの研究

除外される用途については以下で説明します。

誤用、悪意のある使用、範囲外の使用

注: このセクションはDALLE-MINIモデルカードから引用していますが、Stable Diffusion v1にも同様に適用されます。

このモデルは、人々にとって敵対的または疎外感を与える環境を作り出す画像を意図的に作成または拡散するために使用すべきではありません。これには、人々が不快、苦痛、または攻撃的と予見できる画像の生成、または歴史的または現在のステレオタイプを広めるコンテンツが含まれます。

範囲外の使用

このモデルは、人々や出来事の事実や真実の表現として訓練されていないため、そのようなコンテンツを生成するためにモデルを使用することは、このモデルの能力の範囲外です。

誤用と悪意のある使用

個人を残酷に扱うコンテンツを生成するためにこのモデルを使用することは、このモデルの誤用です。これには以下が含まれますが、これらに限定されません:

- 人々やその環境、文化、宗教などに対する軽蔑的、非人間的、またはその他の有害な表現の生成

- 差別的なコンテンツや有害なステレオタイプを意図的に促進または拡散すること

- 個人の同意なしに成りすますこと

- 見る可能性のある人々の同意なしの性的コンテンツ

- 誤報と偽情報

- 甚大な暴力とゴアの表現

- 著作権またはライセンスされた素材の利用規約に違反して共有すること

- 著作権またはライセンスされた素材を改変したコンテンツを利用規約に違反して共有すること

制限とバイアス

制限

- モデルは完全な写実性を達成しません

- モデルは読みやすいテキストをレンダリングできません

- 「青い球体の上の赤い立方体」のような構成性を必要とするより難しいタスクでは性能が良くありません

- 顔や人物全般が適切に生成されない場合があります

- モデルは主に英語のキャプションで訓練されており、他の言語ではうまく機能しません

- モデルのオートエンコーディング部分はロスがあります

- モデルは大規模なデータセットLAION-5Bで訓練されており、成人向けの素材が含まれているため、追加の安全対策と考慮なしに製品使用には適していません

- データセットの重複排除のための追加の対策は取られていません。その結果、訓練データ内で重複している画像にある程度の記憶が観察されます。訓練データはhttps://rom1504.github.io/clip-retrieval/で検索可能で、記憶された画像の検出に役立つ可能性があります。

バイアス

画像生成モデルの能力は印象的ですが、社会的なバイアスを強化または悪化させる可能性もあります。 Stable Diffusion v1はLAION-2B(en)のサブセットで訓練されており、 主に英語の説明に限定された画像で構成されています。 他の言語を使用するコミュニティや文化からのテキストや画像は十分に考慮されていない可能性があります。 これにより、モデルの全体的な出力に影響を与え、白人の西洋文化がデフォルトとして設定されることがよくあります。さらに、 非英語のプロンプトでコンテンツを生成するモデルの能力は、英語のプロンプトと比べて著しく劣ります。

安全性モジュール

このモデルの意図された使用法は、DiffusersのSafety Checkerと共に使用することです。

このチェッカーは、モデルの出力を既知のハードコードされたNSFW概念と照合することで機能します。

これらの概念は、このフィルターの逆エンジニアリングの可能性を減らすために意図的に隠されています。

具体的には、チェッカーは画像生成後にCLIPTextModelの埋め込み空間内の有害な概念のクラス確率を比較します。

これらの概念は生成された画像と共にモデルに渡され、各NSFW概念に対して手作業で調整された重みと比較されます。

訓練

訓練データ モデル開発者はモデルの訓練に以下のデータセットを使用しました:

- LAION-2B (en) とそのサブセット(次のセクションを参照)

訓練手順 Stable Diffusion v1-5は、オートエンコーダと拡散モデルを組み合わせた潜在拡散モデルで、オートエンコーダの潜在空間で訓練されます。訓練中に、

- 画像はエンコーダを通して符号化され、画像は潜在表現に変換されます。オートエンコーダは8の相対的なダウンサンプリング係数を使用し、H x W x 3の形状の画像をH/f x W/f x 4の形状の潜在にマッピングします

- テキストプロンプトはViT-L/14テキストエンコーダを通して符号化されます

- テキストエンコーダの非プール出力は、クロスアテンションを介して潜在拡散モデルのUNetバックボーンに供給されます

- 損失は、潜在に追加されたノイズとUNetによって行われた予測との間の再構成目的です

現在、6つのStable Diffusionチェックポイントが提供されており、以下のように訓練されました。

-

stable-diffusion-v1-1: laion2B-enで解像度256x256で237,000ステップ。 laion-high-resolution(LAION-5Bから解像度>= 1024x1024の170Mの例)で解像度512x512で194,000ステップ。 -

stable-diffusion-v1-2:stable-diffusion-v1-1から継続。 "laion-improved-aesthetics"(laion2B-enのサブセット、 元のサイズ>= 512x512、推定美学スコア> 5.0、推定透かし確率< 0.5でフィルタリングされたもの。透かし推定はLAION-5Bのメタデータから、美学スコアは改良された美学推定器を使用して推定)で解像度512x512で515,000ステップ。 -

stable-diffusion-v1-3:stable-diffusion-v1-2から継続 - "laion-improved-aesthetics"で解像度512x512で195,000ステップと、classifier-free guidance samplingを改善するためにテキスト条件付けを10%ドロップ。 -

stable-diffusion-v1-4stable-diffusion-v1-2から継続 - "laion-aesthetics v2 5+"で解像度512x512で225,000ステップと、classifier-free guidance samplingを改善するためにテキスト条件付けを10%ドロップ。 -

stable-diffusion-v1-5stable-diffusion-v1-2から継続 - "laion-aesthetics v2 5+"で解像度512x512で595,000ステップと、classifier-free guidance samplingを改善するためにテキスト条件付けを10%ドロップ。 -

stable-diffusion-inpaintingstable-diffusion-v1-5から継続 - その後、"laion-aesthetics v2 5+"で解像度512x512で440,000ステップのインペインティング訓練と、テキスト条件付けを10%ドロップ。インペインティングでは、UNetには5つの追加入力チャンネル(マスクされた画像の符号化用に4つ、マスク自体用に1つ)があり、非インペインティングチェックポイントの復元後に重みがゼロ初期化されました。訓練中、合成マスクを生成し、25%で全てをマスクします。 -

ハードウェア: 32 x 8 x A100 GPU

-

オプティマイザ: AdamW

-

勾配蓄積: 2

-

バッチ: 32 x 8 x 2 x 4 = 2048

-

学習率: 10,000ステップで0.0001までウォームアップし、その後一定に保たれました

評価結果

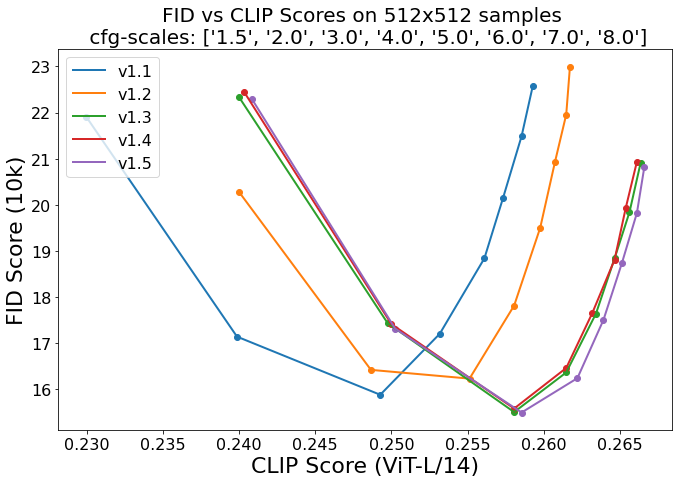

異なるclassifier-free guidanceスケール(1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0, 8.0)と50 PNDM/PLMSサンプリング ステップを使用した評価は、チェックポイントの相対的な改善を示しています:

COCO2017検証セットから10,000のランダムなプロンプトを使用して評価され、512x512解像度で評価されました。FIDスコアのために最適化されていません。

環境への影響

Stable Diffusion v1 推定排出量 この情報に基づき、Lacoste et al. (2019)で提示されたMachine Learning Impact calculatorを使用して以下のCO2排出量を推定しました。ハードウェア、実行時間、クラウドプロバイダー、および計算リージョンを使用して炭素影響を推定しました。

- ハードウェアタイプ: A100 PCIe 40GB

- 使用時間: 150000時間

- クラウドプロバイダー: AWS

- 計算リージョン: US-east

- 排出された炭素(電力消費量×時間×電力網の場所に基づく炭素生成量): 11250 kg CO2 eq.

引用

@InProceedings{Rombach_2022_CVPR,

author = {Rombach, Robin and Blattmann, Andreas and Lorenz, Dominik and Esser, Patrick and Ommer, Bj\"orn},

title = {High-Resolution Image Synthesis With Latent Diffusion Models},

booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)},

month = {June},

year = {2022},

pages = {10684-10695}

}

このモデルカードはRobin RombachとPatrick Esserによって作成され、DALL-E Miniモデルカードに基づいています。

Transformers

Transformers Transformers 英語

Transformers 英語 Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers 複数言語対応

Transformers 複数言語対応 Transformers

Transformers Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語