モデル概要

モデル特徴

モデル能力

使用事例

license: apache-2.0 language:

- en

- zh pipeline_tag: text-to-video library_name: diffusers tags:

- video

- video-generation

Wan-Fun

😊 ようこそ!

目次

モデルアドレス

V1.0:

| 名称 | ストレージ容量 | Hugging Face | Model Scope | 説明 |

|---|---|---|---|---|

| Wan2.1-Fun-1.3B-InP | 19.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-1.3Bの文図生ビデオ重み。多解像度でトレーニングされ、先頭と末尾の画像予測に対応。 |

| Wan2.1-Fun-14B-InP | 47.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-14Bの文図生ビデオ重み。多解像度でトレーニングされ、先頭と末尾の画像予測に対応。 |

| Wan2.1-Fun-1.3B-Control | 19.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-1.3Bのビデオ制御重み。Canny、Depth、Pose、MLSDなどのさまざまな制御条件に対応。同時にトラック制御の使用もサポート。多解像度(512、768、1024)のビデオ予測に対応。81フレーム、毎秒16フレームでトレーニングされ、多言語予測に対応。 |

| Wan2.1-Fun-14B-Control | 47.0 GB | 🤗リンク | 😄リンク | Wan2.1-Fun-14Bのビデオ制御重み。Canny、Depth、Pose、MLSDなどのさまざまな制御条件に対応。同時にトラック制御の使用もサポート。多解像度(512、768、1024)のビデオ予測に対応。81フレーム、毎秒16フレームでトレーニングされ、多言語予測に対応。 |

ビデオ作品

Wan2.1-Fun-14B-InP && Wan2.1-Fun-1.3B-InP

Wan2.1-Fun-14B-Control && Wan2.1-Fun-1.3B-Control

クイックスタート

1. クラウドでの使用: AliyunDSW/Docker

a. 阿里云DSW経由

DSWには無料のGPU使用時間があり、ユーザーは1回申請でき、申請後3か月間有効です。

阿里云はFreetierで無料のGPU使用時間を提供しており、取得して阿里云PAI-DSWで使用すると、5分以内にCogVideoX-Funを起動できます。

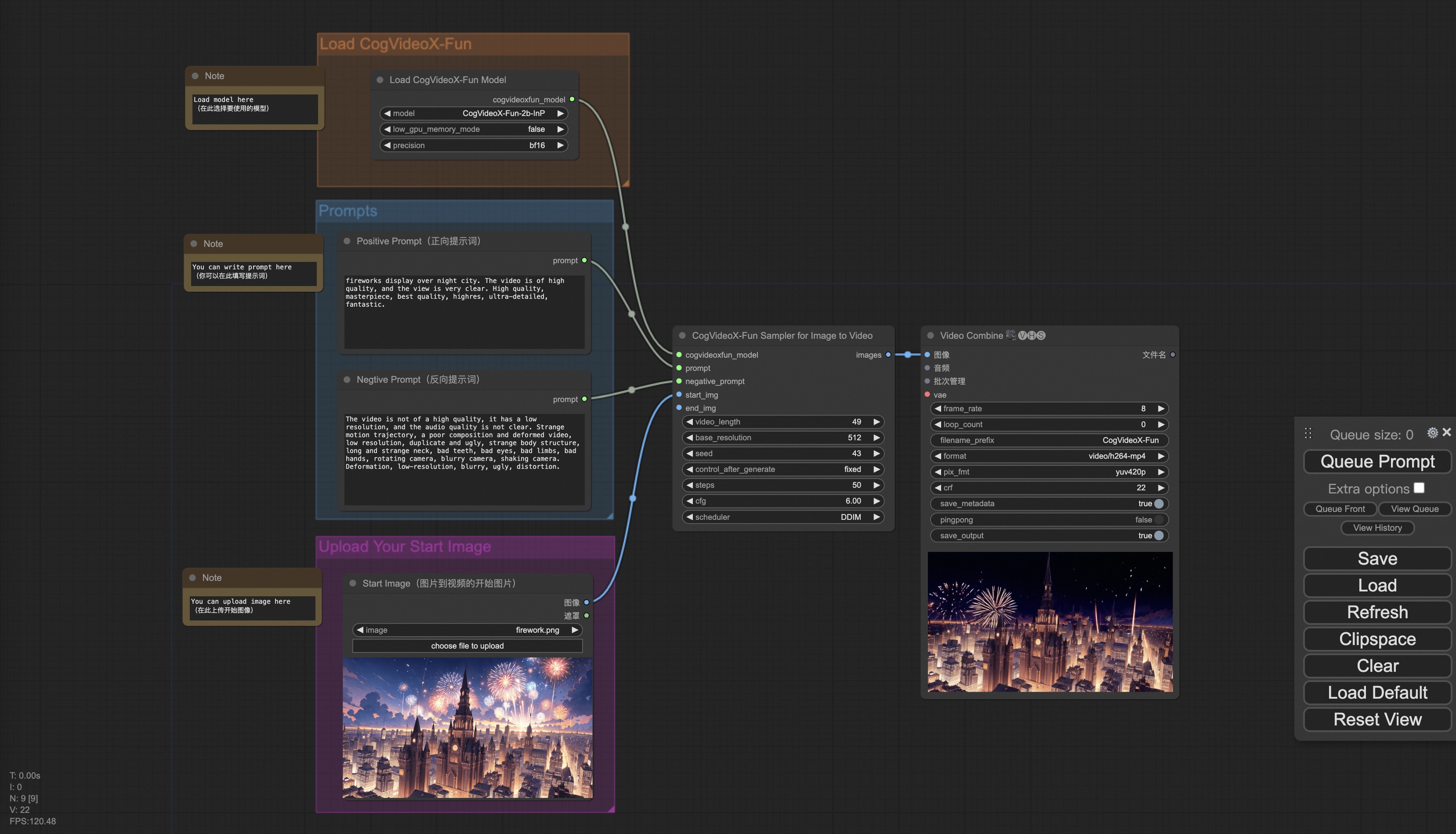

b. ComfyUI経由

私たちのComfyUIインターフェイスは以下の通りです。詳細はComfyUI READMEを参照してください。

c. docker経由

dockerを使用する場合は、マシンに正しくGPUドライバとCUDA環境がインストールされていることを確認した上で、以下のコマンドを順に実行してください。

# イメージを取得

docker pull mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# イメージに入る

docker run -it -p 7860:7860 --network host --gpus all --security-opt seccomp:unconfined --shm-size 200g mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# コードをクローン

git clone https://github.com/aigc-apps/CogVideoX-Fun.git

# CogVideoX-Funのディレクトリに入る

cd CogVideoX-Fun

# 重みをダウンロード

mkdir models/Diffusion_Transformer

mkdir models/Personalized_Model

# モデルをhugginfaceリンクまたはmodelscopeリンクからダウンロードしてください。

# CogVideoX-Fun

# https://huggingface.co/alibaba-pai/CogVideoX-Fun-V1.1-5b-InP

# https://modelscope.cn/models/PAI/CogVideoX-Fun-V1.1-5b-InP

# Wan

# https://huggingface.co/alibaba-pai/Wan2.1-Fun-14B-InP

# https://modelscope.cn/models/PAI/Wan2.1-Fun-14B-InP

2. ローカルインストール: 環境チェック/ダウンロード/インストール

a. 環境チェック

このライブラリは以下の環境で動作することを確認しています。

Windowsの詳細:

- オペレーティングシステム Windows 10

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU: Nvidia-3060 12G & Nvidia-3090 24G

Linuxの詳細:

- オペレーティングシステム Ubuntu 20.04, CentOS

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU:Nvidia-V100 16G & Nvidia-A10 24G & Nvidia-A100 40G & Nvidia-A100 80G

約60GBの空きディスク領域が必要ですので、確認してください!

b. 重みの配置

重みを指定のパスに配置することをおすすめします。

📦 models/

├── 📂 Diffusion_Transformer/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-14B-InP

│ └── 📂 Wan2.1-Fun-1.3B-InP/

├── 📂 Personalized_Model/

│ └── トレーニング済みのトランスフォーマーモデル / トレーニング済みのloraモデル (UIロード用)

使用方法

1. 生成

a、メモリ節約方案

Wan2.1のパラメータが非常に大きいため、メモリ節約方案を検討する必要があります。これにより、消費者向けGPUに対応するためのメモリを節約できます。各予測ファイルにはGPU_memory_modeが用意されており、model_cpu_offload、model_cpu_offload_and_qfloat8、sequential_cpu_offloadから選択できます。この方案はCogVideoX-Funの生成にも同様に適用されます。

- model_cpu_offloadは、モデル全体が使用後にCPUに移動し、一部のメモリを節約できます。

- model_cpu_offload_and_qfloat8は、モデル全体が使用後にCPUに移動し、トランスフォーマーモデルをfloat8で量子化することで、より多くのメモリを節約できます。

- sequential_cpu_offloadは、モデルの各層が使用後にCPUに移動し、速度は遅くなりますが、大量のメモリを節約できます。

qfloat8はモデルの性能を一部低下させますが、より多くのメモリを節約できます。メモリが十分な場合は、model_cpu_offloadの使用をおすすめします。

b、ComfyUIを通じて

詳細はComfyUI READMEを参照してください。

c、Pythonファイルを実行

- ステップ1:対応する重みをダウンロードし、modelsフォルダに配置します。

- ステップ2:異なる重みと予測目標に応じて、異なるファイルを使用して予測します。現在、このライブラリはCogVideoX-Fun、Wan2.1、Wan2.1-Funをサポートしており、examplesフォルダ内でフォルダ名で区別されています。異なるモデルがサポートする機能は異なるため、具体的な状況に応じて区別してください。CogVideoX-Funを例にとると、以下の通りです。

- 文章からビデオを生成する場合:

- examples/cogvideox_fun/predict_t2v.pyファイルでprompt、neg_prompt、guidance_scale、seedを変更します。

- その後、examples/cogvideox_fun/predict_t2v.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videosフォルダに保存されます。

- 画像からビデオを生成する場合:

- examples/cogvideox_fun/predict_i2v.pyファイルでvalidation_image_start、validation_image_end、prompt、neg_prompt、guidance_scale、seedを変更します。

- validation_image_startはビデオの開始画像、validation_image_endはビデオの終了画像です。

- その後、examples/cogvideox_fun/predict_i2v.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videos_i2vフォルダに保存されます。

- ビデオからビデオを生成する場合:

- examples/cogvideox_fun/predict_v2v.pyファイルでvalidation_video、validation_image_end、prompt、neg_prompt、guidance_scale、seedを変更します。

- validation_videoはビデオ生成の参考ビデオです。以下のビデオを使用してデモを実行できます:デモビデオ

- その後、examples/cogvideox_fun/predict_v2v.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videos_v2vフォルダに保存されます。

- 通常の制御によるビデオ生成(Canny、Pose、Depthなど)の場合:

- examples/cogvideox_fun/predict_v2v_control.pyファイルでcontrol_video、validation_image_end、prompt、neg_prompt、guidance_scale、seedを変更します。

- control_videoは制御によるビデオ生成の制御ビデオで、Canny、Pose、Depthなどのオペレータで抽出されたビデオです。以下のビデオを使用してデモを実行できます:デモビデオ

- その後、examples/cogvideox_fun/predict_v2v_control.pyファイルを実行し、生成結果を待ちます。結果はsamples/cogvideox-fun-videos_v2v_controlフォルダに保存されます。

- 文章からビデオを生成する場合:

- ステップ3:独自にトレーニングした他のバックボーンとLoraを組み合わせる場合は、examples/{model_name}/predict_t2v.py、examples/{model_name}/predict_i2v.pyのlora_pathを適宜変更してください。

d、UIインターフェイスを通じて

webuiは文章からビデオの生成、画像からビデオの生成、ビデオからビデオの生成、通常の制御によるビデオ生成(Canny、Pose、Depthなど)をサポートしています。現在、このライブラリはCogVideoX-Fun、Wan2.1、Wan2.1-Funをサポートしており、examplesフォルダ内でフォルダ名で区別されています。異なるモデルがサポートする機能は異なるため、具体的な状況に応じて区別してください。CogVideoX-Funを例にとると、以下の通りです。

- ステップ1:対応する重みをダウンロードし、modelsフォルダに配置します。

- ステップ2:examples/cogvideox_fun/app.pyファイルを実行し、gradioページにアクセスします。

- ステップ3:ページで生成モデルを選択し、prompt、neg_prompt、guidance_scale、seedなどを入力し、生成をクリックして生成結果を待ちます。結果はsampleフォルダに保存されます。

参考文献

- CogVideo: https://github.com/THUDM/CogVideo/

- EasyAnimate: https://github.com/aigc-apps/EasyAnimate

- Wan2.1: https://github.com/Wan-Video/Wan2.1/

ライセンス

このプロジェクトは Apache License (Version 2.0) を採用しています。

Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語