Sd Controlnet Hed

HED境界条件でトレーニングされたControlNetモデル、Stable Diffusionで生成される画像のエッジ特徴を制御するために使用

ダウンロード数 552

リリース時間 : 2/24/2023

モデル概要

ControlNetは、HED境界図などの追加条件を付加することで拡散モデルの生成を制御するニューラルネットワーク構造で、Stable Diffusionと組み合わせて精密な画像生成制御を実現

モデル特徴

HEDエッジ制御

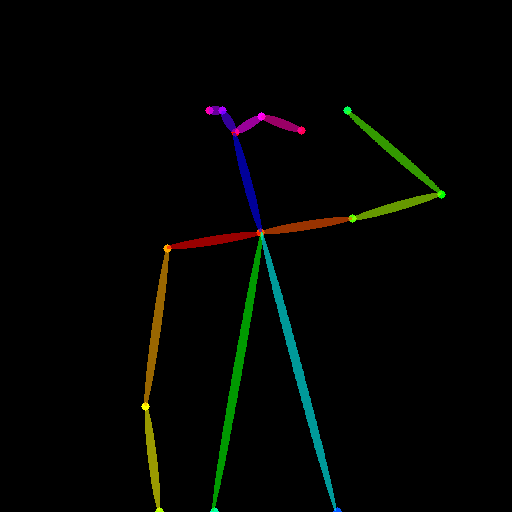

HED(Holistically-Nested Edge Detection)アルゴリズムで抽出されたソフトエッジ特徴を制御条件として使用

少数サンプル適応

小規模なトレーニングセット(<5万サンプル)でもロバストな性能を維持

効率的なトレーニング

トレーニング速度は拡散モデルのファインチューニングと同等で、個人デバイスでのトレーニングをサポート

高い互換性

Stable Diffusion v1-5および派生モデル(dreamboothファインチューニング版など)と連携可能

モデル能力

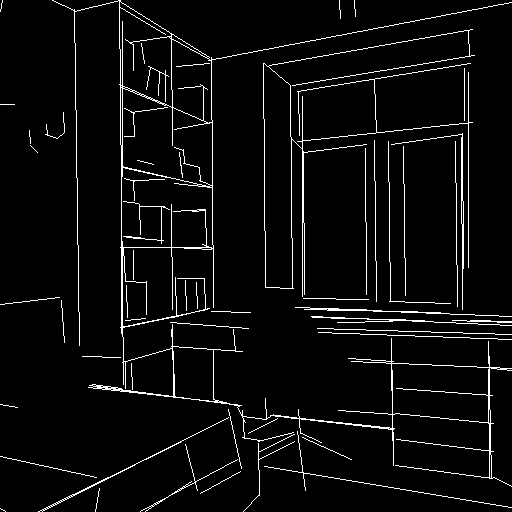

画像エッジ検出

条件付き画像生成

アート創作支援

画像スタイル変換

使用事例

デジタルアート創作

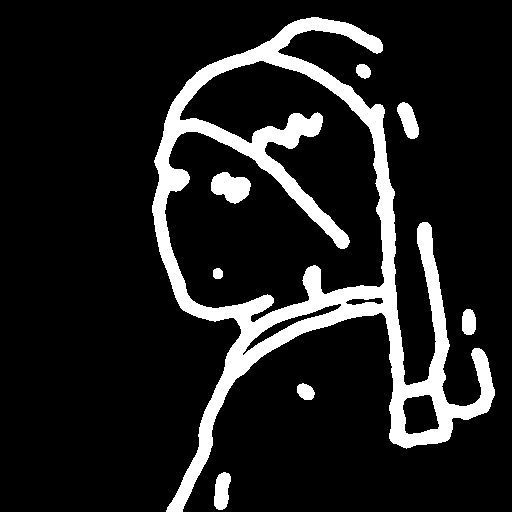

スケッチから油絵へ

手描きスケッチを指定スタイルの油絵作品に変換

元の構図を維持しつつスタイル変換を実現

コンセプトデザイン

簡単な線画から詳細なコンセプト図を生成

デザイン案の迅速な反復が可能

画像処理

画像強調

エッジガイダンスにより低品質画像のディテールを強化

画像の明瞭度と構造的完全性の改善

おすすめAIモデル

Llama 3 Typhoon V1.5x 8b Instruct

タイ語専用に設計された80億パラメータの命令モデルで、GPT-3.5-turboに匹敵する性能を持ち、アプリケーションシナリオ、検索拡張生成、制限付き生成、推論タスクを最適化

大規模言語モデル Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-TinyはSODAデータセットでトレーニングされた超小型対話モデルで、エッジデバイス推論向けに設計されており、体積はCosmo-3Bモデルの約2%です。

対話システム Transformers 英語

Transformers 英語

Transformers 英語

Transformers 英語C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

RoBERTaアーキテクチャに基づく中国語抽出型QAモデルで、与えられたテキストから回答を抽出するタスクに適しています。

質問応答システム 中国語

R

uer

2,694

98