🚀 Quilt-LlaVAモデルカード

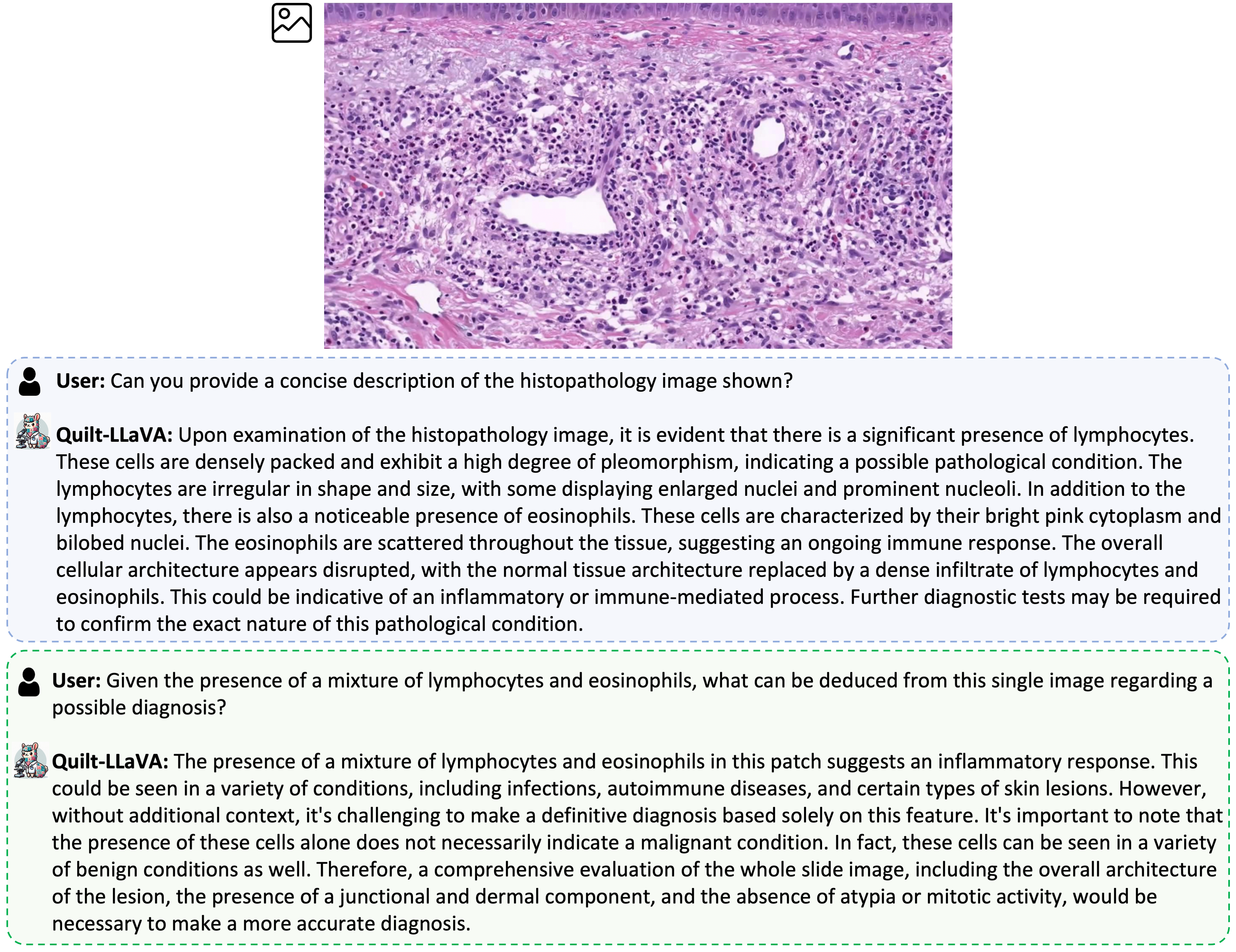

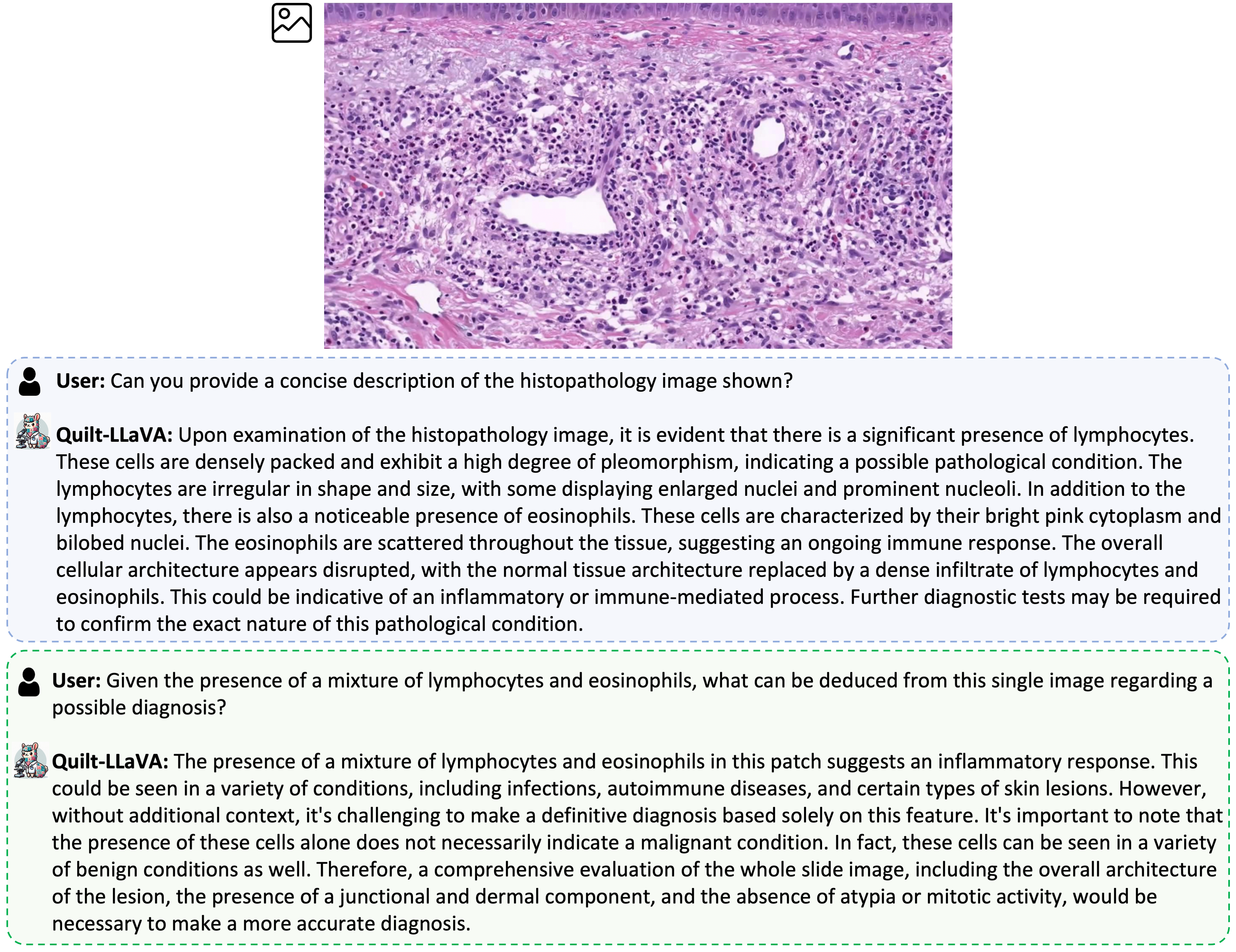

Quilt-LlaVAは、組織病理学の教育動画から取得した画像とGPTが生成したマルチモーダル命令追従データを用いて、LLaMA/Vicunaを微調整することで訓練されたオープンソースのチャットボットです。医学分野の研究に役立つマルチモーダルモデルです。

🚀 クイックスタート

このモデルを使用するには、以下の利用規約に同意する必要があります。

Please read and agree to the following terms: 1. The requester details

provided are not faked. 2. The model will not be used for commercial/clinical

purposes and will be used for the purpose of scientific research only. 3. The

data will not be re-distributed, published, copied, or further disseminated in

any way or form whatsoever, whether for profit or not. 4. The right

study/paper (Quilt-1M(https://quilt1m.github.io/) and Quilt-LLaVa

(https://quilt-llava.github.io) papers) will be cited in any publication(s)

that uses this model/data

✨ 主な機能

Quilt-LlaVAは、組織病理学の画像を用いた研究や教育に役立つ機能を備えています。具体的には、以下のようなことができます。

- 組織病理学の画像に関する質問に回答する

- 画像から情報を抽出する

- 画像に関する説明を生成する

📚 ドキュメント

モデル詳細

| 属性 |

详情 |

| モデルタイプ |

Quilt-LLaVA は、組織病理学の教育動画から取得した画像とGPTが生成したマルチモーダル命令追従データを用いて、LLaMA/Vicunaを微調整することで訓練されたオープンソースのチャットボットです。Transformerアーキテクチャに基づく自己回帰型言語モデルです。 |

| 引用 |

```bibtex |

| @article{seyfioglu2023quilt, |

|

| title={Quilt-LLaVA: Visual Instruction Tuning by Extracting Localized Narratives from Open-Source Histopathology Videos}, |

|

| author={Seyfioglu, Mehmet Saygin and Ikezogwo, Wisdom O and Ghezloo, Fatemeh and Krishna, Ranjay and Shapiro, Linda}, |

|

| journal={arXiv preprint arXiv:2312.04746}, |

|

| year={2023} |

|

| } |

|

| モデル日付 | Quilt-LlaVA-v1.5-7Bは、2023年11月に訓練されました。 |

| 詳細情報の論文やリソース | https://quilt-llava.github.io/ |

### ライセンス

Llama 2は、LLAMA 2 Community Licenseの下でライセンスされています。

Copyright (c) Meta Platforms, Inc. All Rights Reserved.

**モデルに関する質問やコメントを送信する場所**

https://github.com/quilt-llava/quilt-llava.github.io/issues

### 意図された用途

| 属性 | 详情 |

|------|------|

| 主な意図された用途 | Quilt-LlaVAの主な用途は、医学の大規模マルチモーダルモデルとチャットボットの研究です。 |

| 主な意図されたユーザー | これらのモデルの主な意図されたユーザーは、AI研究者です。主に、研究者が大規模なビジョン言語生成組織病理学モデルの堅牢性、汎化性、その他の能力、バイアス、制約をよりよく理解するために使用することを想定しています。 |

### 訓練データセット

- 723Kのフィルタリングされた画像テキストペアを、QUILT-1M https://quilt1m.github.io/ から使用。

- 107KのGPT生成マルチモーダル命令追従データを、QUILT-Instruct https://huggingface.co/datasets/wisdomik/QUILT-LLaVA-Instruct-107K から使用。

### 評価データセット

4つの学術的なVQA組織病理学ベンチマークのコレクション

## 📄 ライセンス

このモデルは、cc-by-nc-3.0のライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語