Swinv2 Large Patch4 Window12to24 192to384 22kto1k Ft

Swin Transformer v2是基于ImageNet-21k预训练并在384x384分辨率下对ImageNet-1k进行微调的视觉Transformer模型,具有分层特征图和局部窗口自注意力机制。

Downloads 3,048

Release Time : 6/16/2022

Model Overview

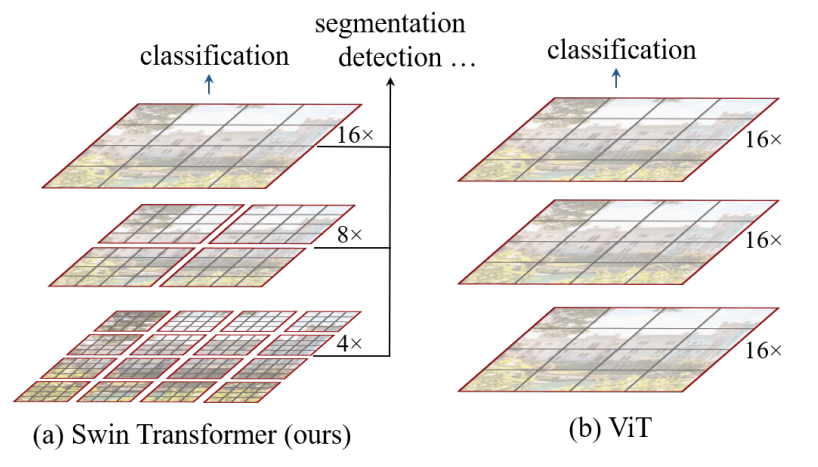

该模型主要用于图像分类任务,通过构建分层特征图和局部窗口自注意力机制,有效降低计算复杂度,适用于各种视觉识别任务。

Model Features

分层特征图

通过在更深层合并图像块构建分层特征图,适用于不同分辨率的图像处理。

局部窗口自注意力

仅在局部窗口内计算自注意力,计算复杂度与输入图像大小呈线性关系,提高效率。

训练稳定性改进

结合残差后归一化与余弦注意力,提高训练稳定性。

高分辨率迁移能力

采用对数间隔连续位置偏置方法,有效将低分辨率预训练模型迁移至高分辨率输入任务。

自监督预训练

引入SimMIM自监督预训练方法,减少对大量标注图像的需求。

Model Capabilities

图像分类

视觉特征提取

高分辨率图像处理

Use Cases

通用图像分类

ImageNet分类

将图像分类为1000个ImageNet类别之一。

高准确率的图像分类能力。

视觉识别

物体识别

识别图像中的特定物体,如动物、日常用品等。

准确识别多种常见物体。

Featured Recommended AI Models

Llama 3 Typhoon V1.5x 8b Instruct

专为泰语设计的80亿参数指令模型,性能媲美GPT-3.5-turbo,优化了应用场景、检索增强生成、受限生成和推理任务

大型语言模型 Transformers Supports Multiple Languages

Transformers Supports Multiple Languages

Transformers Supports Multiple Languages

Transformers Supports Multiple LanguagesL

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-Tiny是一个基于SODA数据集训练的超小型对话模型,专为边缘设备推理设计,体积仅为Cosmo-3B模型的2%左右。

对话系统 Transformers English

Transformers English

Transformers English

Transformers EnglishC

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

基于RoBERTa架构的中文抽取式问答模型,适用于从给定文本中提取答案的任务。

问答系统 Chinese

R

uer

2,694

98