🚀 文档理解模型(在DocLayNet基础数据集上按段落级别微调LayoutXLM基础模型)

该模型是基于 microsoft/layoutxlm-base 模型,使用 DocLayNet base 数据集进行微调得到的。在评估集上,该模型取得了以下结果:

- 损失值:0.1796

- 精确率:0.8062

- 召回率:0.7441

- F1值:0.7739

- 标记准确率:0.9693

- 段落准确率:0.8655

🚀 快速开始

本模型可用于文档理解任务,特别是段落级别的文档布局分析。你可以通过以下方式快速体验模型:

- 使用Hugging Face Spaces中的应用程序进行测试。

- 运行对应的Jupyter Notebook进行推理。

✨ 主要特性

- 多语言支持:支持多种语言的文档理解。

- 段落级分析:能够对文档进行段落级别的布局分析。

- 高精度:在评估集上取得了较高的准确率和F1值。

📚 详细文档

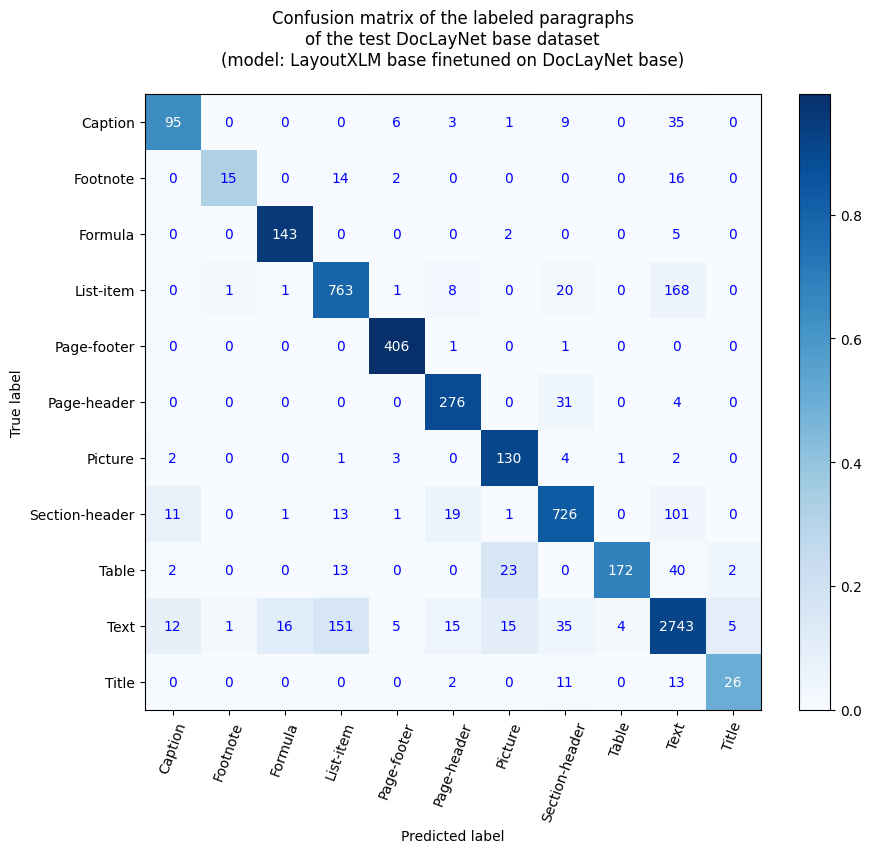

段落级准确率

- 段落准确率:86.55%

- 按标签分类的准确率

- 标题说明:63.76%

- 脚注:31.91%

- 公式:95.33%

- 列表项:79.31%

- 页面页脚:99.51%

- 页面页眉:88.75%

- 图片:90.91%

- 章节标题:83.16%

- 表格:68.25%

- 文本:91.37%

- 标题:50.0%

参考资料

博客文章

笔记本(段落级别)

笔记本(行级别)

应用程序

你可以使用Hugging Face Spaces中的这个应用程序测试该模型:段落级文档理解推理应用程序(v2)。

你也可以运行对应的笔记本:Document AI | 使用文档理解模型(在DocLayNet数据集上微调的LayoutXLM基础模型)进行段落级推理应用

DocLayNet数据集

DocLayNet数据集(IBM)为来自6个文档类别的80863个唯一页面,使用边界框为11个不同的类别标签提供了逐页布局分割的真实标注。

到目前为止,该数据集可以通过直接链接下载,也可以从Hugging Face数据集库获取:

论文:DocLayNet: A Large Human-Annotated Dataset for Document-Layout Analysis(2022年6月2日)

模型描述

该模型在段落级别,以512个标记块且重叠128个标记的方式进行微调。因此,模型使用了数据集中所有页面的布局和文本数据进行训练。

在推理时,通过计算最佳概率为每个段落边界框分配标签。

推理

请参考笔记本:Document AI | 使用文档理解模型(在DocLayNet数据集上微调的LayoutXLM基础模型)进行段落级推理

训练和评估数据

请参考笔记本:Document AI | 在任何语言的DocLayNet基础数据集上按段落级别(512个标记块,有重叠)微调LayoutXLM基础模型

训练过程

训练超参数

训练过程中使用了以下超参数:

- 学习率:2e-05

- 训练批次大小:8

- 评估批次大小:16

- 随机种子:42

- 优化器:Adam,β值=(0.9, 0.999),ε值=1e-08

- 学习率调度器类型:线性

- 学习率调度器热身比例:0.1

- 训练轮数:4

- 混合精度训练:原生自动混合精度(Native AMP)

训练结果

| 训练损失 |

轮数 |

步数 |

准确率 |

F1值 |

验证损失 |

精确率 |

召回率 |

| 无记录 |

0.11 |

200 |

0.8842 |

0.1066 |

0.4428 |

0.1154 |

0.0991 |

| 无记录 |

0.21 |

400 |

0.9243 |

0.4440 |

0.3040 |

0.4548 |

0.4336 |

| 0.7241 |

0.32 |

600 |

0.9359 |

0.5544 |

0.2265 |

0.5330 |

0.5775 |

| 0.7241 |

0.43 |

800 |

0.9479 |

0.6015 |

0.2140 |

0.6013 |

0.6017 |

| 0.2343 |

0.53 |

1000 |

0.9402 |

0.6132 |

0.2852 |

0.6642 |

0.5695 |

| 0.2343 |

0.64 |

1200 |

0.9540 |

0.6604 |

0.1694 |

0.6565 |

0.6644 |

| 0.2343 |

0.75 |

1400 |

0.9354 |

0.6198 |

0.2308 |

0.5119 |

0.7854 |

| 0.1913 |

0.85 |

1600 |

0.9594 |

0.6590 |

0.1601 |

0.7190 |

0.6082 |

| 0.1913 |

0.96 |

1800 |

0.9541 |

0.6597 |

0.1671 |

0.5790 |

0.7664 |

| 0.1346 |

1.07 |

2000 |

0.9612 |

0.6986 |

0.1580 |

0.6838 |

0.7140 |

| 0.1346 |

1.17 |

2200 |

0.9597 |

0.6897 |

0.1423 |

0.6618 |

0.7200 |

| 0.1346 |

1.28 |

2400 |

0.9663 |

0.6980 |

0.1580 |

0.7490 |

0.6535 |

| 0.098 |

1.39 |

2600 |

0.9616 |

0.6800 |

0.1394 |

0.7044 |

0.6573 |

| 0.098 |

1.49 |

2800 |

0.9686 |

0.7251 |

0.1756 |

0.6893 |

0.7649 |

| 0.0999 |

1.6 |

3000 |

0.9636 |

0.6985 |

0.1542 |

0.7127 |

0.6848 |

| 0.0999 |

1.71 |

3200 |

0.9670 |

0.7097 |

0.1187 |

0.7538 |

0.6705 |

| 0.0999 |

1.81 |

3400 |

0.9585 |

0.7427 |

0.1793 |

0.7602 |

0.7260 |

| 0.0972 |

1.92 |

3600 |

0.9621 |

0.7189 |

0.1836 |

0.7576 |

0.6839 |

| 0.0972 |

2.03 |

3800 |

0.9642 |

0.7189 |

0.1465 |

0.7388 |

0.6999 |

| 0.0662 |

2.13 |

4000 |

0.9691 |

0.7450 |

0.1409 |

0.7615 |

0.7292 |

| 0.0662 |

2.24 |

4200 |

0.9615 |

0.7432 |

0.1720 |

0.7435 |

0.7429 |

| 0.0662 |

2.35 |

4400 |

0.9667 |

0.7338 |

0.1440 |

0.7469 |

0.7212 |

| 0.0581 |

2.45 |

4600 |

0.9657 |

0.7135 |

0.1928 |

0.7458 |

0.6839 |

| 0.0581 |

2.56 |

4800 |

0.9692 |

0.7378 |

0.1645 |

0.7467 |

0.7292 |

| 0.0538 |

2.67 |

5000 |

0.9656 |

0.7619 |

0.1517 |

0.7700 |

0.7541 |

| 0.0538 |

2.77 |

5200 |

0.9684 |

0.7728 |

0.1676 |

0.8227 |

0.7286 |

| 0.0538 |

2.88 |

5400 |

0.9725 |

0.7608 |

0.1277 |

0.7865 |

0.7367 |

| 0.0432 |

2.99 |

5600 |

0.9693 |

0.7784 |

0.1532 |

0.7891 |

0.7681 |

| 0.0432 |

3.09 |

5800 |

0.9692 |

0.7783 |

0.1701 |

0.8067 |

0.7519 |

| 0.0272 |

3.2 |

6000 |

0.9732 |

0.7798 |

0.1159 |

0.8072 |

0.7542 |

| 0.0272 |

3.3 |

6200 |

0.9720 |

0.7797 |

0.1835 |

0.7926 |

0.7672 |

| 0.0272 |

3.41 |

6400 |

0.9730 |

0.7894 |

0.1481 |

0.8183 |

0.7624 |

| 0.0274 |

3.52 |

6600 |

0.9686 |

0.7655 |

0.1552 |

0.7958 |

0.7373 |

| 0.0274 |

3.62 |

6800 |

0.9698 |

0.7724 |

0.1523 |

0.8068 |

0.7407 |

| 0.0246 |

3.73 |

7000 |

0.9691 |

0.7720 |

0.1673 |

0.7960 |

0.7493 |

| 0.0246 |

3.84 |

7200 |

0.9688 |

0.7695 |

0.1333 |

0.7986 |

0.7424 |

| 0.0246 |

3.94 |

7400 |

0.1796 |

0.8062 |

0.7441 |

0.7739 |

0.9693 |

框架版本

- Transformers 4.27.3

- Pytorch 1.10.0+cu111

- Datasets 2.10.1

- Tokenizers 0.13.2

其他模型

📄 许可证

本项目采用MIT许可证。

Transformers Supports Multiple Languages

Transformers Supports Multiple Languages Transformers Supports Multiple Languages

Transformers Supports Multiple Languages Transformers English

Transformers English Transformers English

Transformers English