🚀 AI-Sweden-Models/Llama-3-8B

このモデルは、特定のユースケースに微調整可能なベースモデルです。

🚀 クイックスタート

このモデルはベースモデルであり、特定のユースケースに微調整することができます。

-----> 指示付きバージョンはこちら <-----

💻 使用例

基本的な使用法

import transformers

import torch

model_id = "AI-Sweden-Models/Llama-3-8B"

pipeline = transformers.pipeline(

task="text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device_map="auto"

)

pipeline(

text_inputs="Sommar och sol är det bästa jag vet",

max_length=128,

repetition_penalty=1.03

)

実行結果

>>> "Sommar och sol är det bästa jag vet!

Och nu när jag har fått lite extra semester så ska jag njuta till max av allt som våren och sommaren har att erbjuda.

Jag har redan börjat med att sitta ute på min altan och ta en kopp kaffe och läsa i tidningen, det är så skönt att bara sitta där och njuta av livet.

Ikväll blir det grillat och det ser jag fram emot!"

📚 ドキュメント

学習情報

AI-Sweden-Models/Llama-3-8B は、meta-llama/Meta-Llama-3-8B からの事前学習プロセスの続きです。

このモデルは、スウェーデン語、ノルウェー語、デンマーク語を含む The Nordic Pile のサブセットで学習されました。学習はすべてのモデルパラメータに対して行われ、完全な微調整です。

学習データセットは 227 105 079 296 トークンで構成されています。学習は、テキサス州オースティンの Dell Technologies Edge Innovation Center にある Rattler スーパーコンピュータで行われました。学習には 23 ノードを使用し、30 日間の期間で行われました。1 ノードには 4 台の Nvidia A100 GPU が含まれており、合計 92 台の GPU が使用されました。

trainer.yaml

learning_rate: 2e-5

warmup_steps: 100

lr_scheduler: cosine

optimizer: adamw_torch_fused

max_grad_norm: 1.0

gradient_accumulation_steps: 16

micro_batch_size: 1

num_epochs: 1

sequence_len: 8192

deepspeed_zero2.json

{

"zero_optimization": {

"stage": 2,

"offload_optimizer": {

"device": "cpu"

},

"contiguous_gradients": true,

"overlap_comm": true

},

"bf16": {

"enabled": "auto"

},

"fp16": {

"enabled": "auto",

"auto_cast": false,

"loss_scale": 0,

"initial_scale_power": 32,

"loss_scale_window": 1000,

"hysteresis": 2,

"min_loss_scale": 1

},

"gradient_accumulation_steps": "auto",

"gradient_clipping": "auto",

"train_batch_size": "auto",

"train_micro_batch_size_per_gpu": "auto",

"wall_clock_breakdown": false

}

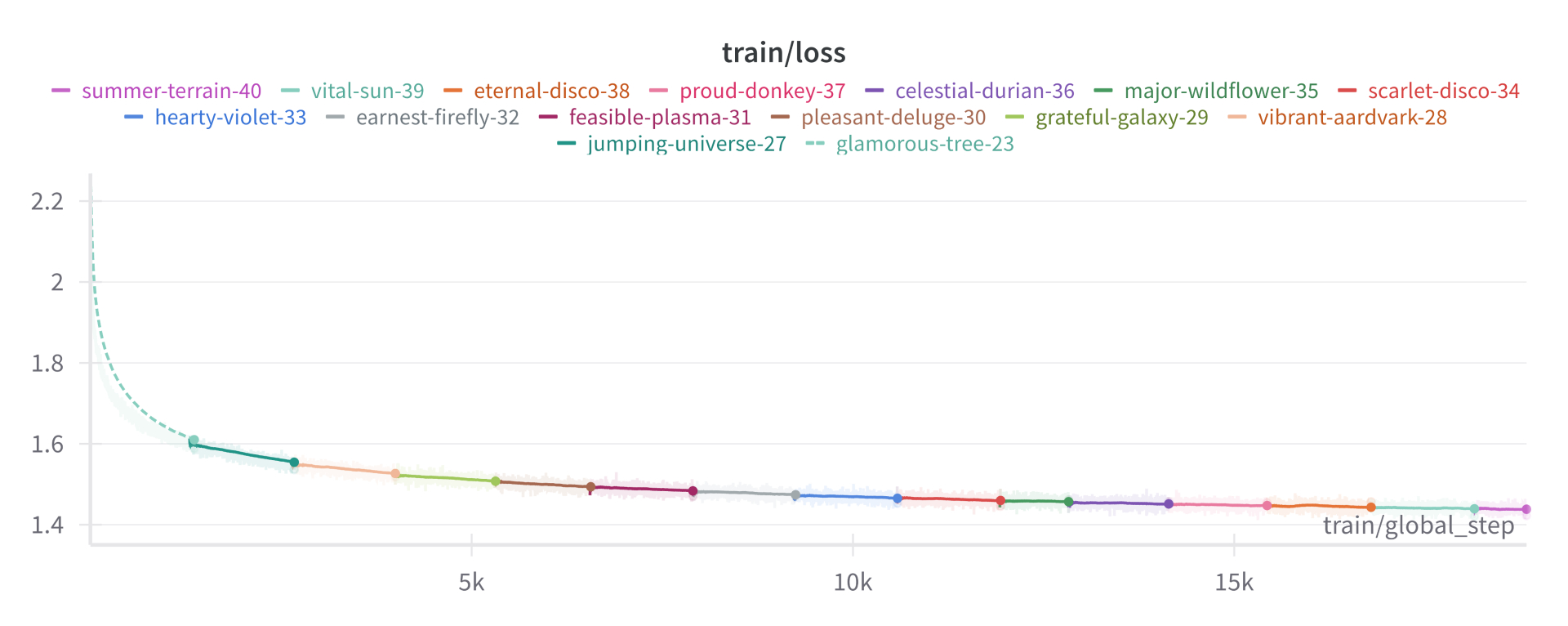

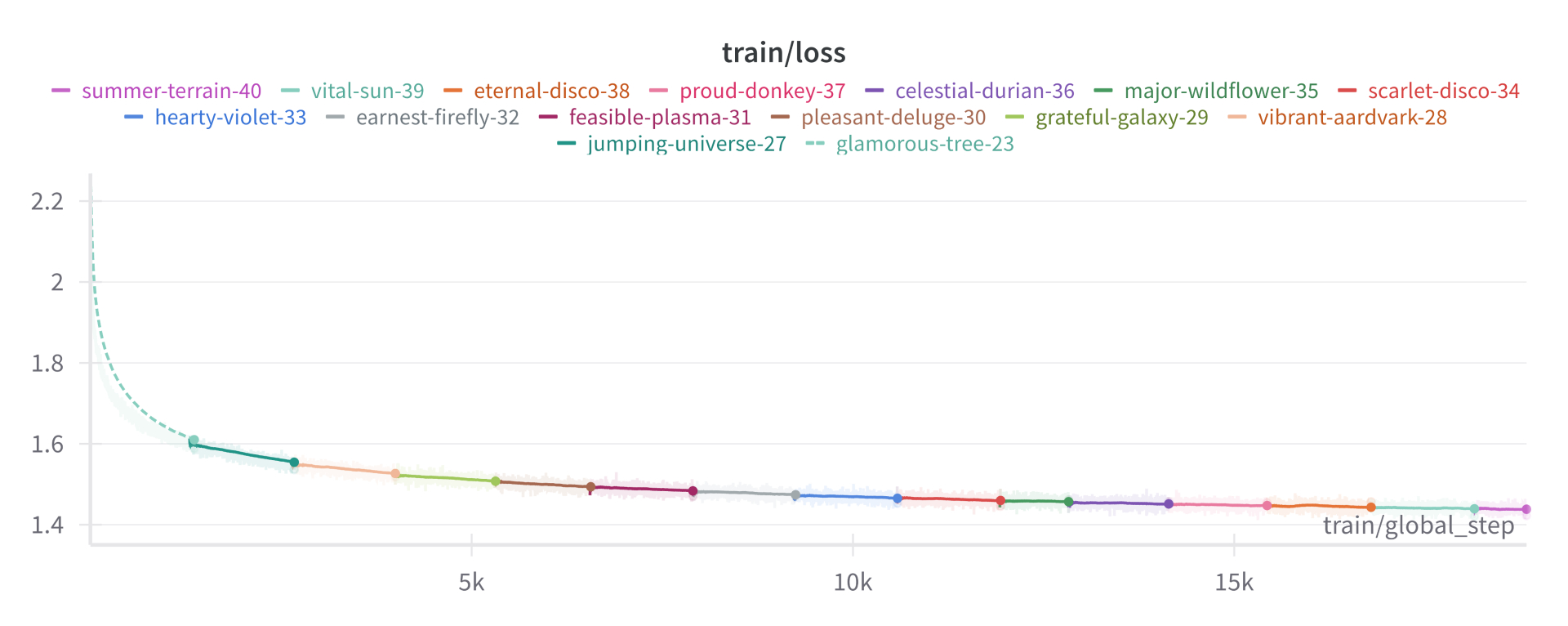

チェックポイント

- 2024年6月15日 (18833) => 1エポック

- 2024年6月11日 (16000)

- 2024年6月7日 (14375)

- 2024年6月3日 (11525)

- 2024年5月29日 (8200)

- 2024年5月26日 (6550)

- 2024年5月24日 (5325)

- 2024年5月22日 (3900)

- 2024年5月20日 (2700)

- 2024年5月13日 (1500)

📄 ライセンス

このモデルのライセンスは llama3 です。

その他の情報

| 属性 |

详情 |

| サポート言語 |

スウェーデン語、デンマーク語、ノルウェー語 |

| ベースモデル |

meta-llama/Meta-Llama-3-8B |

| パイプラインタグ |

テキスト生成 |

| 推論パラメータ |

温度: 0.6 |

| タグ |

pytorch, llama, llama-3, ai-sweden |

Transformers Supports Multiple Languages

Transformers Supports Multiple Languages Transformers Supports Multiple Languages

Transformers Supports Multiple Languages Transformers English

Transformers English Transformers English

Transformers English